Amazon ha lanzado una innovadora capacidad en su plataforma de inteligencia artificial, SageMaker AI, que permite afinar modelos GPT-OSS mediante las recetas de SageMaker HyperPod. Este avance forma parte de una serie de publicaciones centradas en la optimización del modelo GPT-OSS para manejar razonamientos estructurados en múltiples idiomas.

En la primera parte de esta serie, se detalló cómo afinar modelos GPT-OSS usando bibliotecas de código abierto de Hugging Face a través de entrenamientos en SageMaker. Ahora, las recetas de SageMaker HyperPod facilitan un inicio rápido y accesible para el ajuste fino de modelos fundamentales de inteligencia artificial, como Llama de Meta y Mistral. Estas recetas proporcionan configuraciones predefinidas que simplifican la creación de entornos de entrenamiento distribuidos, asegurando un rendimiento y escalabilidad de nivel empresarial.

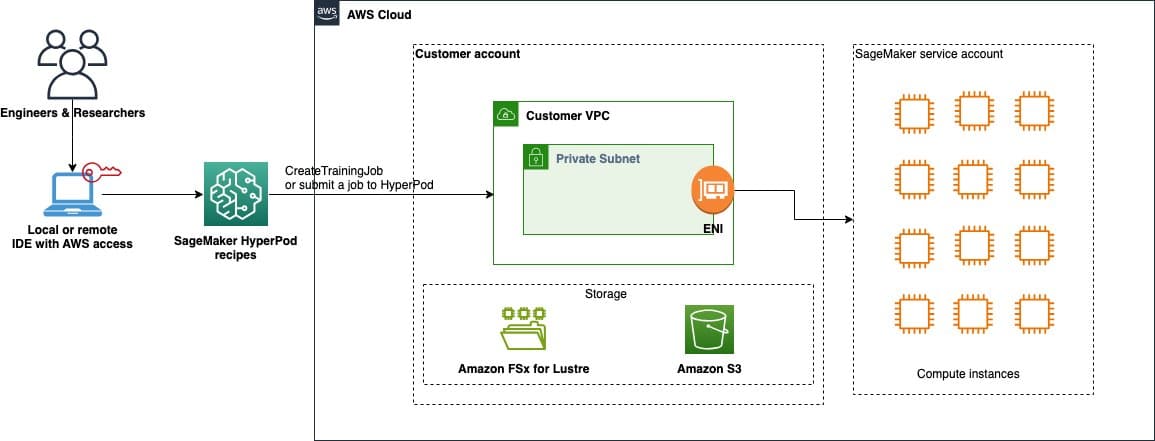

La solución se apoya en SageMaker HyperPod para ejecutar trabajos de ajuste fino, utilizando Amazon Elastic Kubernetes Service (EKS) para la orquestación. Se requiere una configuración inicial que incluye un entorno de desarrollo local con credenciales de AWS y diversas instancias, como ml.p5.48xlarge.

El ajuste fino comienza con la preparación de un conjunto de datos adecuado, en este caso, el dataset «HuggingFaceH4/Multilingual-Thinking», diseñado para ejemplos de razonamiento en varios idiomas. Tras la preparación y tokenización de los datos, las recetas someten el trabajo de ajuste fino y el modelo entrenado se implementa en un endpoint de SageMaker para pruebas y evaluación.

Expertos destacan que SageMaker no solo facilita la capacitación de modelos mediante recursos temporales, sino que también ofrece un entorno persistente para el desarrollo continuo con HyperPod. Esto permite a las organizaciones experimentar con modelos de forma más eficiente.

El despliegue de los modelos ajustados se realiza usando contenedores optimizados en Amazon Elastic Container Registry (ECR), asegurando que las aplicaciones tengan acceso a los recursos necesarios para ejecutar inferencias en tiempo real. SageMaker traduce configuraciones y prepara variables para un rendimiento óptimo.

En resumen, esta nueva funcionalidad abre una prometedora vía para que organizaciones de todos los tamaños aprovechen el potencial de los modelos de lenguaje grande, haciendo que el ajuste y despliegue de modelos personalizados sean más accesibles y manejables. Las guías y recursos están disponibles en los repositorios de GitHub de Amazon, ofreciendo ejemplos y documentación detallada para los desarrolladores interesados.