La creciente demanda de tecnologías avanzadas en inteligencia artificial (IA) ha impulsado a las organizaciones a buscar métodos más efectivos para evaluar y optimizar los modelos de lenguaje de gran tamaño (LLM). Para enfrentar este desafío, ha surgido un nuevo marco denominado «LLM-as-a-judge», que está transformando la manera en que las empresas calibran el rendimiento de sus modelos de IA. Este innovador enfoque promete simplificar la evaluación, facilitando a las compañías obtener una mirada más precisa sobre la eficacia de sus modelos y asegurando que estos se alineen con sus objetivos estratégicos.

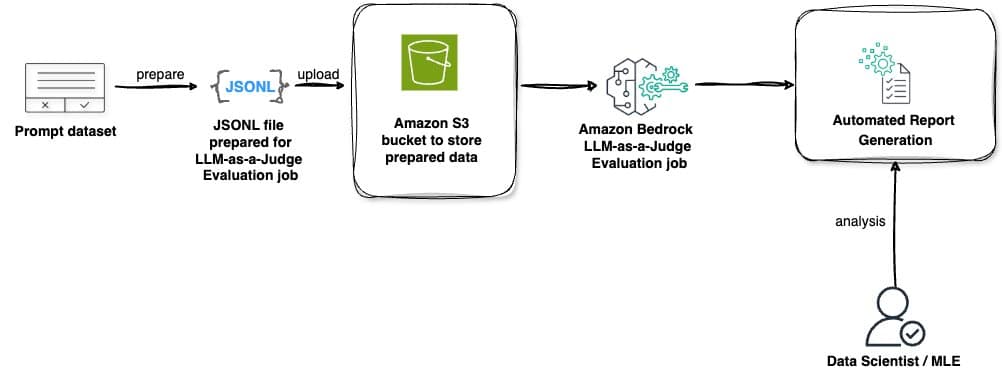

En un movimiento que marca un hito en la industria, Amazon Bedrock, plataforma pionera en administración de IA, ha integrado el método «LLM-as-a-judge» dentro de sus capacidades de evaluación. Esta implementación tiene como objetivo ofrecer a sus usuarios una evaluación exhaustiva y eficiente a través de una única API que reúne modelos de alto rendimiento de renombradas empresas de IA.

Las nuevas funcionalidades lanzadas por Amazon Bedrock incluyen la Evaluación de Modelos de Amazon Bedrock y la evaluación RAG para sus Bases de Conocimiento. Ambas utilizan la técnica «LLM-as-a-judge» para proporcionar un análisis detallado de diferentes aspectos críticos de rendimiento. Estas características ofrecen un marco exhaustivo para configurar evaluaciones, iniciar procesos a través de la consola de Amazon Web Services (AWS) y APIs de Python, abriendo nuevas posibilidades para mejorar las aplicaciones de IA generativa.

El método «LLM-as-a-judge» destaca por su capacidad para automatizar la evaluación, alcanzando niveles de precisión comparables a los humanos y reduciendo costos significativamente, hasta un 98%. Esta metodología abarca áreas clave, incluyendo calidad de respuestas, experiencia del usuario, cumplimiento de instrucciones y seguridad, permitiendo a las empresas abordar de manera holística la evaluación de sus modelos.

La adopción de «LLM-as-a-judge» no solo garantiza un enfoque riguroso y confiable hacia la evaluación de IA, sino que también asegura que las aplicaciones de inteligencia artificial se desplieguen de manera efectiva conforme a los estándares de calidad y seguridad exigidos por cada organización. Al implementar esta herramienta, las compañías pueden seguir innovando en sus áreas operativas, manteniendo a su vez un alto grado de responsabilidad y precisión en el uso de tecnologías de IA avanzadas.

En última instancia, esta solución no solo transformará la forma en que las organizaciones evalúan sus modelos, sino que también potenciará el desarrollo de aplicaciones de IA más seguras, confiables y alineadas con los objetivos estratégicos empresariales, redefiniendo así el futuro de la inteligencia artificial en el mundo corporativo.