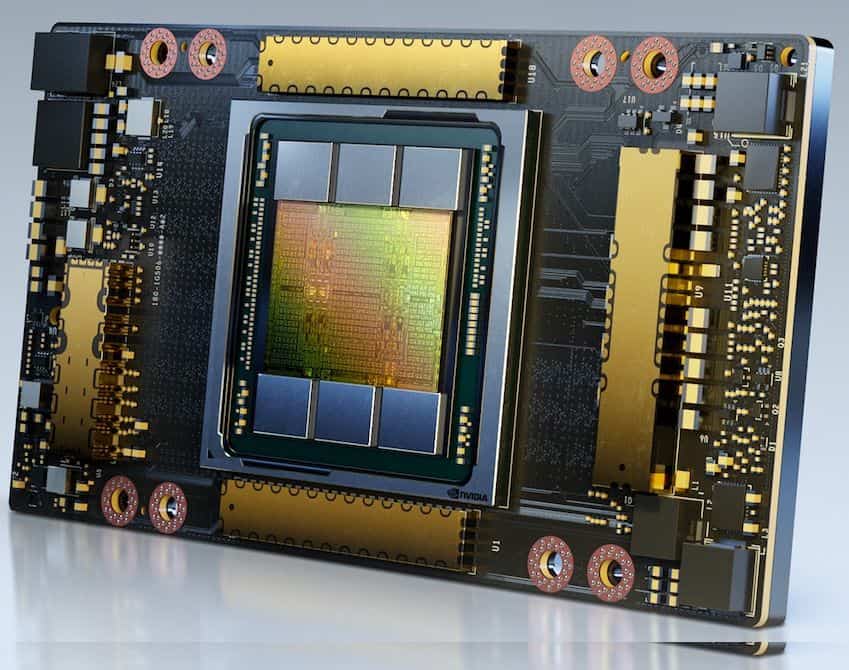

Amazon Web Services (AWS) ha confirmado lo que muchos en la industria tecnológica ya sospechaban: la obsolescencia no siempre es una opción en un mercado dominado por la alta demanda de unidades de procesamiento gráfico (GPU). Bajo la conducción de su CEO, Matt Garman, AWS sigue operando servidores impulsados por las Nvidia A100, una GPU lanzada en 2020, y afirma no haber retirado ninguna de estas unidades, en respuesta a la incapacidad de la oferta para satisfacer la creciente demanda del mercado.

Durante un reciente encuentro de la industria, Garman habló con franqueza junto a Jeetu Patel de Cisco sobre la intensa presión por capacidad que ha resultante en la continuidad de demanda de chips clasificados por algunos como «obsoletos». A pesar de ser una generación anterior comparada con sus sucesoras H100 y H200, la A100 sigue siendo ampliamente utilizada en aplicaciones desde procesamiento intensivo de datos hasta entrenamiento de modelos de inteligencia artificial que no requieren los últimos avances tecnológicos. AWS revela que sus instancias basadas en A100 están completamente vendidas, reflejando un cambio en la industria: ahora, la disponibilidad y el uso dictan el ritmo, por encima del calendario de actualizaciones tecnológicas.

El surgimiento de la inteligencia artificial ha transformado las consideraciones tradicionales sobre el hardware, extendiendo la vida útil de dispositivos que siguen garantizando resultados. Las GPU que puedan proporcionar un rendimiento eficiente siguen siendo indispensables. Esto también queda reflejado en la estrategia de Google, que según Amin Vahdat, vicepresidente de infraestructura, mantiene operativas siete generaciones de procesadores TPU, incluidos aquellos con hasta ocho años de antigüedad. La continuidad es clave cuando la demanda excede con creces la oferta y la precisión es crucial en aplicaciones como simulaciones y modelos financieros.

El mercado de GPU, por tanto, no se rige únicamente por la velocidad de actualización hacia la última tecnología, sino por la maximización del rendimiento y la eficiencia del hardware existente. La reducción de un 33 % en el costo de instancias A100 prevista para junio de 2025 por AWS apunta a un intento de exprimir al máximo el hardware amortizado, incentivando su uso en un entorno donde la capacidad instalada es un recurso valioso en medio de la escasez.

Para empresas y desarrolladores, planificar la infraestructura de inteligencia artificial en la nube se ha convertido en un ejercicio complejo. Las decisiones ahora deben considerar la disponibilidad real del hardware, la compatibilidad, los costos totales y los riesgos de dependencia. Las inclemencias del mercado tecnológico actual obligan a replantearse no solo qué se usa, sino cómo optimizar el uso de cada recurso disponible. Este nuevo enfoque desafía la idea de que solo la última tecnología garantiza la ventaja competitiva, mostrando un panorama donde la innovación también se mide por la eficiencia y el rendimiento sostenido de generaciones pasadas.