En la era moderna, muchas empresas se encuentran enfrentando un desafío particular en su proceso de adopción de la inteligencia artificial (IA). Este desafío se manifiesta en una dualidad clara: por un lado, existen iniciativas oficialmente aprobadas, como asociaciones estratégicas con empresas especializadas en IA y proyectos piloto liderados por importantes proveedores. Sin embargo, detrás de esta fachada oficial, los ingenieros desencadenan una serie de transformaciones, conectando aplicaciones de IA a datos de negocios y herramientas de software como servicio (SaaS) mediante protocolos específicos.

En un contexto donde la seguridad de los sistemas empresariales actúa como un muro infranqueable, muchos empleados exploran la IA desde sus hogares, utilizando herramientas de código abierto que no pueden integrar con facilidad en las plataformas corporativas. Así, recurren a aplicaciones de IA «no oficiales» para cumplir con sus responsabilidades antes de transferir los resultados a los sistemas reconocidos por sus compañías.

La narrativa común en el sector empresarial refleja un desencanto con el retorno de la inversión en IA, un nerviosismo en cuestiones de seguridad y una confusión sobre cuál es el principal problema empresarial a abordar. Sin embargo, como se destacó en una reciente cumbre en Boston, si el cliente siempre representa un obstáculo, el problema podría estar en una perspectiva interna.

Este marco plantea un problema aún más profundo: la desincronización entre el interés por la IA autónoma y las estructuras de gobernanza e infraestructura que no fueron diseñadas para tal innovación. Es precisamente en este contexto en el que Barndoor AI, liderada por Oren Michels, encuentra su razón de ser. La empresa aspira a equipar a las organizaciones con sistemas autónomos sin comprometer los estándares de seguridad, cumplimiento normativo o integridad operativa.

Durante la Generative AI Summit en Boston, un panel conformado por Oren Michels y Quentin Hardy de LGTM LLC exploró esta tensión inherente en la adopción responsable de IA. El debate resaltó que el verdadero problema no yace en la capacidad de los modelos de IA, sino en la falta de control, visibilidad y confianza. Sin estas características, el avance en IA podría resultar estéril.

El análisis también puso de relieve cómo la industria está inundada de terminología técnica que no transmite claramente a los encargados de finanzas y operaciones los problemas que realmente abordan ni los costos que implican. En un espacio saturado con plataformas de IA complejas, las pequeñas y medianas empresas buscan un refugio seguro para experimentar, descubriendo cuáles ideas pueden adaptarse a sus necesidades particulares.

El fenómeno del «Shadow AI», comparable a la introducción inicial de smartphones y servicios en la nube, se erige como un recordatorio contundente. Los empleados, en su búsqueda por soluciones eficientes, podrían superar las fronteras establecidas por las organizaciones, promoviendo la innovación pero también incrementando los riesgos, como los de filtración de datos.

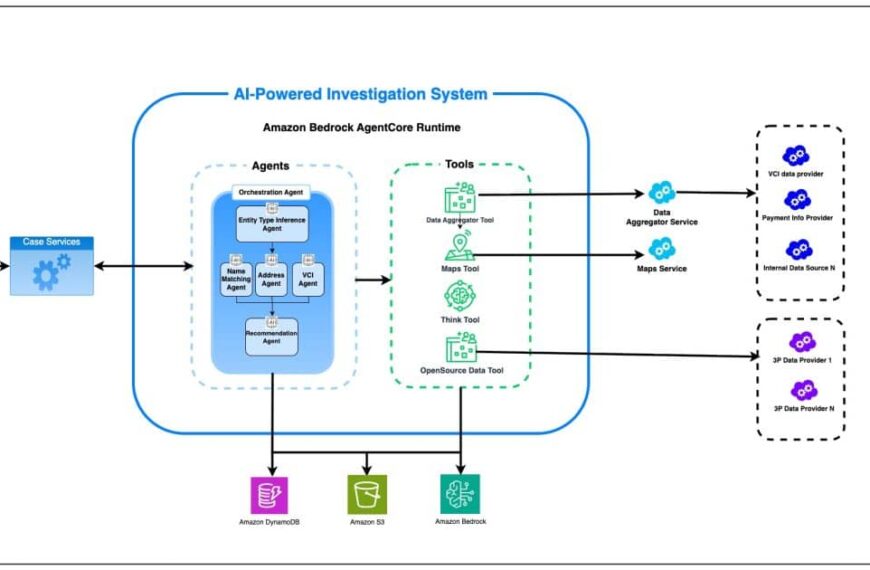

Frente a este desafío, Barndoor propone sistemas de gobernanza como vehículos de crecimiento, capaces de permitir el ensayo de nuevas ideas sin incurrir en vulnerabilidades. La compañía destaca la importancia de un «plano de control» que dote a los agentes de IA de la capacidad de operar con seguridad y eficacia, al tiempo que asegura visibilidad y gobernanza.

El propósito primordial es innegable: las empresas deben implementar estructuras que no solo faciliten un entorno seguro para la IA, sino que también estimulen la innovación sin ser obstaculizadas por la maquinaria burocrática. Esta visión sugiere un ecosistema donde la experimentación ocurre al abrigo de una gobernanza eficaz y una infraestructura robusta, relegando los miedos en torno a la IA a meras sombras del pasado.