Los modelos de lenguaje de gran tamaño (LLMs) han avanzado rápidamente, consolidándose como elementos esenciales en aplicaciones que van desde la inteligencia conversacional hasta tareas complejas de razonamiento. Sin embargo, la escalada en tamaño y capacidad de estos modelos ha complicado su evaluación efectiva. Las métricas tradicionales, como la perplejidad y los puntajes BLEU, no alcanzan a reflejar las sutilezas de las interacciones reales, lo que hace vitales los marcos de evaluación alineados con criterios humanos para garantizar comparaciones justas y despliegues fiables.

Recientemente, ha ganado terreno la evaluación automatizada mediante LLMs como jueces. Este método utiliza un modelo más potente para evaluar y clasificar las respuestas de otros modelos, considerando aspectos como corrección, coherencia, utilidad o profundidad del razonamiento. Esta técnica es popular por su escalabilidad, consistencia y eficiencia de costos frente a las evaluaciones exclusivamente humanas.

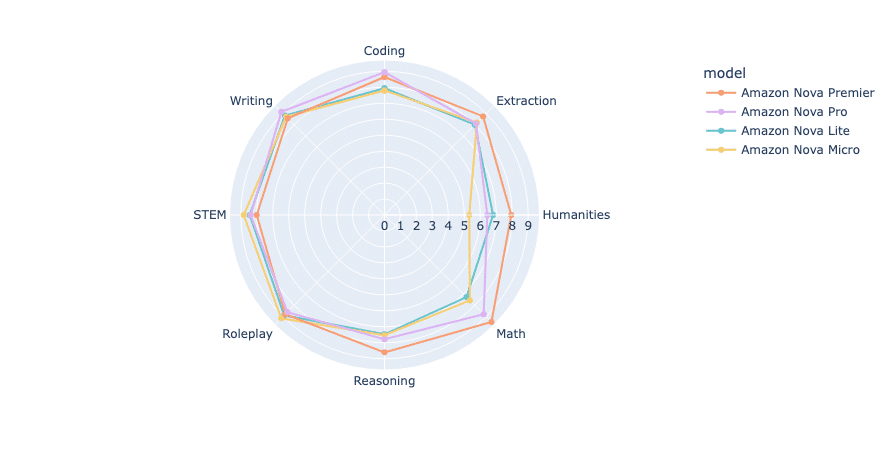

El análisis utiliza MT-Bench y Arena-Hard, dos marcos de evaluación reconocidos. MT-Bench se centra en interacciones tipo chatbot, mientras que Arena-Hard clasifica los modelos a través de enfrentamientos directos en tareas complejas. Ambos marcos buscan equilibrar la evaluación automática y humana, asegurando que los modelos no solo se evalúen mediante métricas sintéticas, sino también en escenarios prácticos.

El estudio se enfocó en los modelos de la familia Amazon Nova, destacando a Amazon Nova Premier, introducido recientemente en AWS re:Invent 2024. Estos modelos están diseñados para proporcionar inteligencia de alto nivel con un enfoque en la rentabilidad, desde Amazon Nova Micro para despliegues al borde, hasta Amazon Nova Premier para tareas más complejas.

A través de Amazon Bedrock, los clientes pueden destilar modelos Nova Premier en versiones más rápidas y económicas como Nova Pro o Nova Lite, adecuadas para dominios específicos. Este proceso se realiza a través de la consola de Amazon Bedrock y APIs como Converse e Invoke.

Los resultados de MT-Bench y Arena-Hard demuestran una jerarquía clara de rendimiento entre los modelos Nova. Amazon Nova Premier obtuvo el puntaje más alto, seguido de Nova Pro, mientras que Nova Lite y Nova Micro también lograron resultados destacados. Nova Premier mostró una eficiencia de token superior, generando respuestas concisas que consumen menos recursos.

Arena-Hard-Auto, utilizando 500 indicaciones desafiantes, evalúa el rendimiento mediante comparaciones en pares, ofreciendo un análisis detallado de las capacidades de los modelos en función de múltiples categorías.

El estudio concluye que los modelos Amazon Nova son competitivos, ofreciendo un rendimiento robusto en diversas tareas con costos operativos bajos. Esto los convierte en una opción atractiva para empresas que buscan optimizar la eficiencia sin sacrificar calidad, resaltando la importancia de metodologías de evaluación en el uso real de modelos LLM.