En la era de la automatización, los agentes de inteligencia artificial (IA) están emergiendo como piezas clave en la atención al cliente de diversas industrias, permitiendo no solo la automatización de tareas, sino también la optimización operativa y la mejora de la toma de decisiones. Sin embargo, para integrarlos eficazmente en los sistemas de producción, es indispensable contar con métodos de evaluación escalables que garanticen un rendimiento óptimo y seguro.

Amazon Bedrock Agents se destaca en este ámbito al emplear modelos de base disponibles en Amazon Bedrock. Utilizando APIs y datos, estos agentes desglosan solicitudes, recopilan información relevante y ejecutan tareas de manera eficiente. Esto libera a los equipos para focalizarse en actividades de mayor valor, permitiendo automatizar procesos complejos en múltiples pasos.

Otra herramienta clave en este ecosistema es Ragas, una librería de código abierto que facilita la prueba y evaluación de aplicaciones de modelos de lenguaje grande (LLM), especialmente en la generación aumentada por recuperación (RAG). En evaluaciones recientes, Ragas se utilizó para medir la efectividad de los agentes de Amazon Bedrock en sus capacidades RAG.

El enfoque LLM-as-a-judge es otro elemento crucial, empleando modelos de lenguaje para evaluar imparcialmente la calidad de las salidas generadas por la IA. Este método se aplicó para analizar las aptitudes de conversión de texto a SQL y el razonamiento en cadena de los agentes de Amazon.

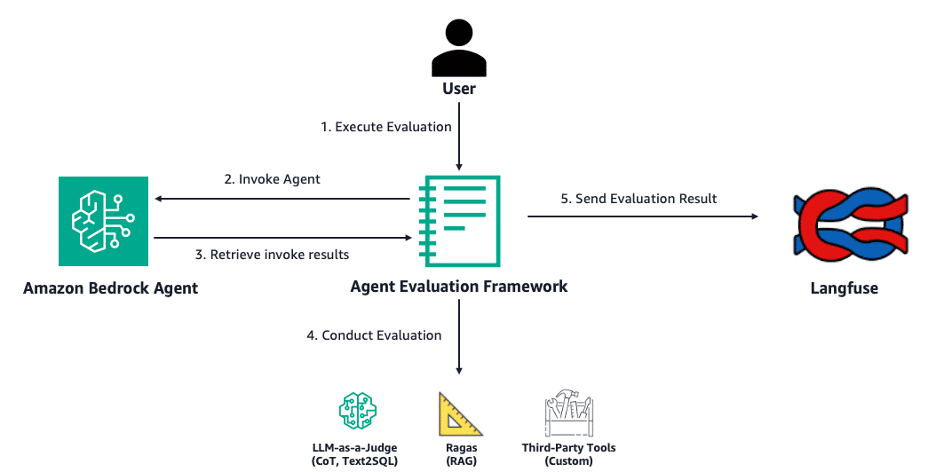

Langfuse, plataforma de ingeniería LLM de código abierto, amplía las herramientas disponibles ofreciendo trazas, evaluaciones, gestión de solicitudes y métricas que optimizan aplicaciones basadas en LLM. Esto es complementado por un marco de evaluación de agentes Bedrock, también de código abierto, que permite analizar el rendimiento en tareas específicas y visualizar datos mediante paneles en Langfuse.

A pesar de los avances, los desarrolladores enfrentan desafíos técnicos significativos. La gestión de experimentos y la evaluación end-to-end son complejas, dadas las múltiples configuraciones posibles de los agentes de Bedrock. Para abordar estas dificultades, el marco de Open Source Bedrock Agent Evaluation facilita el proceso al permitir la especificación y evaluación de agentes mediante la generación de trazas para su análisis posterior.

Este avance tecnológico tiene particular importancia en áreas como la investigación farmacéutica, donde agentes diseñados para colaborar en el análisis de biomarcadores juegan un papel crucial. La capacidad de descubrir información clave en investigaciones médicas subraya la necesidad de herramientas de evaluación efectivas, asegurando no solo la eficacia de los agentes, sino también su confiabilidad y seguridad en entornos críticos.