La manera en que los usuarios descubren y consumen información en Internet está experimentando un cambio significativo, aunque silencioso. Esto va más allá del simple posicionamiento en buscadores; ahora, una parte creciente de los contenidos se filtra a través de asistentes, resúmenes automáticos y agentes de Inteligencia Artificial. Estos agentes de IA «leen» las páginas para responder preguntas, comparar opciones o ejecutar tareas, transformando el panorama digital. Este cambio plantea una pregunta crucial para cualquier editor, marca o negocio: ¿está mi página web preparada para ser interpretada por máquinas sin perder contexto, matices o datos relevantes?

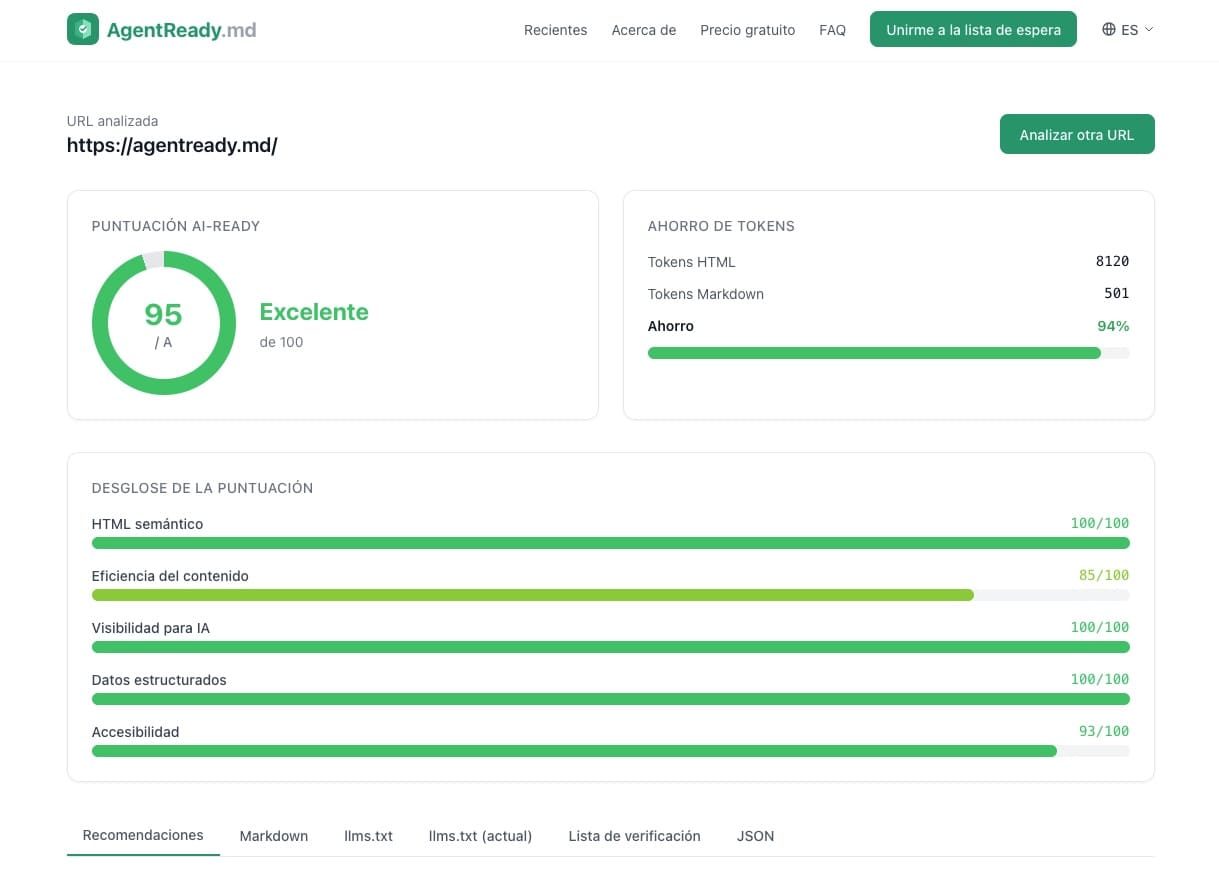

Este es el fondo sobre el que emerge AgentReady.md, una herramienta gratuita en línea que analiza una URL y devuelve una puntuación de «AI-readiness» en segundos. Este análisis incluye recomendaciones priorizadas, una conversión a Markdown y una guía paso a paso con fragmentos listos para implementar. Actualmente en fase beta, limita su uso a un máximo de cinco análisis por hora, enfatizando su propósito como herramienta práctica más que una herramienta de auditoría masiva para grandes empresas.

La filosofía detrás de esta herramienta señala un cambio de mentalidad, pasando del tradicional enfoque en optimización para motores de búsqueda (SEO) a uno en el que la legibilidad por agentes es clave. Durante años, el SEO se centró en elementos como títulos, estructura, enlaces internos y datos estructurados. Por su parte, los agentes de IA operan bajo un enfoque diferente, centrado en extraer el contenido principal, reducir el ruido y determinar qué es relevante para una tarea específica. Esto introduce el concepto de eficiencia del contenido, donde es crucial minimizar el «relleno técnico» que una IA debe procesar.

El análisis de AgentReady.md utiliza un flujo sencillo: primero, el usuario introduce una URL, que la herramienta analiza en términos de estructura. Después, calcula una puntuación basada en cinco dimensiones y 21 comprobaciones, y finalmente sugiere mejoras específicas con acciones prácticas para implementar.

Las cinco dimensiones en las que AgentReady.md divide el «AI-readiness» incluyen el uso adecuado del HTML semántico, la eficiencia del contenido, la descubribilidad para IA, los datos estructurados y la accesibilidad. Estas dimensiones destacan los problemas frecuentes a los que se enfrentan muchas webs sin saberlo.

Un elemento particular de interés es el archivo llms.txt, un estándar emergente similar al robots.txt, pero diseñado para agentes de IA. Este archivo actúa como un índice en Markdown que guía a los agentes hacia las páginas clave, permitiendo una comunicación más clara y directa con estos consumidores automáticos.

El contexto de este cambio se enmarca también en iniciativas como la de Cloudflare, que aboga por el uso de Markdown para agentes, optimizando así la relación entre el HTML tradicional y el contenido que estos agentes consumen. Este enfoque se basa en la negociación de contenido, donde el HTML se convierte a Markdown, reduciendo significativamente el número de tokens necesarios para el procesamiento automático.

AgentReady.md se presenta como una herramienta útil para medir barreras y mejorar la legibilidad de las webs frente a agentes de IA, ofreciendo beneficios tangibles sin necesidad de reconstruir completamente un sitio web. Esto permite a las webs mejorar su estructura, limpiar el ruido y reforzar los metadatos, facilitando una comunicación más eficiente con agentes de IA. Este enfoque incremental puede ser más realista para muchos proyectos que intentar rehacer un sitio desde cero.