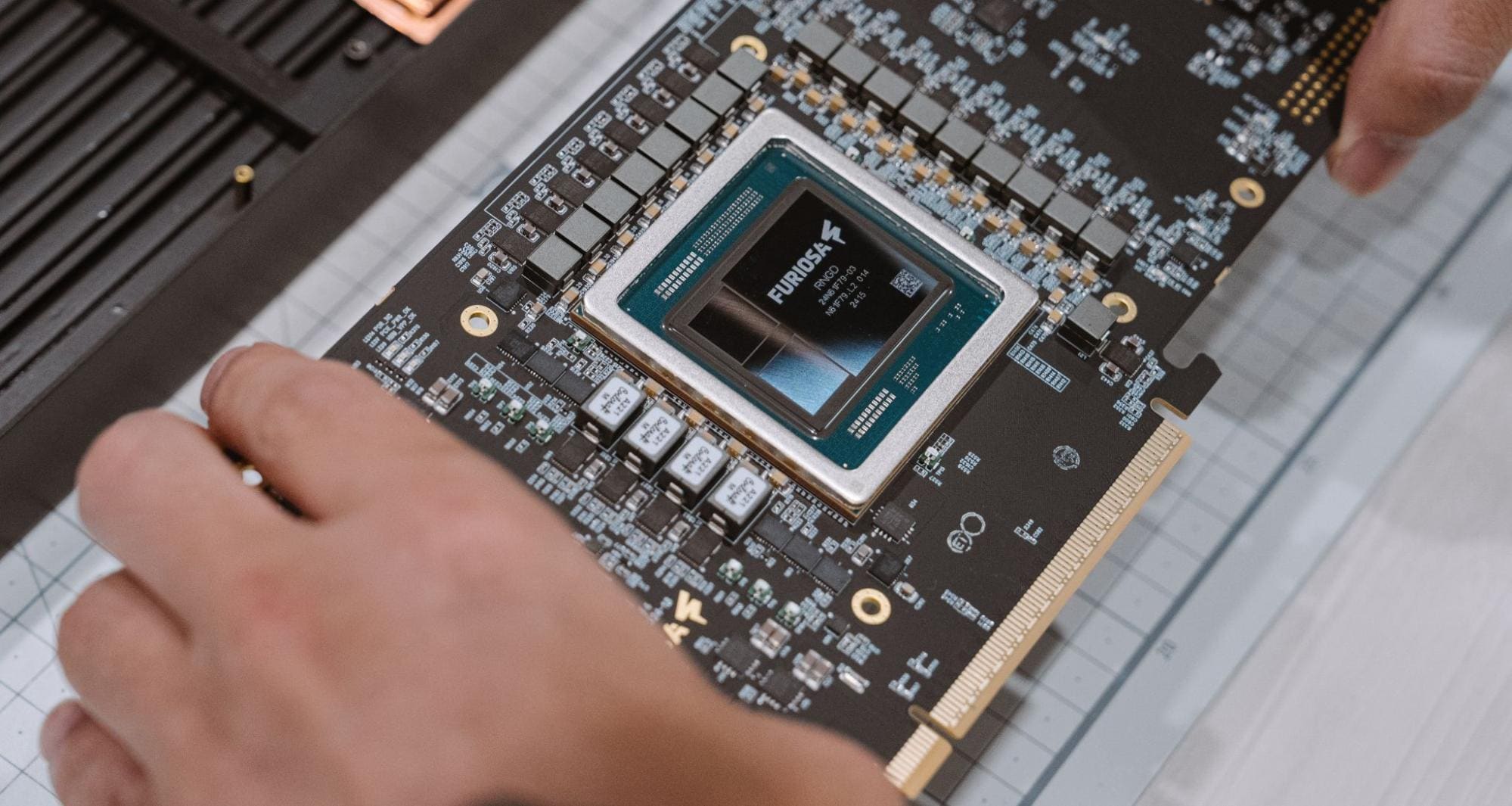

En un giro estratégico hacia la eficiencia y escalabilidad en el ámbito del aprendizaje profundo, FuriosaAI ha presentado el Tensor Contraction Processing (TCP), un nuevo enfoque en el desarrollo de chips de inteligencia artificial que podría redefinir las arquitecturas existentes. En una serie de conferencias de prestigio, incluidos eventos como Hot Chips Conference, AI Hardware Summit y PyTorch Conference, los ingenieros de la compañía, Younggeun Choi y Junyoung Park, han compartido detalles sobre cómo TCP se diferencia de las tradicionales matrices sistólicas.

Las matrices sistólicas han sido una piedra angular en la aceleración de IA, gracias a su capacidad para manejar multiplicaciones de matrices—un componente esencial en el aprendizaje profundo—de forma extremadamente eficiente. Sin embargo, su diseño rígido presenta limitaciones notables, tales como dimensiones fijas que pueden llevar a desperdicio de recursos cuando las cargas no coinciden con el tamaño de la matriz, y patrones de flujo de datos predefinidos que limitan su adaptabilidad ante tensores de diversas formas.

Aquí es donde entra TCP, introduciendo innovaciones clave en flexibilidad y eficiencia. A diferencia de la estructura fija de las matrices sistólicas, TCP ofrece una configuración dinámica de unidades de cómputo, lo que permite reconfigurar sus componentes según el tamaño del tensor, optimizando así la utilización de recursos. Este enfoque no solo aumenta la eficiencia sino que también mejora drásticamente el manejo del movimiento de datos, gracias a una red de búsqueda que distribuye los datos de manera más eficaz entre las unidades de procesamiento.

Además, TCP trata los tensores de manera nativa, eliminando la necesidad de convertir operaciones tensoriales en matrices 2D, lo que facilita la optimización de modelos de IA emergentes, como los futuros Llama 2 y Llama 3. Uno de los problemas más críticos en la IA es el consumo energético, y TCP enfrenta este desafío maximizando la reutilización de datos dentro de los buffers internos, reduciendo la energía consumida por el acceso a la memoria externa.

Comparado con las GPUs, que dominan actualmente la aceleración de IA pero que presentan cierta ineficiencia, TCP emerge como una alternativa más eficiente. Las GPUs suelen requerir conversión de datos multidimensionales a matrices 2D, lo que incrementa la sobrecarga y reduce el paralelismo; TCP evita esto al mantener las estructuras tensoriales. Además, el consumo energético del chip de FuriosaAI es significativamente menor que el de las GPUs de alto rendimiento, un factor crucial en la carrera por la eficiencia energética en la IA.

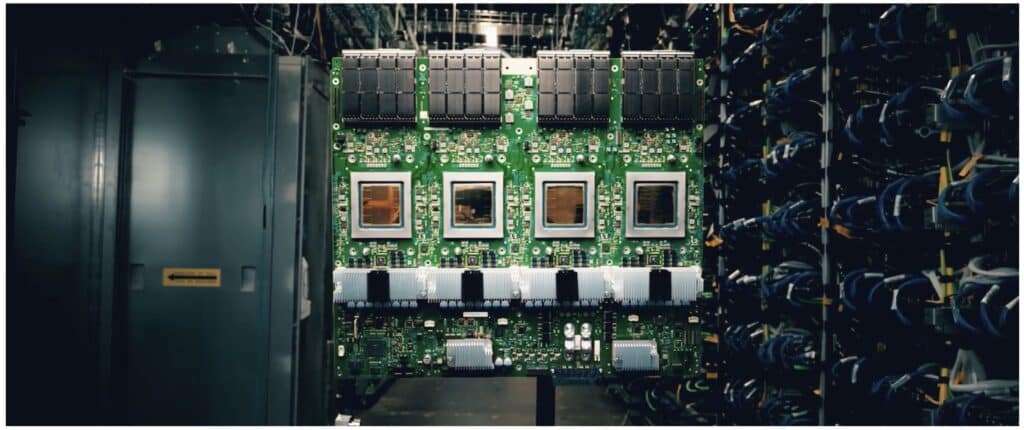

La innovación en el hardware de IA está impulsando un movimiento hacia chips más especializados que superen las limitaciones de soluciones de propósito general como las GPUs. Con gigantes tecnológicos como Google, Meta y Amazon aventurándose en el diseño de sus propios aceleradores de IA, el TCP de FuriosaAI se perfila como una propuesta atractiva. La posible adquisición de FuriosaAI por parte de Meta refuerza la tendencia hacia la implementación de aceleradores internos.

En conclusión, el TCP de FuriosaAI representa un avance significativo en el ámbito del hardware de IA, prometiendo no solo superar las limitaciones de las matrices sistólicas y GPUs, sino también establecer nuevas normas en eficiencia y adaptabilidad. Si bien es improbable que las GPUs sean completamente desplazadas, TCP se posiciona como un actor clave en la próxima generación de tecnología de aceleración de inteligencia artificial.