Google Cloud ha dado un paso adelante significativo en el ámbito de la inteligencia artificial con el lanzamiento de su séptima generación de TPUs, llamada Ironwood, y las nuevas instancias Axion basadas en ARM Neoverse. Este desarrollo refleja un cambio en el enfoque hacia la necesidad de ofrecer inferencias rápidas, económicas y gestionadas adecuadamente, además de demostrar avances en el ámbito del silicio a medida y el co-diseño de sistemas integrados.

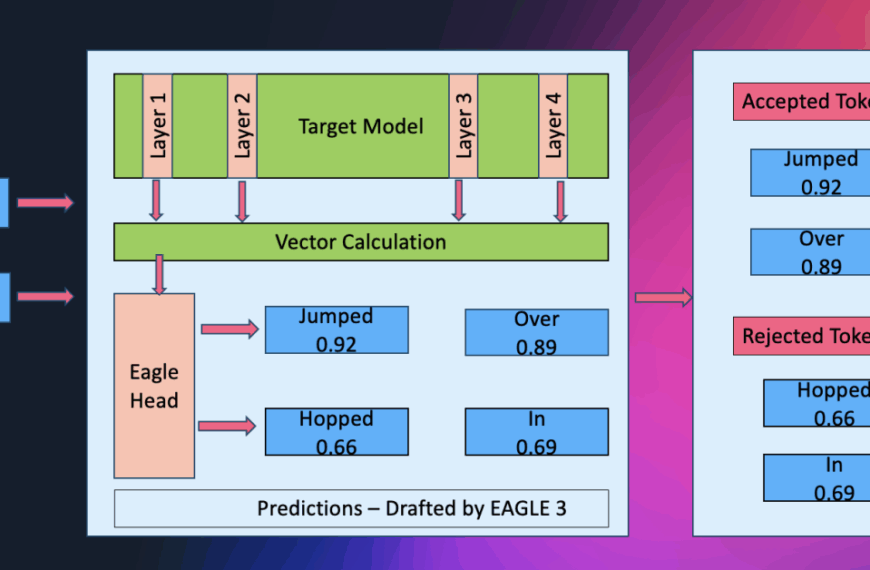

La presentación de Ironwood pone de manifiesto la capacidad de Google para operar modelos generativos de punta con latencia mínima y la elasticidad de un data center completo. Esta nueva generación de TPUs ofrece un rendimiento de hasta diez veces superior al de la versión anterior, lo que subraya la importancia de mejorar el ancho de banda, la memoria efectiva y la conectividad entre chips para soportar agentes operativos a gran escala.

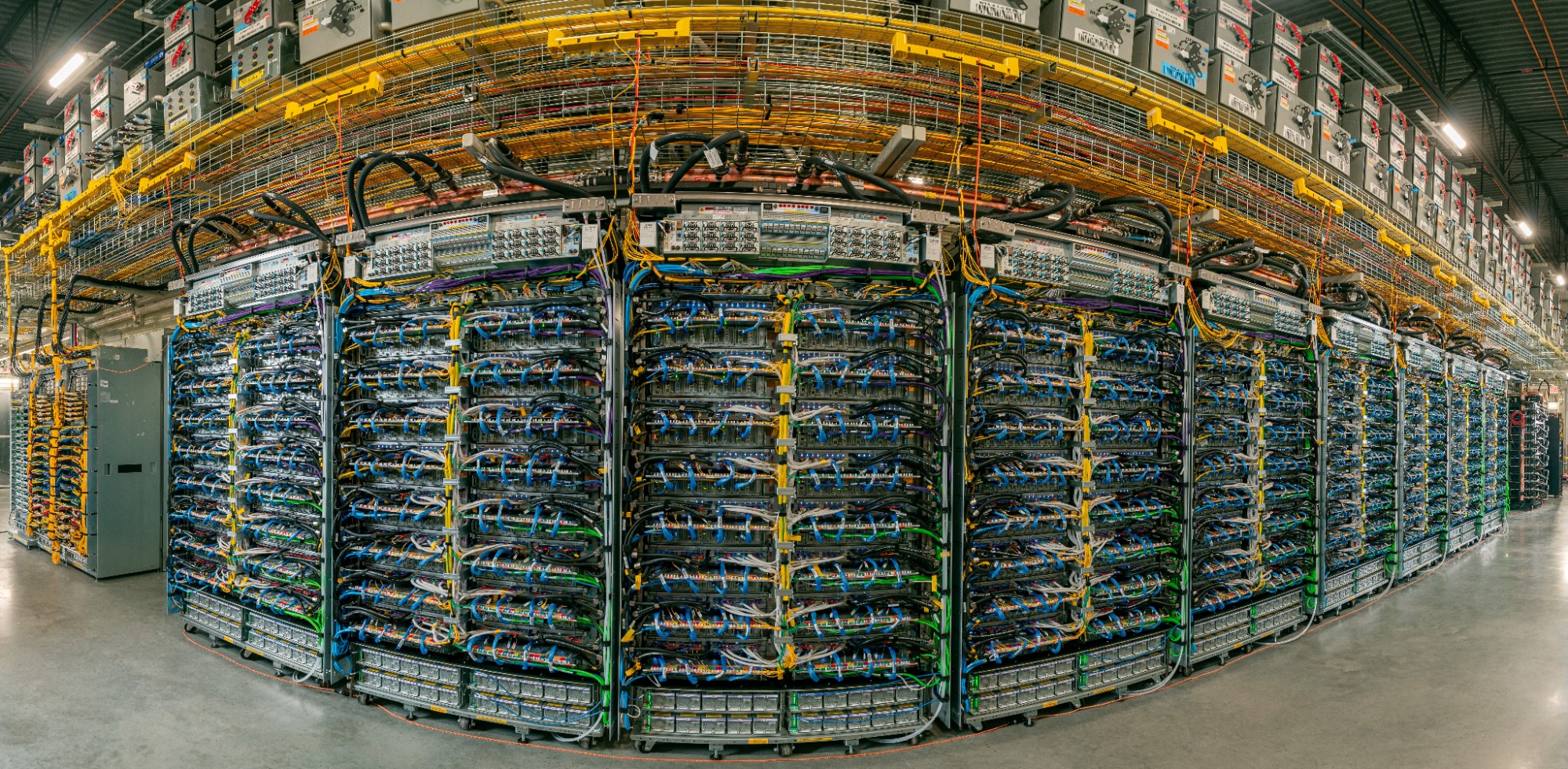

Ironwood se estructura bajo un modelo de «sistema primero», agrupando TPUs en pods y superpods que se interconectan a una velocidad de 9,6 Tb/s. Esto permite ensamblar hasta 9,216 TPUs en un dominio único, con 1,77 PB de HBM compartida, minimizando así los cuellos de botella en grandes modelos. Además, incorpora conmutación óptica para la resiliencia del sistema y refrigeración líquida para mantener su operatividad sin interrupciones.

En cuanto a la parte del software, Ironwood se integra con soluciones co-diseñadas como GKE, MaxText y vLLM para maximizar su potencial. Estas herramientas facilitan el mantenimiento y la planificación, mejoran la eficiencia en el entrenamiento y la inferencia, y optimizan la experiencia del usuario al reducir los tiempos de respuesta y costos.

El impacto de esta tecnología ya se percibe en el mercado, con empresas como Anthropic, Lightricks y Essential AI que planean utilizar Ironwood para fortalecer sus servicios. Destacan la capacidad de escalar operaciones sin sacrificar fiabilidad y el balance entre precio y rendimiento como factores decisivos.

Por otro lado, Google también ha lanzado Axion, que complementa su oferta con CPUs ARM Neoverse para potenciar aplicaciones más generales. Las instancias N4A y C4A metal prometen una mejora significativa en precio-rendimiento y flexibilidad, ideales para microservicios, bases de datos y ambientes de desarrollo.

Este avance coloca a Google en una posición competitiva destacada, enfocándose no solo en entrenar modelos de IA vasta sino también en optimizar la entrega eficiente y rentable de estas soluciones en producción. La combinación de aceleradores especializados y CPUs eficientes promete redefinir cómo las empresas implementan y operan sus plataformas de IA, con un enfoque en la disciplina del sistema y la integración fluida de componentes.