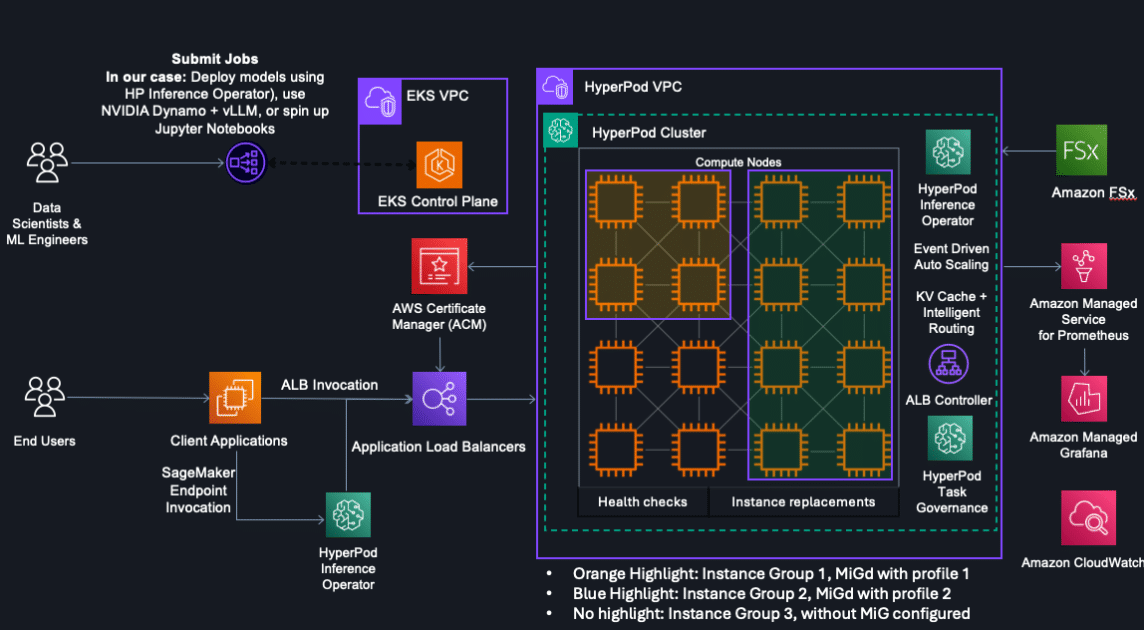

Amazon ha dado un paso adelante en la optimización del uso de GPUs con el lanzamiento de la partición de GPU en su servicio SageMaker HyperPod, empleando la tecnología Multi-Instance GPU (MIG) de NVIDIA. Esta innovadora capacidad permite la ejecución simultánea de múltiples tareas en una sola GPU, maximizando así la utilización de los recursos informáticos y de memoria, al tiempo que reduce significativamente los ciclos de desarrollo y despliegue.

El avance es especialmente relevante para los científicos de datos, que ahora pueden realizar tareas de inferencia, investigación y experimentación en notebooks de Jupyter sin tener que destinar GPUs completas a trabajos que no lo requieren. Este cambio no solo aumenta la eficiencia de ejecución, sino que permite a los administradores de clústeres ofrecer acceso a usuarios con distintos perfiles —como científicos y ingenieros de aprendizaje automático— para realizar más cargas de trabajo sin comprometer ni el rendimiento ni la seguridad.

La tecnología MIG, presentada por NVIDIA en 2020, permite dividir un único GPU en varias unidades funcionales independientes. Cada partición MIG actúa como una instancia de GPU autónoma, lo cual posibilita la ejecución de tareas concurrentes sin conflictos de recursos. Este enfoque resulta particularmente beneficioso para cargas de trabajo que no demandan toda la capacidad de una GPU moderna.

La adopción de la tecnología MIG en SageMaker HyperPod soluciona varios retos críticos en la administración de recursos de GPU. Simplifica la configuración, optimiza el uso de recursos, asegura el aislamiento de las cargas de trabajo y mejora la eficiencia de costos. Además, permite un seguimiento más detallado de las métricas de rendimiento y ofrece una gestión más granular de las cuotas de recursos entre equipos.

Arthur Hussey, integrante del equipo técnico de Orbital Materials, una startup con sede en el Reino Unido, afirmó que la incorporación de la tecnología de particionamiento MIG en SageMaker HyperPod ha mejorado significativamente la eficiencia de su clúster, permitiéndoles ejecutar un mayor número de tareas en paralelo.

Este desarrollo es particularmente útil para organizaciones que necesitan asignar instancias de alto rendimiento a múltiples usuarios o tareas en entornos aislados, mejorando así la eficiencia y el aprovechamiento de la infraestructura de GPU. La capacidad de asociar cada modelo a un tipo de instancia MIG adecuada permite un avance significativo en la eficiencia operacional, especialmente en entornos donde se despliegan varias versiones de un modelo.

En conclusión, la disponibilidad de MIG en SageMaker HyperPod representa un avance crucial en la gestión de recursos en el aprendizaje automático. Se anticipa que las organizaciones que adopten estas capacidades experimenten mejoras en el rendimiento y la productividad, optimizando el uso de sus clústeres de GPU y, potencialmente, reduciendo costos de operación.