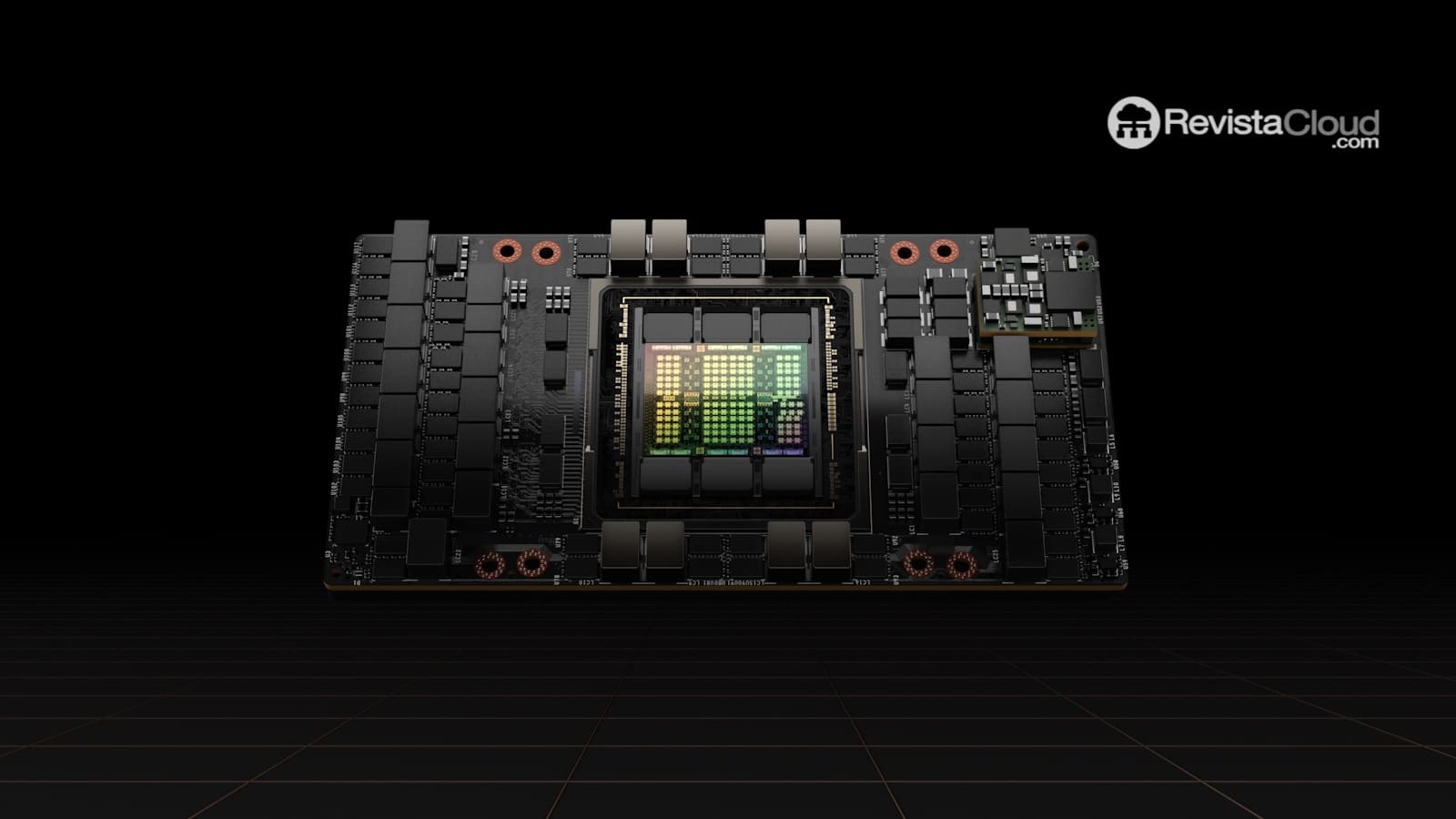

IBM ha anunciado la integración de las GPUs Nvidia H100 en su plataforma de computación en la nube, IBM Cloud, marcando un importante avance en sus capacidades de procesamiento para inteligencia artificial (IA). Esta actualización permitirá a los usuarios acceder a un rendimiento significativamente mejorado tanto para el entrenamiento de modelos como para la inferencia, un paso que la coloca en una mejor posición para satisfacer las crecientes demandas del mercado de IA.

La inclusión de las GPUs H100 supone un progreso considerable en comparación con las Nvidia A100, utilizadas por la compañía el año anterior. Datos proporcionados por Nvidia indican que estas GPUs ofrecen un rendimiento de inferencia hasta 30 veces superior al de sus predecesoras, prometiendo mejorar drásticamente la eficiencia y velocidad en los procesos de IA.

IBM Cloud mantiene su compromiso de proporcionar soluciones ajustadas a diversas necesidades, continuando con la oferta de una variedad de opciones de GPUs. Aparte de las H100, siguen disponibles las Nvidia A100 para cargas intensivas de IA, así como las Nvidia L40S y L4, ideales para tareas de menor escala como el entrenamiento de modelos modestos o el despliegue de chatbots.

Las nuevas instancias equipadas con H100 ya están operativas en varias ubicaciones de IBM alrededor del mundo, incluyendo regiones en Norteamérica, Latinoamérica, Europa, Japón y Australia. Además, la empresa planea expandir sus capacidades con el lanzamiento de los procesadores de IA Intel Gaudi 3 a principios de 2025, ampliando así su oferta de opciones de hardware especializado.

No obstante, a pesar de este avance, IBM Cloud aún se encuentra detrás de algunos de sus competidores más fuertes en la implementación de las GPUs H100. Gigantes de la industria como Amazon Web Services (AWS), Google, Microsoft y Oracle ya habían lanzado instancias con estas GPUs con más de un año de antelación. Incluso, startups dedicadas al desarrollo de GPUs en la nube, como CoreWeave y Cirrascale, habían accedido antes a esta tecnología.

El sector de las GPUs para IA sigue creciendo rápidamente, con planes de los principales proveedores de servicios de nube para integrar la futura línea de GPUs Blackwell de Nvidia. La empresa estima enviar miles de millones de dólares en tecnología de última generación durante el último trimestre de 2024.

En paralelo a estos desarrollos tecnológicos, IBM Cloud está experimentando una reestructuración interna significativa. Informes señalan que se está llevando a cabo un proceso de reducción de personal de manera discreta. IBM ha respondido afirmando que estos ajustes afectarán a un porcentaje mínimo de su plantilla total, sin alterar significativamente sus niveles de empleo para 2024.

La adopción de las GPUs Nvidia H100 representa un importante hito en la estrategia de IBM para fortalecerse en el competitivo mercado de servicios de IA en la nube. Sin embargo, aún está por verse cómo esta actualización influirá en su posición frente a otros actores dominantes en el sector.