En los últimos tiempos, la revolución tecnológica que representan los modelos de lenguaje de gran tamaño (LLMs) ha transformado el panorama de la inteligencia artificial en diversas industrias. Pero para maximizar el potencial de estos modelos y aprovechar datos actualizados y específicos del dominio, se vuelve crucial conectar con fuentes de información externa. La Generación Aumentada por Recuperación (RAG) se presenta como una solución efectiva a este desafío.

RAG funciona recuperando información relevante de bases de datos o documentos en respuesta a la entrada de un usuario, integrándola en las solicitudes que procesan los LLMs. Esto permite generar respuestas más precisas y contextualizadas. La técnica está siendo implementada en múltiples aplicaciones, desde la consulta de documentación técnica para el desarrollo de productos, hasta la atención al cliente y la toma de decisiones basada en datos actuales.

El impacto de RAG es notable tanto para los proveedores de software como servicio (SaaS) como para los usuarios finales. Los proveedores se benefician de una arquitectura multi-tenant, que permite ofrecer servicios a múltiples clientes desde una única base de código. Esto acumula datos específicos por cliente, protegidos por controles de acceso y aislamiento de datos. Los LLMs, al integrarse con RAG en estos entornos, ofrecen servicios de IA personalizados utilizando información específica de cada cliente.

Un ejemplo claro es un centro de llamadas SaaS, donde las consultas históricas y manuales del producto de cada cliente se acumulan como una base de conocimiento. Con RAG, el LLM puede generar respuestas precisas basándose en estas fuentes, proporcionando interacciones más personalizadas, algo que no es posible con asistentes de IA genéricos. Así, RAG se convierte en un componente esencial para ofrecer experiencias de IA personalizadas en SaaS, aumentando el valor y diferenciando el servicio.

No obstante, la implementación de RAG plantea retos, especialmente en términos de seguridad y privacidad. En un entorno multi-tenant, es crítico asegurar el aislamiento de datos entre clientes para evitar filtraciones o accesos no autorizados. Esto impacta directamente en la confiabilidad y competitividad de los proveedores SaaS.

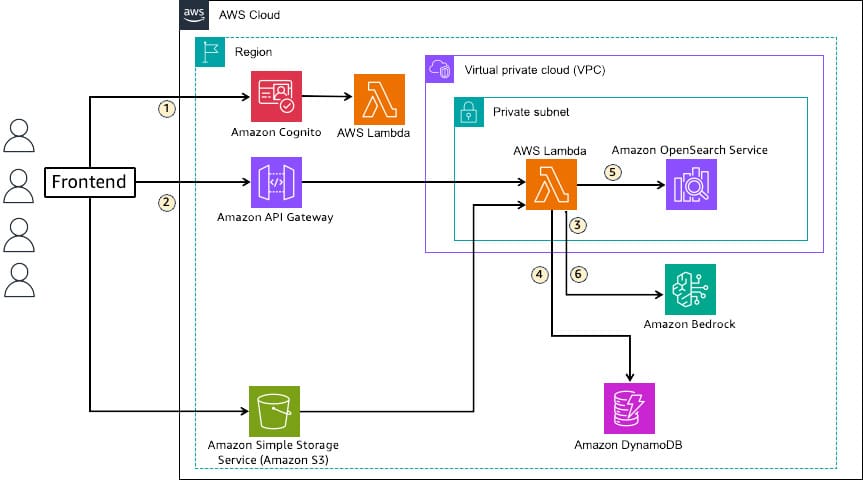

Para facilitar la implementación de RAG, Amazon Bedrock Knowledge Bases ofrece una solución confiable. Utilizando OpenSearch como base de datos vectorial, se puede optar por Amazon OpenSearch Service o Amazon OpenSearch Serverless, ambos con diferentes características y modelos de permisos para construir entornos multi-tenant. La combinación de JSON Web Token (JWT) y el Control de Acceso Basado en Atributos ofrece una forma de gestionar de manera efectiva el acceso y aislamiento de datos.

La solución implementa autenticación a través de JWT para asegurar el aislamiento de datos y la seguridad, estableciendo permisos de acceso diferenciados. Con RAG, la búsqueda de información relevante se enriquece al añadir contexto a las respuestas generadas por LLM, mejorando significativamente su calidad y relevancia.

Conforme RAG se integra más en el sector SaaS, los desafíos técnicos del manejo de datos multi-tenant exigen soluciones innovadoras que protejan la información sensible y maximicen la funcionalidad de los sistemas de IA. Este avance subraya un importante paso en la evolución del software y los servicios en la nube, donde la personalización y la seguridad se vuelven más esenciales que nunca.