En un mundo donde la inteligencia artificial generativa cobra cada vez más protagonismo, los desafíos asociados con el despliegue de modelos de lenguaje de gran tamaño (LLMs) son ineludibles. Estos modelos, esenciales para múltiples industrias, deben ser evaluados rigurosamente para garantizar su óptimo funcionamiento en aplicaciones del mundo real. La evaluación de precisión, equidad y relevancia, además de la mitigación de alucinaciones, son aspectos críticos en este contexto.

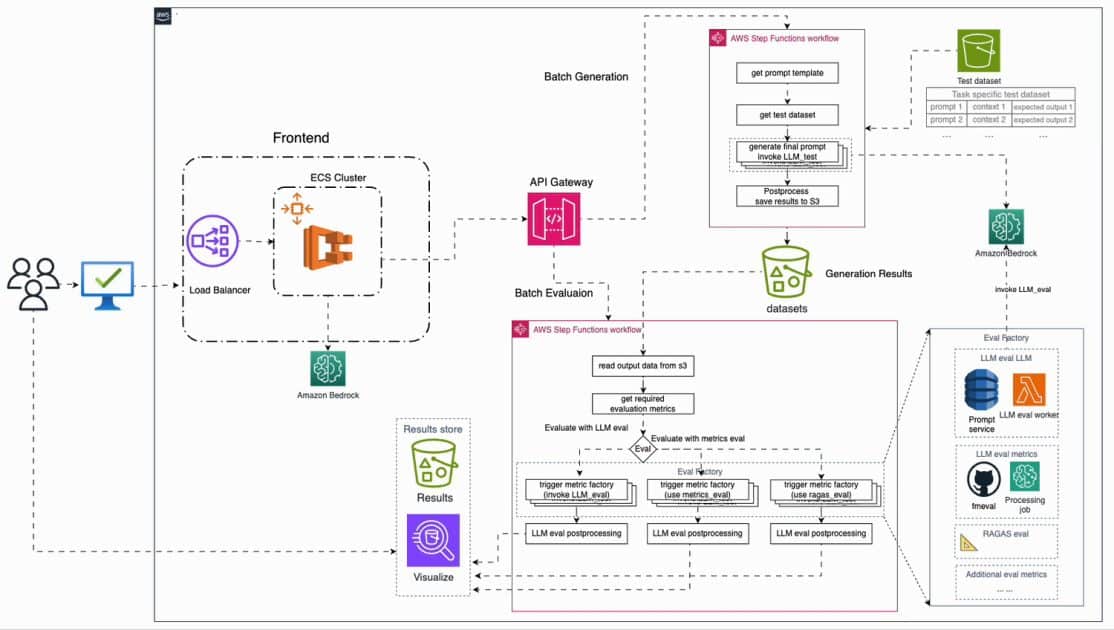

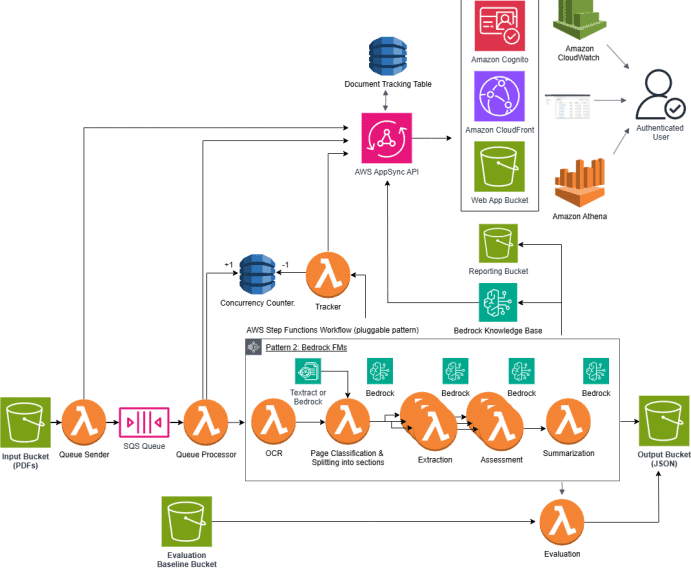

La necesidad de marcos de evaluación automatizados ha incrementado significativamente, dado que la evaluación humana, a pesar de ofrecer insights valiosos, se enfrenta a limitaciones en términos de costo y escalabilidad. Un reciente desarrollo en esta área es un marco de evaluación automatizado que puede integrarse en Amazon Web Services (AWS), permitiendo una evaluación efectiva y escalable de múltiples LLMs.

Este sistema innovador utiliza modelos como Amazon Nova, ofreciendo evaluaciones con baja latencia y prometiendo una integración fluida en el ciclo de desarrollo de aplicaciones de IA. La implementación de este tipo de herramientas se asemeja a las pruebas unitarias y de integración en el desarrollo de software, facilitando así la monitorización constante del desempeño de los modelos.

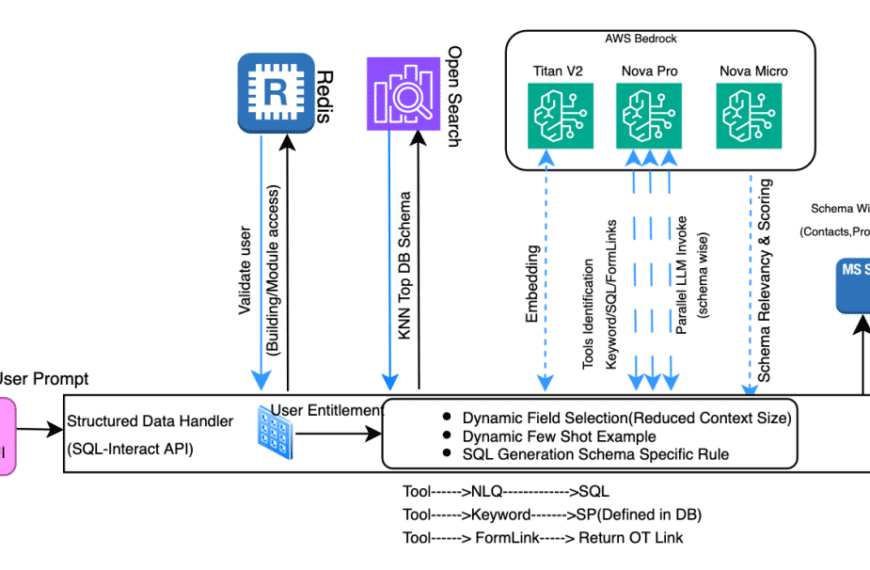

Un pilar fundamental antes de implementar la evaluación es definir métricas y criterios claros. Esto incluye reunir un conjunto de datos representativo y diverso que sirva para evaluar casos relevantes. Este conjunto puede ser continuamente optimizado, enriquecido con nuevos ejemplos que desafíen el rendimiento del modelo.

Las métricas de evaluación pueden dividirse en áreas como latencia, costo y rendimiento. La latencia abarca el tiempo de generación de respuestas; el costo se refiere a los recursos necesarios para dicha generación, mientras que el rendimiento se enfoca en la precisión y consistencia de las respuestas.

Implementar un flujo de trabajo que combine evaluaciones en línea, manuales y automatizadas podría implicar desafíos operativos considerables, haciendo esencial contar con herramientas de comparación y servicios de inferencia a escala.

Con la automatización del proceso de evaluación en AWS, se pretende no solo facilitar el trabajo de los equipos de desarrollo sino también asegurar que los modelos de LLM en producción se mantengan a la vanguardia, alineados con los estándares de precisión, equidad y relevancia requeridos por las crecientes demandas del mercado tecnológico.