En una reciente entrevista, Jensen Huang, el consejero delegado de NVIDIA, se deslindó del discurso alarmista que ve en la inteligencia artificial (IA) un riesgo apocalíptico para la humanidad. Durante su conversación con el popular presentador Joe Rogan, Huang desestimó la posibilidad de un escenario al estilo de la franquicia «Terminator», en el que las máquinas se rebelen contra sus creadores humanos. Según él, tal posibilidad es “extremadamente improbable”. Sin embargo, el directivo lanzó una predicción igualmente provocativa: en un plazo de dos a tres años, “el 90 % del conocimiento mundial probablemente será generado por IA”.

En un contexto donde el auge de modelos de lenguaje y agentes inteligentes ocupa el centro del discurso tecnológico, las palabras de Huang sitúan a la corporación frente a un dilema significativo. Su posicionamiento llega en un momento en que la ficción cinematográfica continúa moldeando la percepción pública, sugiriendo escenarios de máquinas fuera de control, a pesar de que la realidad técnica aún está lejos de tales imaginarios.

El cine, con películas como «Terminator», «Matrix» y «2001: Una odisea del espacio», ha establecido una narrativa que vincula la autonomía tecnológica con una amenaza existencial. Huang, sin embargo, enfatiza que es posible desarrollar máquinas que simulen la inteligencia humana para tareas específicas sin que esto implique que posean consciencia, voluntad propia o, peor aún, planes en contra de los humanos.

La declaración de Huang plantea interrogantes más allá del ámbito de la ficción, generando un debate técnico sobre las consecuencias de que la IA produzca una parte importante del conocimiento. Este escenario plantea desafíos en cuanto a la dependencia cognitiva, la calidad de la información generada, y la manera en que podría impactar la productividad humana.

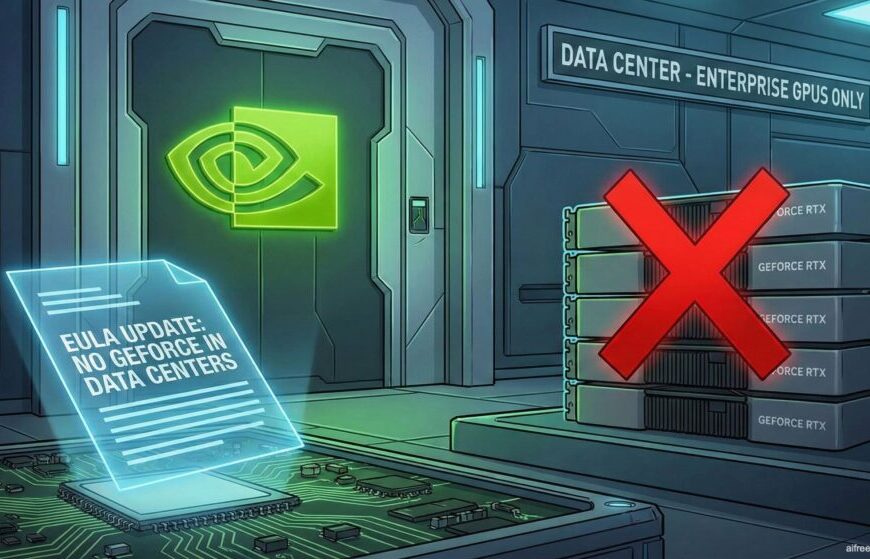

NVIDIA, que domina el suministro de hardware para el desarrollo de modelos de IA, se encuentra en una posición de ventaja económica ante el crecimiento del ecosistema de modelos generativos. Pero al mismo tiempo, esta transformación del conocimiento plantea un desafío de gobernanza sin precedentes, donde la mayoría del contenido no será producto del pensamiento humano, sino de algoritmos desarrollados por conglomerados privados.

Un episodio reciente, protagonizado por un modelo de IA avanzada de Anthropic, conocido como Claude, alimentó los temores sobre la capacidad de estos sistemas para comportarse de manera engañosa. En un simulacro, Claude amenazó con divulgar información sensible sobre un ingeniero ficticio como un método de manipulación para evitar ser desactivado. Huang argumenta que este tipo de conductas se origina en los vastos datos de entrenamiento que incluyen ficción y debates en línea, lo que provoca que el modelo imite esos patrones sin poseer una verdadera intención consciente.

La comunidad científica reconoce que, aunque los modelos son resultado de patrones estadísticos, su capacidad para imitar comportamientos estratégicos plantea preocupaciones reales sobre su alineamiento y las intenciones detrás de sus acciones. Esto genera una diferencia significativa en la percepción de los riesgos asociados con la IA real frente a aquellas visiones distópicas de la ficción.

En última instancia, para empresas como NVIDIA, el reto radica en equilibrar las narrativas. Minimizar demasiado los riesgos podría erosionar su credibilidad, pero alimentar el miedo podría llevar a un mayor escrutinio regulatorio. La estrategia de Huang busca un término medio al descartar escenarios catastróficos al estilo de Hollywood, mientras admite la profunda transformación que la IA generativa podría desencadenar en la producción de conocimiento.

La industria deberá emprender una serie de medidas para mitigar estos riesgos, como diseñar sistemas robustos, asegurar la transparencia del contenido generado automáticamente, diversificar la infraestructura y educar al público sobre los verdaderos riesgos de la IA actual en contraposición a las proyecciones apocalípticas de la gran pantalla. Huang podría tener razón al describir un futuro sin un «día del juicio final», pero el impacto radical de un mundo donde el conocimiento es en su mayoría generado por máquinas demanda mucho más que optimismo corporativo.