El sector de la inteligencia artificial (IA) se encuentra en un momento crucial, enfrentando una decisión clave sobre cuáles son las herramientas más adecuadas para impulsar el futuro: continuar usando GPU (Graphics Processing Unit) ampliamente empleadas o dar paso a alternativas más especializadas como los ASIC (Application-Specific Integrated Circuit) y TPU (Tensor Processing Unit). A medida que la IA evoluciona hacia una fase de inferencia masiva, la industria se pregunta si es oportuno abandonar las tradicionales GPU para adoptar los chips diseñados para tareas específicas.

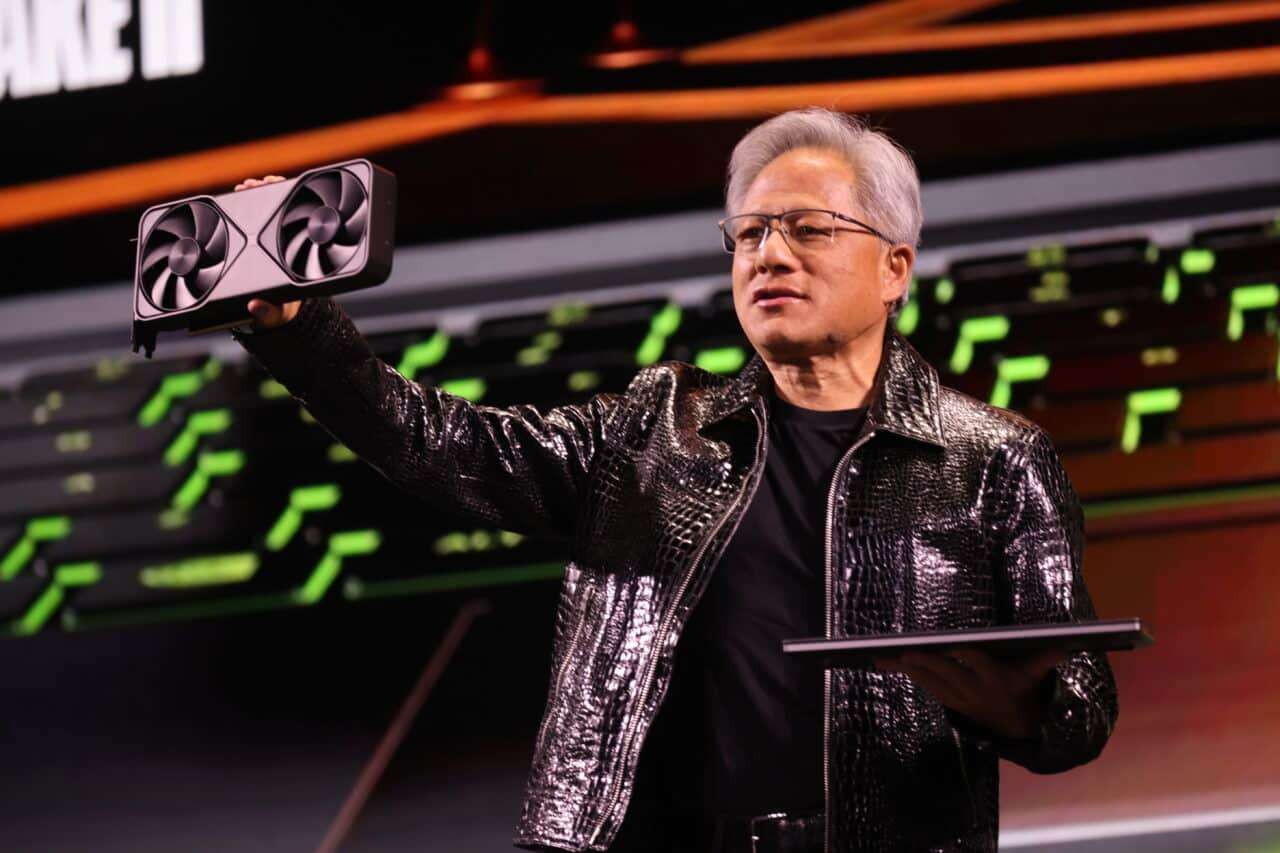

Jensen Huang, el consejero delegado de NVIDIA, sostiene que la auténtica competición en el ámbito de la IA no ocurre entre empresas, sino entre equipos de ingeniería. Según Huang, su compañía lidera la innovación y efectiva integración de sus productos en el mercado, restando importancia a la creciente presencia de los ASICs y TPUs desarrollados por gigantes como Google.

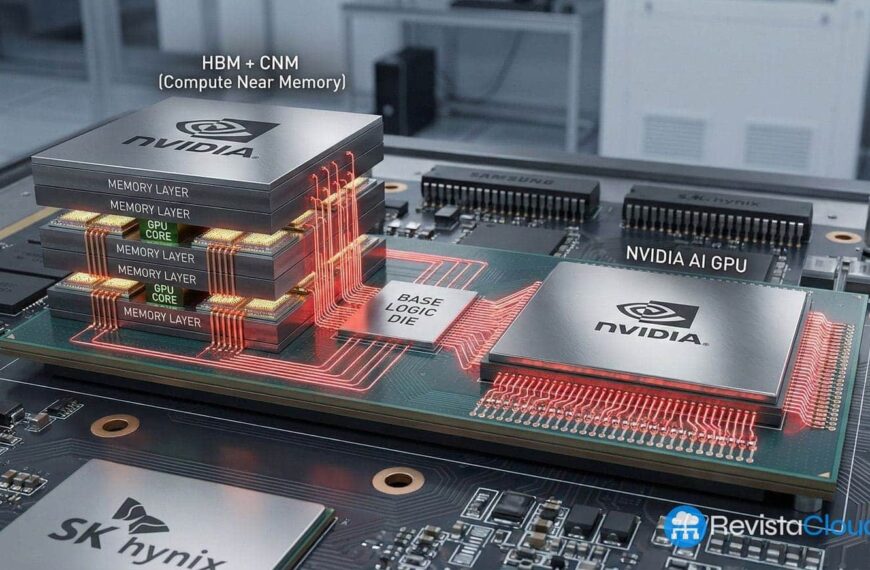

Los centros de datos de IA albergan dos tipos de chips. Las GPU nacieron para procesar gráficos, pero se han consolidado como estándar para aprendizaje profundo, gracias a su capacidad de procesamiento paralelo y su flexibilidad. Por otro lado, los ASICs y TPUs son chips creados para tareas específicas, maximizando la eficiencia energética en modelos concretos, especialmente en inferencia a gran escala.

Comparando ambas tecnologías, las GPU sobresalen en flexibilidad y cuentan con un ecosistema de software maduro, gracias a herramientas como CUDA de NVIDIA. Este entorno facilita la adopción de GPU, pues cuenta con amplia comunidad y soporte multi-cloud. Por su parte, los ASICs y TPUs ofrecen una gran eficiencia en tareas de inferencia masiva y control preciso del stack, siendo ventajosos en escenarios de hiperescala.

Aunque el mercado de IA explora opciones más diversificadas con el uso de ASICs y TPUs, Huang enfatiza en que replicar la plataforma integral que NVIDIA ofrece es una tarea monumental que pocos pueden lograr. Casos como el de Anthropic, que utiliza tanto GPU de NVIDIA como TPU de Google, reflejan que la coexistencia de tecnologías es posible y beneficiosa. Sin embargo, Huang destaca que las GPU siguen siendo esenciales para cargas críticas y entrenamiento a gran escala.

¿Por qué entonces muchas empresas siguen apostando por las GPU? La flexibilidad de las GPU, unida al robusto ecosistema CUDA y la capacidad de portabilidad entre proveedores, las mantiene como una opción práctica y popular. Las GPU modernas no solo ejecutan inferencias sino que también entrenan nuevos modelos y simulan operaciones complejas, ofreciendo un ritmo de innovación sostenido que es difícil igualar con ASICs.

Por otro lado, los ASICs y TPUs tienen su propio terreno. Son estratégicamente beneficiosos para entidades con enormes volúmenes de inferencia repetitiva y que controlan completamente su stack tecnológico, como Google. Además, en ámbitos donde la eficiencia energética es primordial, los ASICs hiperoptimizados pueden marcar una diferencia significativa.

Analizando las declaraciones de Huang, el mensaje es claro: aunque los ASICs y TPUs tienen su lugar en el mercado, NVIDIA mantiene una posición robusta debido a su capacidad de innovar continuamente y proporcionar un entorno de herramientas y soporte inigualable. A corto plazo, la demanda de GPU sigue siendo fuerte; a largo plazo, el verdadero desafío será quien pueda mantener el mejor equipo de ingeniería y un ecosistema de software atractivo.

Por lo tanto, la presencia de ASICs y TPUs no desplaza a las GPU, sino que enriquece un ecosistema más diverso donde cada tecnología se adapta a sus mejores aplicaciones, con NVIDIA decidida a seguir siendo el eje de la IA moderna.