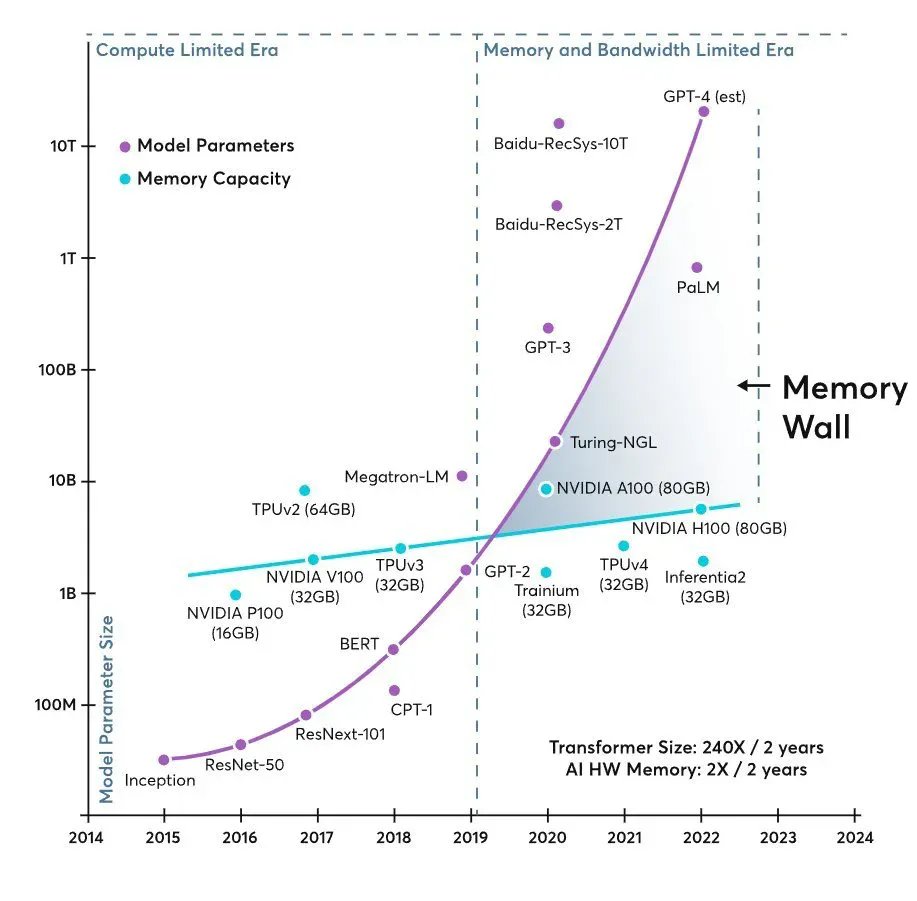

En la actualidad, la Inteligencia Artificial (IA) ha pasado de ser un concepto futurista a convertirse en una realidad palpable en diversos sectores de la industria. Sin embargo, a medida que los modelos de IA crecen en complejidad y tamaño, uno de los mayores desafíos que enfrenta la industria es la llamada «pared de memoria». Esta situación, prevista para cambiar el panorama de infraestructuras de IA en 2026, no es una mera cuestión de falta de GPUs, sino un problema más intrincado que involucra capacidad, ancho de banda y latencia.

En el corazón de esta problemática se encuentra la creciente discrepancia entre el tamaño de los modelos de IA, que aumentan casi de forma exponencial, y el avance más pausado de la memoria por acelerador. Esto ha llevado a centros de datos a una situación donde los procesadores gráficos, piezas de tecnología de última generación, ven su desempeño reducido si no reciben datos a la velocidad adecuada. En este contexto, términos técnicos como “memory wall” están ganando terreno, describiendo el punto donde el rendimiento está limitado por la memoria, más que por el cálculo puro.

La industria tecnológica ya vivió algo similar en el pasado con la computación tradicional, cuando las CPUs superaron a la RAM en velocidad, provocando que los procesadores esperaran a que la memoria estuviera lista para suministrar datos. En el mundo de la IA, la misma situación se repite ahora a mayor escala, especialmente en modelos tipo transformer. En el servicio de inferencia, el cuello de botella de la memoria se vuelve aún más crítico, con impactos directos en costos, consumo energético y latencia de respuesta.

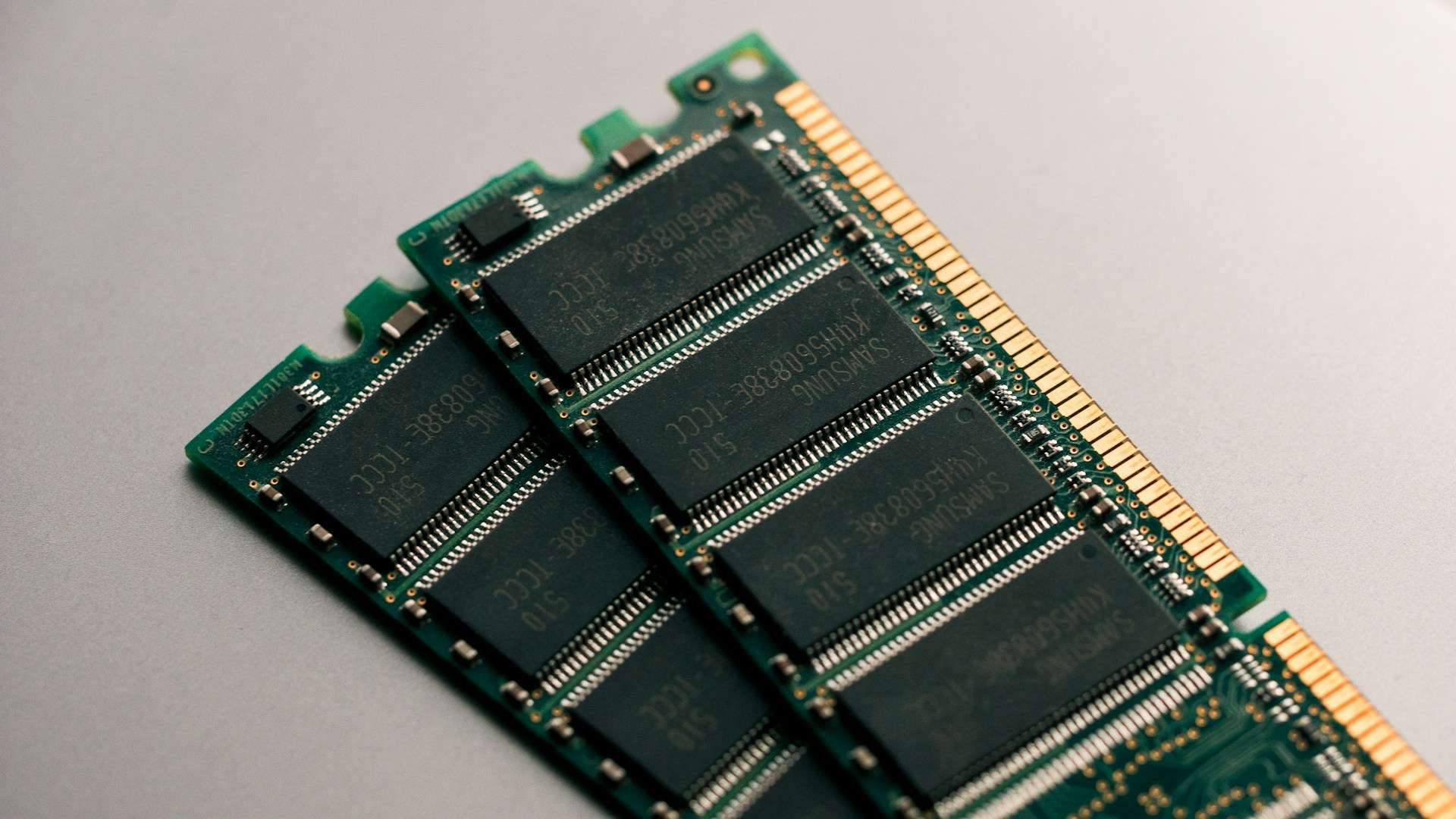

La solución a este desafío no pasa simplemente por aumentar el número de GPUs en los centros de datos. La industria está redirigiendo sus inversiones hacia el diseño de sistemas que puedan mantener estos aceleradores “bien alimentados” mediante memorias más cercanas, con mayor ancho de banda y mayor capacidad utilizable. Aquí es donde tecnologías como HBM (High Bandwidth Memory) y CXL (Compute Express Link) juegan un papel crucial en esta nueva era de la computación.

HBM se ha posicionado como una pieza clave en este entramado, gracias a su capacidad para ofrecer un alto ancho de banda por vatio y su cercanía física al chip. Los fabricantes de memoria están ya promocionando sus gamas más avanzadas como esenciales para el entrenamiento de modelos exigentes en IA. Por otro lado, DDR5 continúa siendo una opción viable por su escalabilidad y coste, mientras que las extensiones tipo CXL ofrecen nuevas vías para expandir capacidad más allá de los canales tradicionales.

Otra variable en esta ecuación es la memoria flash, utilizada para almacenar los checkpoints y datasets masivos que son esenciales para los flujos de entrenamiento de modelos. Las unidades de almacenamiento rápido, como NAND y SSD empresariales, están viendo un aumento en su demanda debido a su importancia crítica en mantener los procesos de IA eficientes y evitar «cuellos de botella» en el acceso a datos.

En el ámbito corporativo, empresas como SanDisk han resurgido con fuerza, capitalizando la creciente demanda de memoria impulsada por la IA, tras reestructurarse y cotizar como entidad independiente. Sus resultados financieros demuestran cómo la memoria se está convirtiendo en una piedra angular en la infraestructura de IA.

Además, la significación estratégica de la memoria no solo se refleja en la tecnología, sino también en las gigantescas inversiones que están llevando a cabo empresas como Micron. La compañía anunció planes para invertir 24 mil millones de dólares en una nueva planta de fabricación en Singapur, destinada a paliar la escasez global de memoria, que es critical para el auge de aplicaciones de IA y cargas centradas en datos.

En definitiva, el avance de la IA depende de una memoria cuya función ha pasado de ser mero complemento a convertirse en un componente fundamental del rendimiento de los centros de datos. La innovación ya no se enfoca únicamente en la potencia bruta, sino en la arquitectura del sistema, en cómo se gestionan los datos y cómo se optimizan los flujos de información para maximizar el valor de cada operación computacional. Esta evolución plantea un panorama donde los centros de datos de IA serán más complejos y costosos, pero también más eficientes y estratégicos en su operación.