Salesforce y Amazon Web Services (AWS) han dado un paso significativo al anunciar una colaboración estratégica enfocada en optimizar la implementación de modelos de inteligencia artificial, especialmente los modelos de lenguaje de gran tamaño (LLMs). El equipo de Model Serving de Salesforce se ha propuesto maximizar la eficiencia de estos modelos, esenciales para integrarlos en aplicaciones críticas.

El despliegue efectivo de modelos de IA enfrenta desafíos considerables, particularmente en lo referente a mantener un rendimiento óptimo y una gestión de costos equilibrada. Este problema se intensifica debido a la diversidad en los tamaños y requisitos de estos modelos, que pueden oscilar entre unos pocos gigabytes y hasta 30 GB.

Salesforce ha identificado dos desafíos principales: los modelos de gran tamaño frecuentemente utilizan menos recursos de los disponibles, lo que conduce a un uso ineficiente de las instancias de múltiples GPUs. En contraposición, los modelos de tamaño intermedio necesitan tiempos de respuesta rápidos, lo que incrementa costos debido a la sobreasignación de recursos.

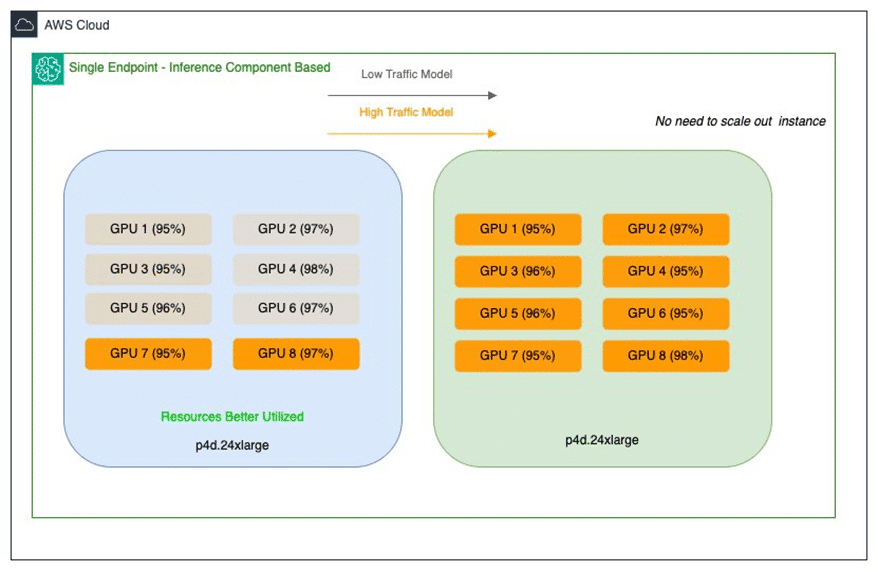

Para abordar estas cuestiones, Salesforce ha implementado componentes de inferencia de Amazon SageMaker que facilitan el despliegue de múltiples modelos en un solo endpoint. Esto posibilita un manejo preciso de los aceleradores y memoria asignada a cada modelo, mejorando la utilización de recursos y reduciendo significativamente los costos de implementación.

Esta estrategia ofrece múltiples ventajas, como la optimización del uso de GPUs y la capacidad de escalar modelos individualmente según las necesidades específicas. Esto no solo resuelve problemas inmediatos, sino que también establece una base adaptable para el futuro crecimiento de sus iniciativas de inteligencia artificial.

Gracias a estas innovaciones, Salesforce no solo reduce costos de infraestructura sino que también mejora la eficiencia operativa, logrando economías de hasta un 80% en gastos de despliegue. Los modelos más pequeños, asimismo, se benefician de GPUs de alto rendimiento, asegurando un elevado rendimiento y baja latencia sin incurrir en altos costos.

Mirando hacia adelante, Salesforce planea utilizar las actualizaciones continuas de los componentes de inferencia para mantener sus modelos siempre actuales, minimizando la carga operativa y potenciando la integración de futuras innovaciones. Esto posiciona a la empresa para continuar creciendo y expandiendo sus ofertas de inteligencia artificial, manteniendo altos estándares de eficiencia y costos controlados.