Microsoft ha dado un importante paso adelante en la carrera tecnológica al presentar el Maia 200, su nuevo y avanzado acelerador de inferencia diseñado para optimizar la eficiencia y el costo operativo de la ejecución de modelos de inteligencia artificial (IA) a gran escala en sus centros de datos. Este dispositivo busca posicionarse como un elemento clave en la infraestructura heterogénea de Microsoft, estableciendo su importancia no solo dentro de sus servicios como Microsoft Foundry y Microsoft 365 Copilot, sino también en el ecosistema de la IA en general.

En un contexto donde la industria tecnológica prioriza cada vez más la relación rendimiento-costo, la capacidad de memoria, la eficiencia energética y el movimiento de datos por encima de los «FLOPS brutos», Microsoft busca con Maia 200 no solo reducir los costos de inferencia, que representan una considerable parte del gasto operativo, sino también ejercer un mayor control sobre la cadena tecnológica que abarca desde el silicio hasta la red y el software.

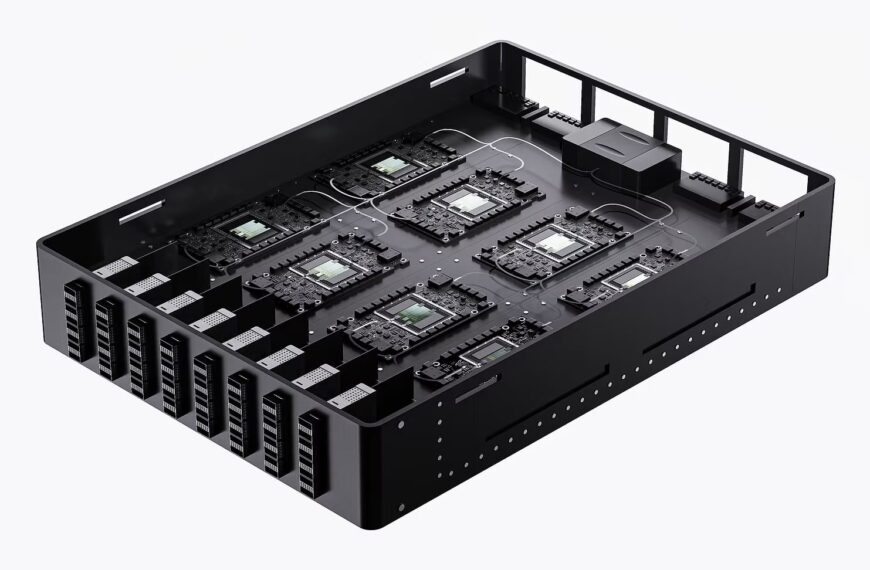

Maia 200, fabricado en un proceso de 3 nm, se optimiza para precisiones bajas específicas como FP8 y FP4, adaptándose así a las necesidades modernas de inferencia a gran escala. Entre sus características más destacadas se encuentra su capacidad para maximizar el throughput de tokens mediante cómputo de baja precisión, un subsistema de memoria rediseñado que facilita la ejecución sin cuellos de botella y un enfoque de red basado en Ethernet que permite escalar clústeres densos.

Actualmente, los despliegues iniciales del Maia 200 se están llevando a cabo en la región US Central, abarcando áreas como Des Moines, Iowa, y se planea expandir hacia US West 3 en Phoenix, Arizona. Este acelerador no solo representa un salto significativo dentro de la flota de inferencia de Microsoft, sino que, según la compañía, ofrece un rendimiento aproximadamente un 30% mejor por dólar respecto al hardware más reciente que emplea.

El Maia 200 incorpora más de 140.000 millones de transistores, 216 GB de HBM3e con un ancho de banda de 7 TB/s y 272 MB de SRAM en chip. Estas especificaciones le permiten alcanzar un rendimiento pico de más de 10 petaFLOPS en FP4 y más de 5 petaFLOPS en FP8, con un consumo energético que se sitúa en 750 W. Estas características posicionan a Maia 200 como una herramienta esencial para resolver desafíos en el movimiento de datos, un aspecto crucial en la inferencia de IA.

La propuesta de Microsoft se complementa con el Maia SDK, una plataforma que permite la integración con PyTorch y optimización a través de Triton, asegurando una portabilidad eficiente y un control refinado. Esto, unido a las posibilidades de simulación y cálculo de costos, refuerza la operabilidad y eficiencia antes del despliegue.

El Maia 200 se presenta como un acelerador enfocado en la inferencia, aprovechando las ventajas de FP4 y FP8 para mejorar el throughput y reducir los costos energéticos sin comprometer la calidad, gracias a técnicas avanzadas de cuantización. La incorporación de memoria HBM3e permite albergar modelos complejos y reducir el tráfico de datos, mejorando así la utilización efectiva del chip.

A través de esta innovación, Microsoft no solo intenta liderar en rendimiento y eficiencia, sino también establecer un nuevo estándar en la manera en que se integran y optimizan los componentes en la infraestructura de IA. Este movimiento podría cambiar significativamente el panorama competitivo en el sector de la tecnología, donde la capacidad de controlar y optimizar cada aspecto del hardware y software se convierte en una ventaja estratégica.