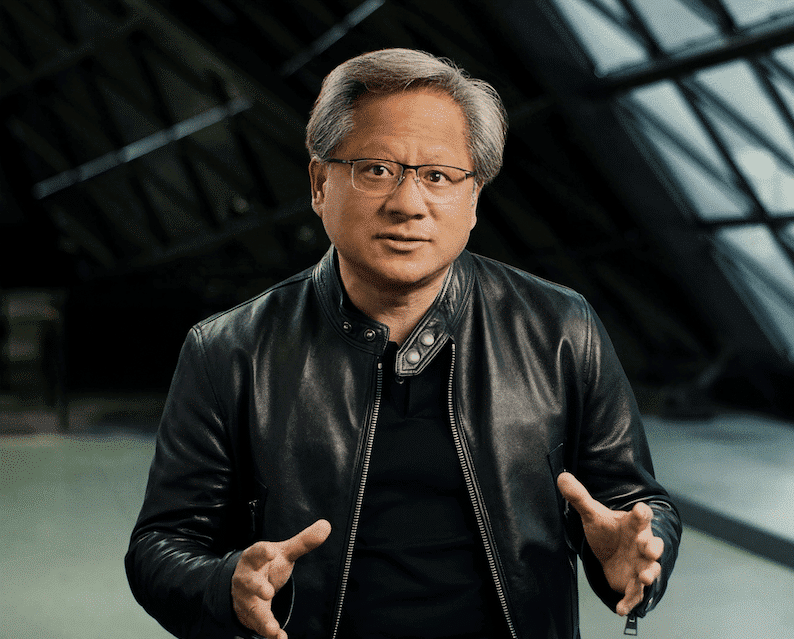

En un sorprendente giro de la narrativa popular, NVIDIA ha sido objeto de rumores y titulares sensacionalistas que afirman que la compañía ha «admitido» que su arquitectura de chips está «rota». Estos rumores surgieron tras la presentación del Rubin CPX, un chip para Inteligencia Artificial que abandona la tradicional memoria HBM en favor de una arquitectura GDDR. Aunque estos titulares han capturado la atención en redes sociales, el panorama real es más complejo y significativo: NVIDIA está adaptándose a un cambio profundo en el consumo de Inteligencia Artificial en la producción.

El Rubin CPX es un acelerador diseñado específicamente para el procesamiento del contexto o prefill, una etapa crucial en la inferencia de sistemas inteligentes que involucra el manejo de grandes volúmenes de datos antes de generar respuestas. Al optar por memoria GDDR, NVIDIA no está admitiendo un fallo en sus diseños previos, sino respondiendo a la necesidad de hacer más rentable el suministro de servicios de IA, particularmente en contextos donde la información se maneja a gran escala.

Este lanzamiento se inscribe dentro de la plataforma Vera Rubin NVL144, una solución a escala de rack que integra aceleradores para cubrir diversas necesidades en inferencia. La visión detrás de Rubin CPX es clara: dividir las fases de inferencia para optimizar de manera independiente los costos y el rendimiento, lo que representa un significativo salto evolutivo, dado que procesos en escenarios modernos de IA requieren estrategias diferentes para etapas de procesamiento y generación.

El desarrollo de Rubin CPX y su integración en el ecosistema de NVIDIA refleja una adaptación a los nuevos patrones de uso, donde el contexto extenso se convierte en la norma más que la excepción. Esto resalta la importancia de tratar cada fase del proceso de inferencia con estrategias distintas para mejorar la eficiencia y reducir costes.

Además, NVIDIA ha estado preparando el terreno con herramientas como Dynamo, una capa de orquestación que mejora la escalabilidad de la inferencia de modelos de IA, gestionando aspectos críticos como el enrutado y la transferencia de datos. De este modo, Rubin CPX no es solo un chip aislado, sino una parte integral de un enfoque holístico que incluye tanto hardware como software.

Este cambio de enfoque en NVIDIA no se produce en un vacío competitivo. Otras compañías como Google con sus TPUs e Ironwood y AWS con Trainium, también progresan en el camino hacia especializar y optimizar sus propias soluciones de hardware para IA. En un esfuerzo por reducir la dependencia y controlar costos, estas empresas buscan alternativas que les permitan ajustarse mejor a las demandas del mercado real.

En resumen, mientras algunos podrían interpretar el desarrollo de Rubin CPX como una admisión de fallos previos, lo cierto es que revela la habilidad de NVIDIA para adaptarse a un entorno de inteligencia artificial en constante evolución. La verdadera prueba de su éxito radicará en cómo estas estrategias influyan en los despliegues operativos y en los resultados de sus clientes en el futuro próximo.