La inteligencia artificial continúa su evolución con la arquitectura Mixture of Experts (MoE) en el centro del avance tecnológico. Esta nueva generación de modelos es la preferida indiscutible para aplicaciones que requieren un alto nivel de inteligencia y rendimiento. NVIDIA ha demostrado su intención de liderar este campo con su sistema GB200 NVL72, diseñado para implementar este tipo de arquitectura a gran escala.

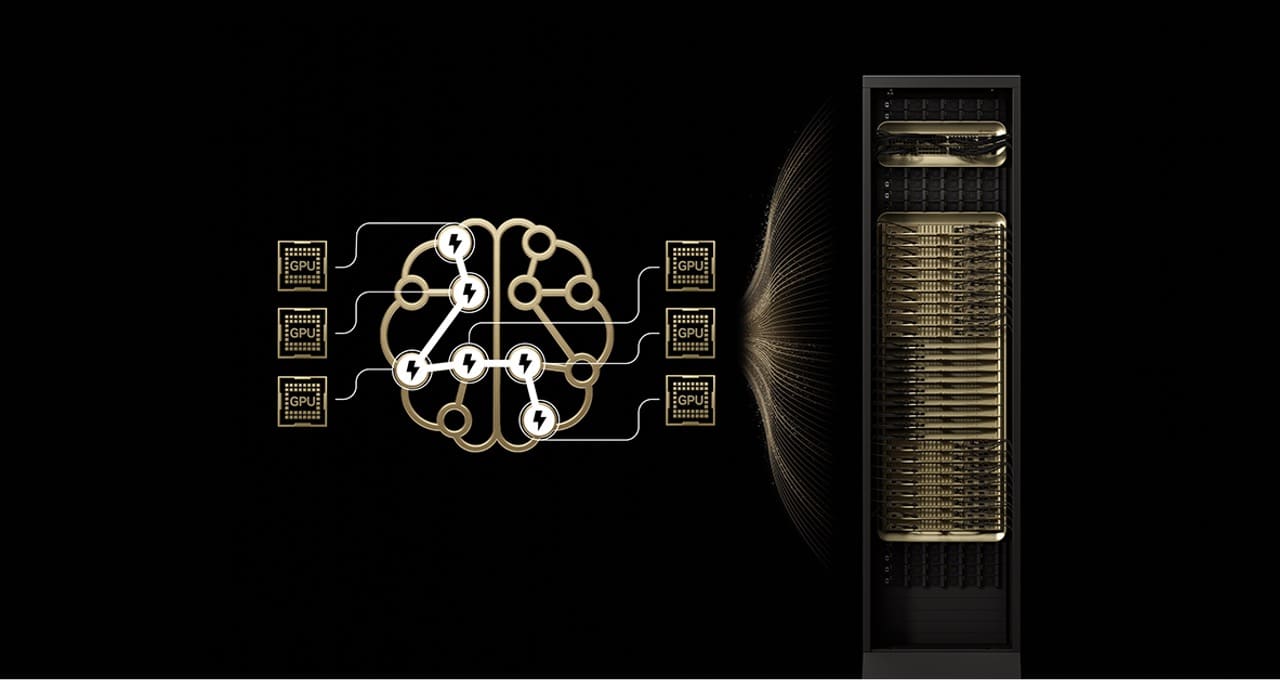

El GB200 NVL72, un sistema a escala de rack que integra 72 GPU NVIDIA Blackwell, ha sido un gran avance tecnológico en el mundo de la inteligencia artificial. Conectadas mediante NVLink Switch, estas GPU crean un dominio de interconexión de alta velocidad que ofrece un rendimiento sin precedentes de 1,4 exaflops en tareas de IA, además de contar con 30 TB de memoria compartida de alta velocidad. Esto ha resultado ser un cambio radical para los modelos MoE, permitiéndoles alcanzar hasta 10 veces más rendimiento en inferencia comparado con sus predecesores, como el sistema H200.

La arquitectura MoE desafía la lógica tradicional que ha dominado el sector de la inteligencia artificial por años, donde los modelos densos con un número masivo de parámetros eran la norma. El enfoque MoE, sin embargo, utiliza un sistema de «expertos» especializados, activando solo un subconjunto necesario para cada tarea, muy similar a cómo el cerebro humano emplea áreas específicas para diferentes actividades. Este sistema no solo mejora la capacidad cognitiva de los modelos, sino que también optimiza el consumo energético y reduce los costos de creación por token, haciendo que la inteligencia artificial sea más sostenible económicamente.

Uno de los grandes retos al implementar MoE es la complejidad de su producción a gran escala. La carga dinámica de parámetros para cada token presiona la memoria de las GPU, y la comunicación entre los expertos, distribuidos entre múltiples GPU, puede generar latencias significativas al utilizar redes de propósito general. GB200 NVL72 aborda estos obstáculos: permite repartir expertos entre un mayor número de GPU, disminuyendo la presión sobre la memoria y acelerando la comunicación interna gracias a su alto ancho de banda y capacidad de realizar operaciones de cálculo dentro del NVLink Switch.

El impacto de esta tecnología es tangible. Modelos como Kimi K2 Thinking, DeepSeek-R1 o Mistral Large 3 han registrado mejoras significativas en rendimiento, traducidas en un mayor flujo de tokens por segundo, reducciones en el coste por token y menores latencias. Esto no solo beneficia a la eficiencia sino que es crucial para operaciones de IA que requieren respuestas rápidas y precisas.

Organizaciones que lideran el sector de la inteligencia artificial, como CoreWeave y Together AI, ya están adoptando el GB200 NVL72 para manejar tareas desafiantes que abarcan desde traducción instantánea hasta plataformas de agentes inteligentes. A medida que aumenta la demanda de soluciones de IA más eficientes, este sistema promete establecer nuevos estándares en la industria.

El modelo Mixture of Experts y la tecnología detrás de GB200 NVL72 no solo son innovadores para los modelos de hoy, sino que apuntan al futuro de la IA, donde múltiples capas de especialización y coordinación serán indispensables para resolver problemas complejos. En este contexto, las fábricas de IA a gran escala se perfilan como el siguiente gran paso, proporcionando poderosas capacidades de procesamiento compartido para su uso en una multitud de aplicaciones, maximizando la eficiencia y minimizando costes.

La apuesta de NVIDIA y su avance con GB200 NVL72 son un testimonio del potencial que tiene la arquitectura MoE en redefinir los límites de la inteligencia artificial moderna, consolidando su posición como motor clave para la próxima era de modelos de IA avanzados.