En el acelerado universo de la inteligencia artificial, una nueva iniciativa está capturando la atención de la comunidad tecnológica global. Se trata de Open-R1, un proyecto que busca reconstruir de manera abierta el pipeline de entrenamiento de DeepSeek-R1, un modelo que ha revolucionado la manera de abordar el razonamiento en tareas complejas gracias a su uso innovador del aprendizaje por refuerzo.

DeepSeek-R1 destacó inicialmente por su capacidad para abordar problemas de lógica, programación y matemáticas, superando incluso a modelos de renombre como el o1 de OpenAI. Lo que hace realmente único a DeepSeek-R1 es su enfoque en la descomposición de problemas complejos y la verificación de sus propias respuestas, logrando un aprendizaje profundo y eficiente. Basado en el robusto DeepSeek-V3, con un modelo de 671B Mixture of Experts (MoE), ha demostrado un rendimiento comparable a gigantes como Sonnet 3,5 y GPT-4o. Además, logró una eficiencia destacable en los costos, con solo 5,5 millones de dólares invertidos, gracias a innovaciones como la Predicción de Múltiples Tokens (MTP) y la Atención Latente Multi-Cabeza (MLA).

La metodología de entrenamiento de DeepSeek-R1 difiere notablemente de su variante «Zero», que prescindió de la supervisión humana. En su lugar, DeepSeek-R1 se benefició de un «cold start» inicial con ejemplos seleccionados para mejorar la claridad de las respuestas, seguido de fases de refuerzo y refinamiento. Este proceso incluyó la eliminación de salidas de baja calidad mediante recompensas verificables.

A pesar de su impacto, el lanzamiento de DeepSeek-R1 dejó ciertos huecos, ya que los conjuntos de datos y el código utilizados no fueron liberados. Es aquí donde Open-R1 entra en juego, aspirando a reconstruir estos elementos clave para que la comunidad investigadora y la industria puedan replicar e incluso superar los logros de DeepSeek-R1.

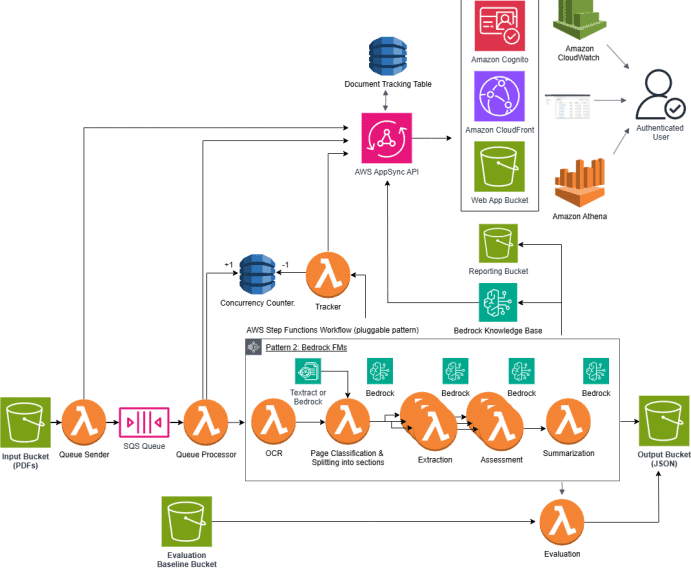

El plan de Open-R1 incluye la replicación de los modelos R1-Distill, la reconstrucción del pipeline de aprendizaje por refuerzo y la validación del entrenamiento multi-etapa. Esta hoja de ruta tiene como objetivo facilitar la conversión de modelos de lenguaje en modelos especializados en razonamiento, aprovechando conjuntos de datos sintéticos.

Más allá del ámbito de matemáticas y programación, esta iniciativa promete un impacto significativo en áreas como la medicina, donde la capacidad de descomponer y analizar problemas complejos es crucial. Open-R1 no es solo un ejercicio técnico, sino una propuesta de colaboración abierta, invitando a la comunidad a participar activamente en la creación de una nueva era de modelos de inteligencia artificial.

La transparencia y colaboración en el aprendizaje por refuerzo están ofreciendo nuevas perspectivas para enfrentar los retos del razonamiento automatizado, fomentando una sinergia innovadora entre ciencia e industria.