Desplegar modelos de aprendizaje automático (ML) en producción suele ser una tarea compleja y que demanda muchos recursos, especialmente para clientes con poca experiencia en ML y DevOps. Para enfrentar este desafío, Amazon SageMaker Canvas se presenta como una solución innovadora, simplificando la construcción de modelos a través de una interfaz de no-código. Esto permite a los usuarios desarrollar modelos de ML altamente precisos usando sus propias fuentes de datos sin necesidad de programar.

Sin embargo, crear el modelo es solo una parte del proceso; implementar estos modelos de manera eficiente y económica es igualmente crucial. Aquí es donde entra en juego Amazon SageMaker Serverless Inference. Este servicio está diseñado para manejar cargas de trabajo con patrones de tráfico variables y períodos de inactividad, gestionando automáticamente la provisión y escalado de infraestructura según la demanda. De esta forma, se elimina la necesidad de gestionar servidores o preconfigurar capacidad.

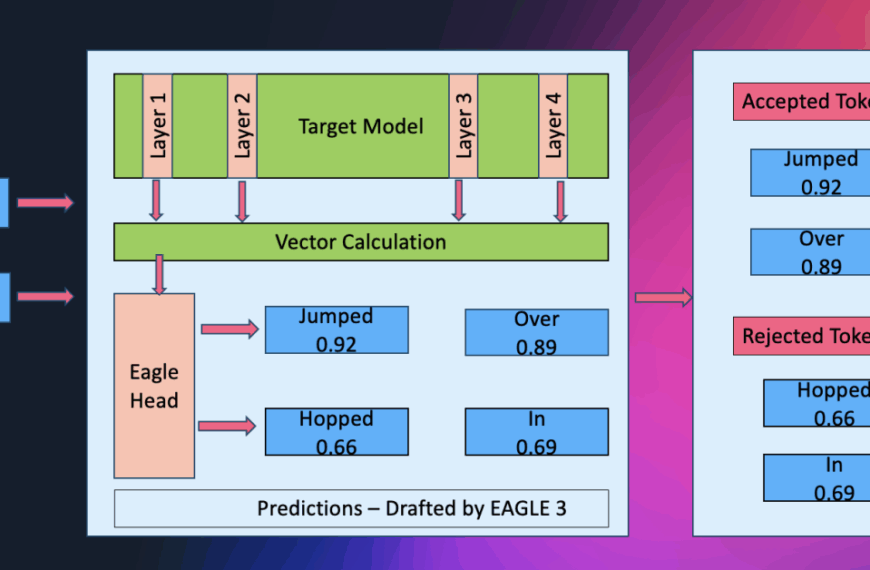

Para desplegar un modelo de ML creado en SageMaker Canvas con SageMaker Serverless Inference, se sigue un flujo de trabajo bien definido. El proceso comienza con la incorporación del modelo entrenado al registro de modelos de SageMaker y culmina en la creación de un endpoint sin servidor. Este método permite pasar rápidamente de la fase de creación a la de predicción en producción sin necesidad de gestionar infraestructura.

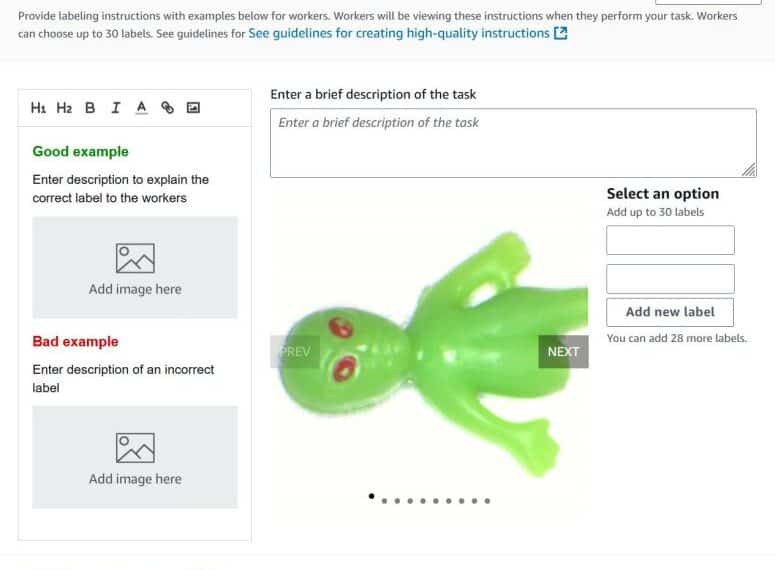

Los requisitos para este proceso incluyen acceso a Amazon S3 y a Amazon SageMaker AI, además de un modelo de regresión o clasificación ya entrenado. Una vez guardado el modelo en el registro de SageMaker, se procede a aprobarlo para su despliegue. Esto implica asignar un nombre al modelo, seleccionar el contenedor adecuado y configurar las variables de entorno necesarias antes de crear la configuración y el endpoint del despliegue.

Esta arquitectura permite a las empresas implementar modelos de ML de manera simplificada, habilitando a organizaciones de distintos tamaños y niveles técnicos a explotar todo el potencial del aprendizaje automático. Al utilizar estas herramientas, la gestión de la infraestructura se vuelve menos compleja, lo que facilita a los equipos comenzar a obtener predicciones de manera rápida y efectiva.