Amazon ha revelado una serie de mejoras significativas en su servicio Amazon Bedrock, centradas especialmente en la función de Importación de Modelos Personalizados. Este avance promete una notable reducción en la latencia de extremo a extremo, tiempos más rápidos para la generación inicial de tokens y un aumento en el rendimiento mediante técnicas avanzadas de compilación de PyTorch y optimizaciones de grafos CUDA. Tal capacidad permite a los usuarios implementar y escalar sus propios modelos fundamentales dentro de la plataforma de Amazon.

La innovación clave en esta actualización es la implementación de una caché de artefactos de compilación. Esta herramienta mitiga los retrasos típicos en la inicialización de modelos sin comprometer las métricas de rendimiento que los clientes esperan. Aunque los usuarios puedan experimentar una pequeña demora al iniciar un modelo por primera vez, las instancias posteriores arrancan con mayor rapidez gracias al uso de estos artefactos previamente generados.

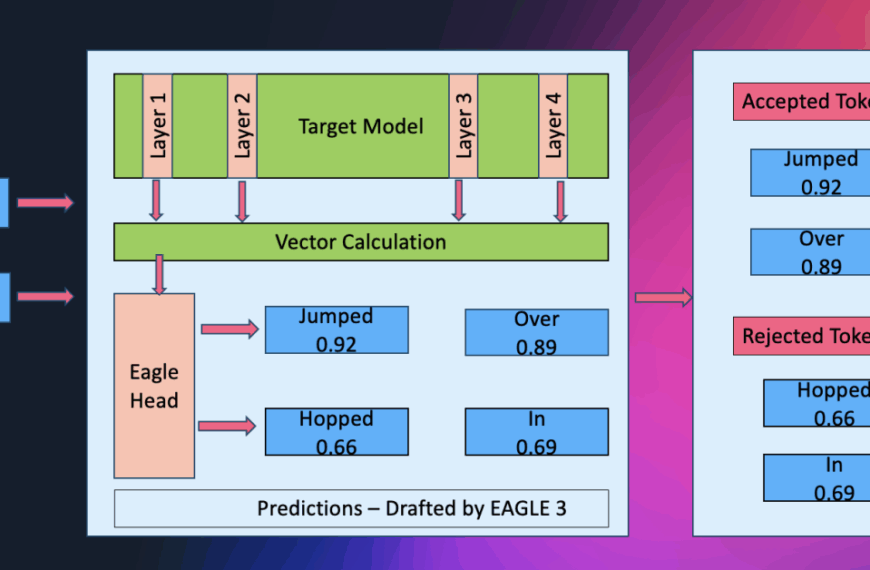

Con el nuevo motor de inferencia, los artefactos de compilación son almacenados y reutilizados, eliminando la necesidad de cálculos repetitivos. Al iniciar la primera instancia de un modelo, este motor genera artefactos como gráficos computacionales optimizados y configuraciones de kernel, que son aprovechados en futuras instancias para facilitar un arranque más eficiente. El sistema se vuelve aún más robusto gracias al uso de identificadores únicos basados en parámetros de configuración, asegurando que los artefactos almacenados se ajusten a las necesidades específicas de cada modelo.

Las pruebas de rendimiento han arrojado resultados favorables en modelos de diferentes tamaños y patrones de carga. Al implementar optimizaciones con un enfoque que va de 1 a 32 solicitudes concurrentes, se ha observado una mejora notable en métricas clave como el tiempo hasta el primer token (TTFT), la latencia general (E2E) y el rendimiento de tokens por segundo (OTPS). Modelos como el Granite 20B y el Llama 3.1 han demostrado mejoras significativas en eficiencia, permitiendo una interacción más fluida y rápida para el usuario.

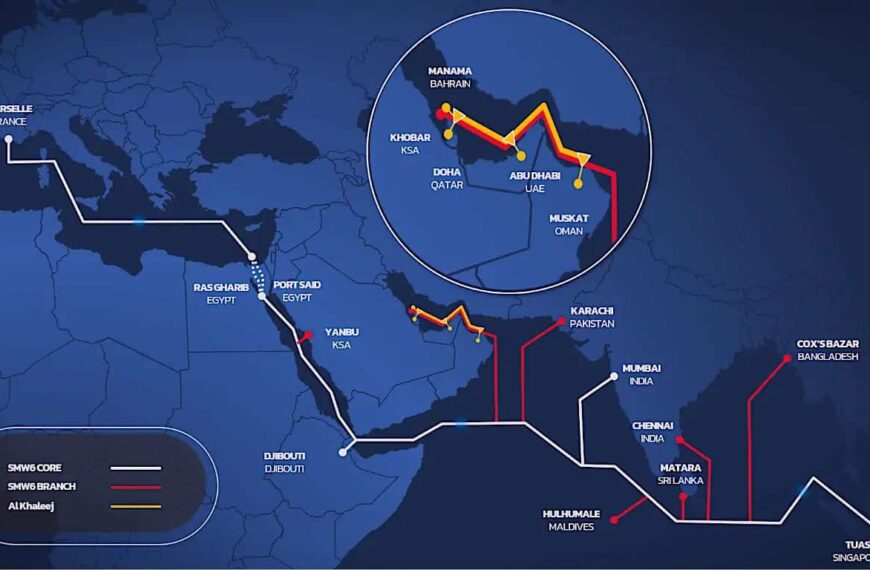

Los análisis también indican que estos beneficios en rendimiento son constantes, independientemente de las condiciones de carga. Esto asegura que las aplicaciones pueden soportar un mayor número de usuarios sin incrementar la infraestructura, siendo una ventaja crucial para servicios críticos como chatbots y generadores de contenido de IA, que necesitan escalar rápidamente durante picos de demanda.

En resumen, estas actualizaciones en Amazon Bedrock no solo mejoran la experiencia del usuario, sino que también optimizan la eficiencia de la infraestructura, adaptándose continuamente a las necesidades del mercado sin comprometer la calidad del servicio ofrecido. Los usuarios actuales de Amazon Bedrock pueden comenzar a beneficiarse de estos avances de manera inmediata, mientras que los nuevos usuarios experimentarán las mejoras desde el principio de su implementación.