Las empresas del sector asegurador enfrentan desafíos crecientes al procesar grandes volúmenes de datos no estructurados provenientes de diversos formatos como PDFs, hojas de cálculo, imágenes, videos y archivos de audio. Estos documentos, que incluyen reclamaciones, videos de accidentes, transcripciones de chats o documentos de pólizas, contienen información crucial para el ciclo de procesamiento de reclamaciones.

Los métodos tradicionales de preprocesamiento pueden ser limitados en precisión y consistencia, afectando la extracción completa de metadatos, la eficiencia del flujo de trabajo y la eficacia en el uso de datos para inteligencia artificial, como la detección de fraudes o el análisis de riesgos. Para superar estos inconvenientes, surge un sistema colaborativo de múltiples agentes. Este conjunto está especializado en clasificación, conversión, extracción de metadatos y tareas específicas del dominio, automatizando la ingesta y transformación de datos no estructurados, mejorando la precisión y facilitando análisis de extremo a extremo.

Para equipos que manejan pocos documentos homogéneos, un sistema de un solo agente puede ser eficiente para automatizaciones básicas. Sin embargo, cuando los datos son diversos, una arquitectura de múltiples agentes ofrece ventajas notables. Los agentes especializados permiten una depuración más precisa y una extracción optimizada, cada uno dirigido a un tipo de dato específico.

El diseño modular también permite una escalabilidad más efectiva, integrando nuevos agentes y mejorando prompts y lógica empresarial sin interrumpir el sistema. Durante la intervención humana, el feedback de expertos se mapea a agentes específicos, apoyando una mejora continua.

Este enfoque se puede implementar con Amazon Bedrock, un servicio gestionado que utiliza modelos de inteligencia artificial para crear agentes conscientes del dominio. Estos agentes procesan datos no estructurados a gran escala, evolucionando al ritmo de las necesidades empresariales.

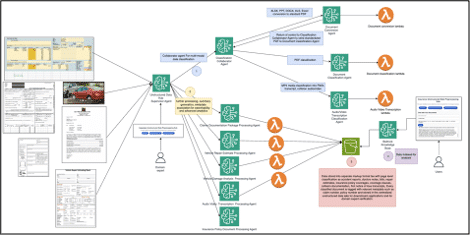

El sistema opera como un centro de preprocesamiento que clasifica datos, extrae metadatos, convierte documentos a formatos estándar y valida campos inciertos con intervención humana. Los resultados y metadatos enriquecidos alimentan un lago de datos no estructurados, base para la detección de fraudes y análisis avanzado.

El flujo de trabajo incluye un agente supervisor central y agentes de clasificación y conversión, integrando intervención humana y almacenamiento en Amazon S3. La modularidad del sistema permite una gestión más eficaz y robusta, facilitando el objetivo de reducir la validación manual y optimizar el procesamiento de datos.

En resumen, transformar datos no estructurados en metadatos enriquecidos permite a las empresas asistir a procesos críticos como la detección de fraudes y optimizar decisiones basadas en análisis avanzados. Este sistema colaborativo promete reducir la necesidad de intervención humana, subrayando su importancia en el futuro del procesamiento de reclamaciones en el sector asegurador.