Amazon ha compartido una serie de recomendaciones prácticas destinadas a optimizar el rendimiento de los procesos de aprendizaje automático (ML) que dependen de la lectura de datos desde Amazon S3, su servicio de almacenamiento en la nube altamente escalable. Estas pautas son especialmente relevantes en el contexto actual, donde los modelos de aprendizaje automático exigen una infraestructura robusta para manejar grandes volúmenes de datos.

Entre las herramientas sobresalientes se encuentran el Amazon S3 Connector para PyTorch y el «Mountpoint for Amazon S3», las cuales facilitan la integración directa de las tuberías de entrenamiento con los datos almacenados en S3, eliminando la necesidad de interactuar con las APIs REST. Esta implementación promete un rendimiento óptimo, integrando de forma eficiente la gestión y acceso a los datos durante el entrenamiento de modelos.

Según investigaciones recientes, optimizar el tamaño de los fragmentos de datos—preferiblemente entre 100 MB y 1 GB—y acceder a ellos de forma secuencial, eleva significativamente el rendimiento. Al almacenar en caché los datos más frecuentemente usados se optimiza aún más la eficiencia, especialmente en entrenamientos que requieren múltiples épocas repetitivas. En pruebas de rendimiento, el Amazon S3 Connector para PyTorch superó otros métodos de acceso en cuanto a la tasa de transferencia de datos, destacándose como la solución más eficaz.

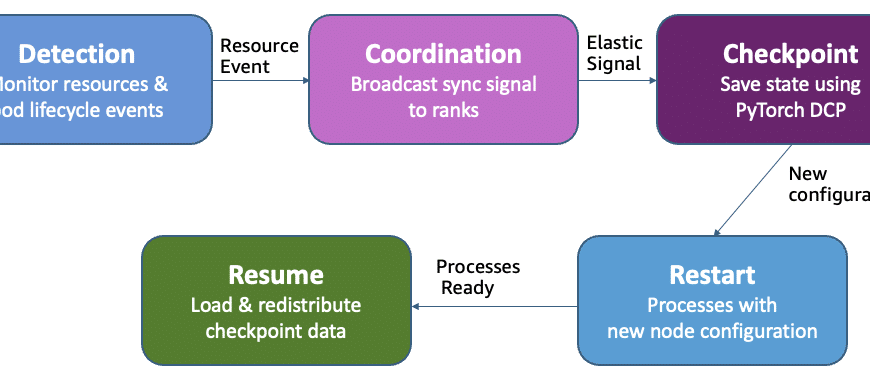

Frecuentemente, los cuellos de botella en las tuberías de entrenamiento de ML se originan en etapas específicas, como la lectura y el preprocesamiento de datos, o en la actualización de los parámetros del modelo, que pueden comprometer la continuidad del flujo de datos y dejar las GPU inactivas.

Para mejorar el rendimiento de las cargas de datos desde Amazon S3, es crucial adoptar un patrón de acceso secuencial a los datos. Este enfoque minimiza la latencia comparado con los accesos aleatorios, que demandan múltiples solicitudes y generan tiempos de espera adicionales. Así, organizar los conjuntos de datos en grandes fragmentos secuenciales se presenta como una estrategia para disminuir la sobrecarga que provoca la gestión de numerosos archivos pequeños en S3.

Además, entre las técnicas de optimización recomendadas se incluyen el uso de clientes de alto rendimiento, la serialización del conjunto de datos en menos y mayores fragmentos, y la implementación de estrategias como la paralelización, el prefetching y el almacenamiento en caché. Estas prácticas son fundamentales para maximizar el rendimiento en procesos de ML que operan en la nube.

Los estudios y benchmarks recientes subrayan que las prácticas propuestas, como el uso de clientes nativos de S3 y la consolidación de datos en fragmentos más grandes, pueden incrementar significativamente el rendimiento del entrenamiento, al reducir el tiempo de inactividad de las GPU y aumentar la eficiencia de los recursos computacionales. Ante el crecimiento de los conjuntos de datos y las cargas de trabajo, es vital seguir ajustando y optimizando la arquitectura de las tuberías de datos para mejorar la eficacia en términos de costos y tiempos de obtención de resultados.