En el ámbito de la inteligencia artificial, los modelos de lenguaje a gran escala, conocidos como LLMs, han cobrado un protagonismo esencial en las investigaciones más recientes. Estos sistemas de IA son capaces de comprender y generar lenguaje natural con gran agilidad y flexibilidad. El avance en el entrenamiento de LLMs ha sido notable, con organizaciones que buscan constantemente ampliar los límites en cuanto a tamaño, rendimiento y eficiencia de estos modelos.

Para apoyar este desarrollo, en 2023, Amazon SageMaker anunció la integración de instancias P5, que soportan hasta ocho de las más recientes GPUs NVIDIA H100 Tensor Core. Estas instancias están diseñadas para facilitar el entrenamiento distribuido de modelos grandes mediante la utilización de tecnologías de red de alto ancho de banda como EFA, logrando así entrenar modelos en paralelo a lo largo de múltiples nodos. Al emplear el servicio de Amazon SageMaker Model Training, las organizaciones han logrado aumentar significativamente la velocidad y eficiencia en sus procesos de entrenamiento.

Uno de los avances más significativos es el uso de la precisión FP8 en el entrenamiento de LLMs, especialmente al utilizar las capacidades de las GPUs NVIDIA H100. El tipo de dato FP8 ha emergido como una herramienta revolucionaria en este campo, al permitir un uso más eficiente de la memoria y una computación más rápida sin comprometer la calidad del modelo. La precisión FP8 significa una reducción en el tamaño de los datos y en los requerimientos computacionales, lo que permite a los investigadores entrenar modelos más grandes con los mismos recursos de hardware o reducir el tiempo de entrenamiento mientras se mantiene un desempeño comparable.

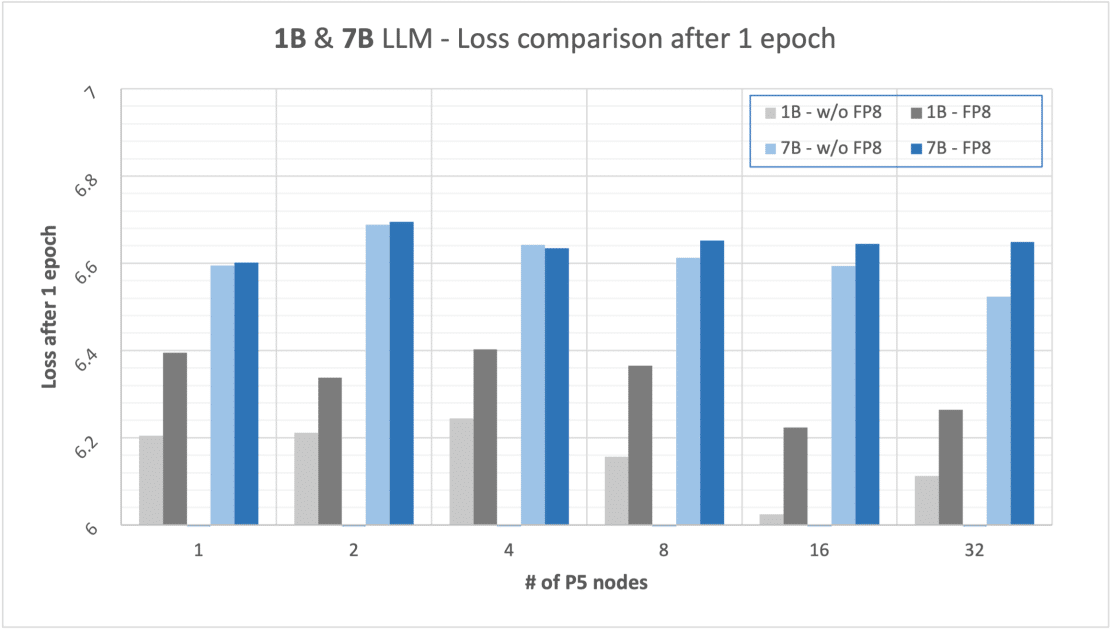

Se han realizado pruebas con modelos de 1B y 7B parámetros, corriendo entrenamientos con y sin FP8. Los resultados muestran que el uso de FP8 incrementa la velocidad de entrenamiento en un 13% para modelos de 1B y en un 18% para modelos de 7B, aunque esto viene con una ligera degradación en la pérdida del modelo tras un epoch. En términos de costo-beneficio, el impacto en la pérdida no es significativo, sólo un 3% más alta para modelos de 1B y un 2% para modelos de 7B, en comparación con el entrenamiento sin FP8.

La adopción de FP8 junto con las instancias P5 de SageMaker representa un hito importante en la evolución del entrenamiento de LLMs, abriendo puertas para que más investigadores y organizaciones adopten estas técnicas. Estas mejoras no sólo aceleran el proceso de entrenamiento de modelos de IA de gran escala, sino que también extienden beneficios a otras áreas de la investigación, como la visión por computadora y el aprendizaje por refuerzo, permitiendo el entrenamiento de modelos más complejos en menos tiempo y con menos recursos. Además, en cuanto a la inferencia, se ha demostrado que los modelos con activaciones en FP8 mejoran significativamente su rendimiento.

En conclusión, los avances en precisión FP8 y el uso de instancias P5 son pasos decisivos hacia la optimización y eficiencia en el entrenamiento de modelos de lenguaje a gran escala, sentando las bases para futuros desarrollos en la comunidad de inteligencia artificial.