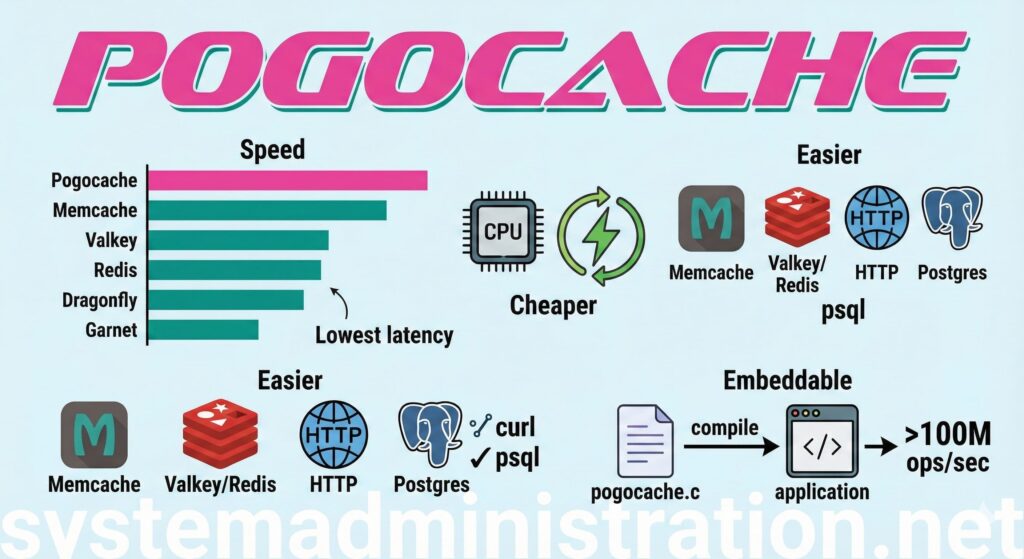

En el dinámico mundo de la infraestructura tecnológica, las herramientas y servicios evolucionan constantemente, aunque las necesidades fundamentales de los desarrolladores permanecen invariables: menos latencia, menor uso de CPU por cada petición y la reducción de sorpresas durante la producción. En este contexto, donde nombres como Redis, Memcached, Valkey o Dragonfly han sido protagonistas durante años, surge Pogocache, un servidor de caché que ha comenzado a captar atención por su optimización desde cero para ofrecer una respuesta rápida y eficiencia en el uso de la CPU.

Pogocache, un software de código abierto escrito en C, se distingue no solo por su rendimiento, sino también por una característica poco habitual en su categoría: la capacidad de hablar múltiples protocolos al mismo tiempo. Esta versatilidad permite a los equipos de desarrollo sustituir o complementar su arquitectura de cacheo existente sin necesidad de reescribir grandes porciones de su infraestructura tecnológica, ya que Pogocache es compatible con protocolos tan diversos como Memcache, RESP (el famoso protocolo de Redis y Valkey), HTTP e incluso el wire protocol de Postgres.

Aunque Pogocache se presente como un caché key-value pensado primordialmente para funcionar como servicio o daemon, ofrece la interesante opción de operar en modo embebido. Esto significa que puede compilarse dentro del propio software de la empresa, eliminando así el coste del networking y maximizando el rendimiento.

El diseño de Pogocache se centra en la implementación de tecnologías como el hashmap shardeado, que distribuye la contención en múltiples fragmentos; el Robin Hood hashing, que mejora el comportamiento de las colisiones; bloqueos ligeros por shard; y un modelo de red basado en hilos con colas de eventos optimizadas. Estas características están diseñadas para asegurar que las operaciones básicas como SET, GET y DEL sean eficientes en cuanto a recursos de CPU y mantengan una latencia estable, un factor crítico cuando el servicio empieza a escalar.

En cuanto a su rendimiento, Pogocache ha sido puesto a prueba con benchmarks específicos, los cuales no garantizan ser los más rápidos de forma universal, pero sí ofrecen cifras concretas y replicables. En pruebas realizadas con una instancia de AWS c8g.8xlarge, Pogocache alcanzó un rendimiento de 3,08 millones de QPS (queries per second), superando a competidores conocidos como Memcache y Redis, lo que destaca su potencial en situaciones donde la latencia y el uso del CPU son cuellos de botella significativos.

Instalar Pogocache es un proceso sencillo que puede realizarse compilando el código fuente o mediante Docker para quienes prefieren no modificar su sistema base. Una vez instalado, arrancar el servicio es tan fácil como ejecutar un comando simple, con diversas opciones de configuración disponibles para personalizar su uso, desde la cantidad de hilos de I/O, hasta la capacidad máxima de memoria y opciones de seguridad como autenticación y el uso de TLS.

Pogocache resulta especialmente útil cuando se busca máxima velocidad en operaciones simples y existe la necesidad de sustituir o complementar Redis o Memcached sin modificar los clientes existentes. Su opción embebida es también una ventaja cuando se desee evitar la latencia de red. Sin embargo, su uso podría no ser ideal en circunstancias donde se requiera un ecosistema de módulos y scripts típicos del mundo Redis, o si es necesaria una alta disponibilidad distribuida sin configuraciones adicionales.

Con preguntas frecuentes abordadas directamente desde su documentación, Pogocache se perfila como una herramienta prometedora para quienes priorizan la eficiencia y velocidad en sus sistemas de caché, ofreciendo una alternativa versátil y poderosa para la infraestructura tecnológica moderna.