Red Hat avanza en su apuesta por la inteligencia artificial empresarial con el lanzamiento de su nuevo Red Hat AI Inference Server, modelos de terceros validados por Red Hat AI y la integración de las API de Llama Stack y el Protocolo de Contexto de Modelos (MCP). Estas novedades buscan potenciar las capacidades de las empresas para fomentar una adopción más rápida y eficiente de la inteligencia artificial.

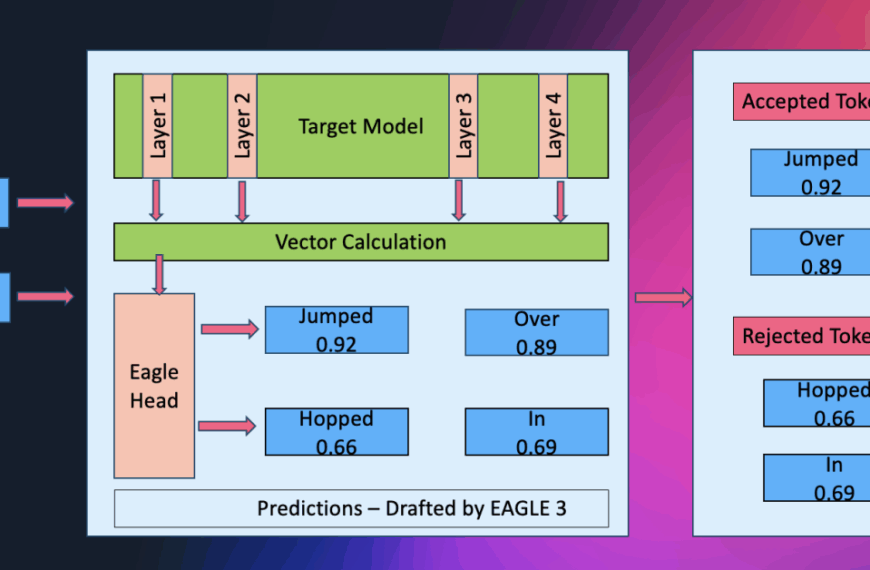

En un entorno donde el software de código abierto se perfila como el impulsor principal de los esfuerzos de IA empresarial, Red Hat AI Inference Server surge como una solución eficiente para la inferencia de modelos. Esta herramienta, junto con modelos validados y optimizados para mayor rendimiento, busca simplificar el despliegue y mejorar la eficiencia en las plataformas de Red Hat AI.

Con su nuevo AI Inference Server, Red Hat promete una inferencia más rápida y costo-efectiva en la nube híbrida, ahora compatible con las últimas versiones de Red Hat OpenShift AI y Red Hat Enterprise Linux AI. Esta herramienta también está disponible como una oferta independiente, proporcionando flexibilidad para desplegar aplicaciones inteligentes.

Por otro lado, los modelos de terceros validados por Red Hat AI, disponibles en Hugging Face, facilitan que las empresas encuentren soluciones adaptadas a sus necesidades específicas. Estos modelos, además de estar optimizados para reducir tamaño y aumentar velocidad, aseguran un menor consumo de recursos y costos operativos.

En cuanto a la integración de APIs, Red Hat está colaborando con Llama Stack y MCP de Anthropic para ofrecer APIs estandarizadas. Estas herramientas permitirán el desarrollo y despliegue eficiente de aplicaciones y agentes de IA, proporcionando una interfaz unificada para la inferencia y la conexión de recursos externos.

La última versión de Red Hat OpenShift AI 2.20 añade mejoras significativas para crear, entrenar y supervisar modelos de IA, tanto generativos como predictivos. Entre estas mejoras se encuentran un catálogo de modelos optimizado, entrenamiento distribuido y un almacén de características para gestionar datos de manera centralizada.

El avance en Red Hat Enterprise Linux AI 1.5 incluye nuevas características para desarrollar y ejecutar grandes modelos de lenguaje, con una disponibilidad ampliada en Google Cloud Marketplace y mejoras multilingües en varios idiomas.

Finalmente, el servicio Red Hat AI InstructLab en IBM Cloud está ahora disponible, diseñado para facilitar la personalización de modelos y mejorar la escalabilidad.

Red Hat vislumbra un futuro donde las organizaciones pueden desplegar cualquier modelo, en cualquier acelerador y en cualquier nube, rompiendo las limitaciones infraestructurales y ofreciendo una experiencia de usuario coherente y rentable. Este esfuerzo por crear una plataforma de inferencia universal promete impulsar una innovación continua en el ámbito de la inteligencia artificial generativa.