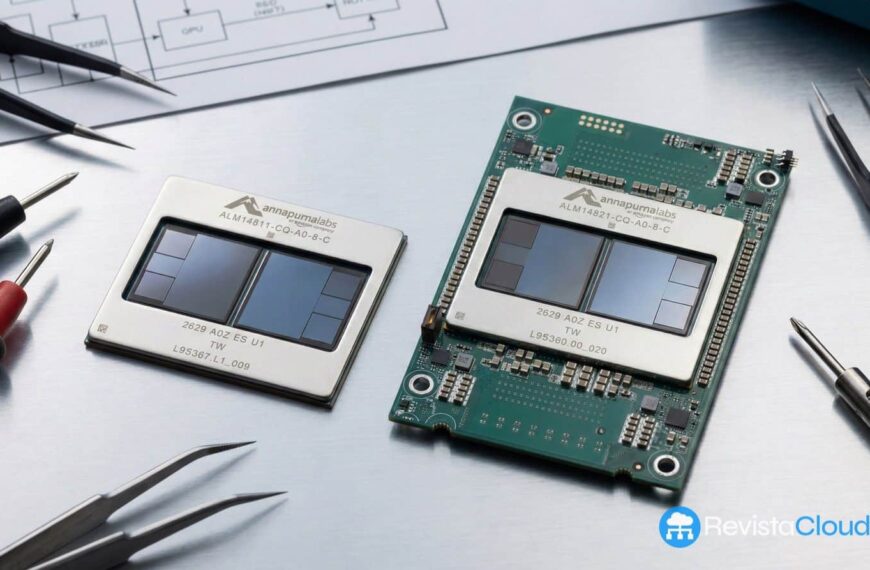

Red Hat ha dado un paso decisivo para fortalecer su colaboración con Amazon Web Services (AWS) en el campo de la inteligencia artificial generativa. La ampliación de esta alianza busca ofrecer a las empresas una forma más eficiente y económica de desplegar modelos de IA generativa a gran escala, sin las complicaciones y costos habituales asociados al uso intensivo de unidades de procesamiento gráfico (GPU). Este movimiento estratégico se centra en maximizar el aprovechamiento de los chips Inferentia2 y Trainium3, diseñados específicamente por AWS para abordar las crecientes demandas de cómputo de la IA.

El enfoque principal de este acuerdo es permitir que los directores de tecnología (CIO) y los responsables de infraestructura adopten la IA generativa en producción mientras mantienen los costos bajo control. En un mundo donde la inferencia de IA generativa requiere procesar millones de solicitudes diarias con mínima latencia, los costos de infraestructura pueden convertirse rápidamente en una barrera significativa. Red Hat y AWS han identificado esta necesidad y proponen una solución que optimiza el uso de «silicio a medida» sin la necesidad de rehacer los sistemas existentes.

La pieza clave de esta colaboración es el Red Hat AI Inference Server, que se ejecutará de manera optimizada sobre los chips de IA de AWS. Esta plataforma promete ofrecer una «capa común de inferencia» para cualquier modelo de IA, independientemente del hardware utilizado. Además, Red Hat estima que esta solución podría mejorar el precio-rendimiento en un 30-40% en comparación con las instancias EC2 que utilizan GPU, una ventaja significativa para las empresas que buscan eficiencia.

Para facilitar la integración, Red Hat y AWS han trabajado en conjunto para desarrollar un operador AWS Neuron para OpenShift, que simplifica el uso de los aceleradores de AWS desde los clústeres de Kubernetes gestionados por Red Hat. También se han lanzado herramientas de automatización con Ansible, permitiendo a las empresas orquestar servicios de IA en AWS de una manera más eficaz.

Red Hat mantiene su mensaje de flexibilidad y operabilidad en cualquier entorno, destacando que su estrategia sigue siendo «cualquier modelo, en cualquier hardware». El objetivo es ayudar a las empresas a avanzar desde la fase de «pruebas de concepto» a una «operacionalización sostenible y gobernada» de la IA en producción. Esto se facilita mediante la integración de tecnologías como OpenShift, Red Hat AI Inference Server, los chips de AWS, y herramientas de automatización como Ansible.

Los productos anunciados estarán disponibles próximamente, con el soporte inicial para los chips de IA de AWS previsto para enero de 2026. Durante el evento AWS re:Invent 2025, Red Hat ha subrayado su compromiso con el modelo de «open hybrid cloud» en la era de la IA, aplicando principios de software libre y portabilidad.

Este movimiento entre Red Hat y AWS demuestra el avance hacia un mundo donde la implementación de IA generativa no solo es técnicamente posible, sino también económicamente viable, abriendo el camino para que más organizaciones adopten estas tecnologías de vanguardia en sus operaciones diarias.