Amazon ha logrado una significativa optimización en el uso de instancias GPU en su plataforma Amazon Search mediante la implementación de AWS Batch para los trabajos de entrenamiento de SageMaker. Este avance gestiona eficientemente las cargas de trabajo de aprendizaje automático (ML), mejorando la eficacia en la formación y evaluación de modelos que ayudan a los clientes a encontrar productos relevantes.

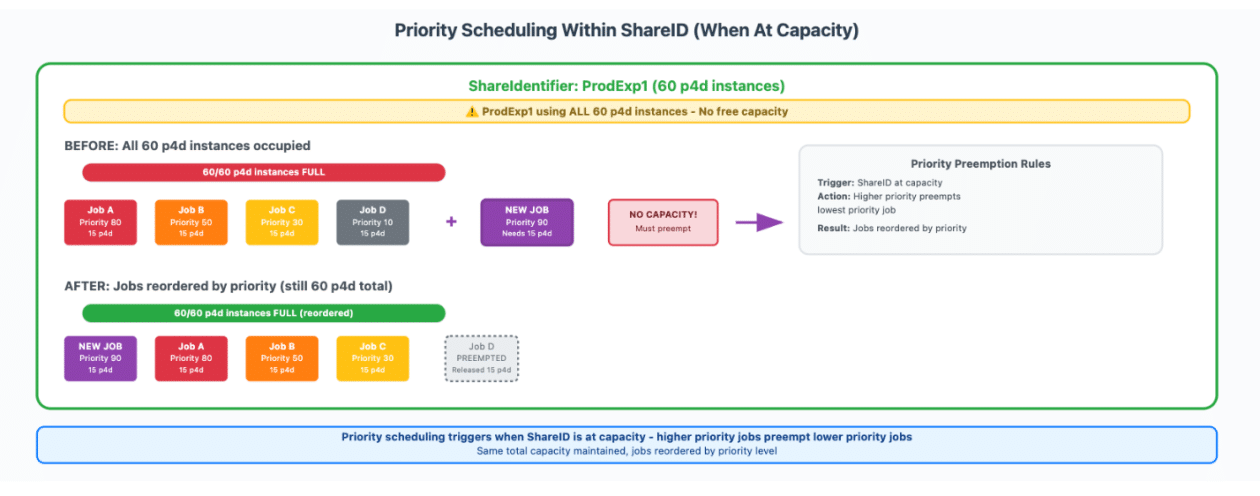

La plataforma Amazon Search emplea cientos de instancias aceleradas por GPU con el fin de entrenar y evaluar modelos de ML. Los científicos de datos a menudo entrenan varios modelos simultáneamente para determinar las características y arquitecturas óptimas. Inicialmente, se utilizaba un sistema de cola FIFO para coordinar los trabajos, pero la necesidad de establecer prioridades más precisas llevó a la búsqueda de una solución mejorada. Los modelos de producción requerían alta prioridad, mientras que las investigaciones exploratorias y otras tareas menos urgentes necesitaban menor prioridad.

Tras evaluar distintas opciones, Amazon optó por AWS Batch para los trabajos de entrenamiento de SageMaker. Esta integración permite gestionar los trabajos según criterios de prioridad y ha mejorado la utilización de instancias de GPU de un 40% a más del 80%. Parte de la implementación consistió en crear entornos de servicio que definieran la capacidad total de GPU y asignaran identificadores de uso para manejar y priorizar las cargas de trabajo.

Para monitorizar los trabajos de entrenamiento, se utilizó Amazon CloudWatch, que ofrece capacidades de alerta en eventos críticos, visibilidad en tiempo real y análisis de tendencias históricas. Esto garantiza la eficiencia operativa de los clústeres de GPU.

El impacto ha sido notable, ya que la adopción de AWS Batch ha permitido realizar más experimentos sin preocuparse por la disponibilidad de recursos. Esto ha reducido los tiempos de espera en las colas y mejorado los resultados del entrenamiento, optimizando tanto el rendimiento de la investigación como los plazos de entrega.

Se recomienda que otras organizaciones con retos similares en infraestructura de ML consideren la integración de AWS Batch con SageMaker. Esta solución no solo simplifica la coordinación de recursos, sino que también proporciona una gestión de colas eficiente y una programación basada en prioridades configurables.