A pesar de que la inteligencia artificial generativa (IA) puede imitar el comportamiento humano de manera notable, la necesidad de proporcionar instrucciones detalladas sigue siendo esencial para producir contenido de alta calidad y relevancia. La ingeniería de prompts, que consiste en la elaboración de estos insumos llamados prompts, guía a los modelos de base (FMs) y a los grandes modelos de lenguaje (LLMs) para generar los resultados deseados. Utilizar plantillas de prompts también puede ofrecer una estructura eficiente para su construcción. Mediante la formulación cuidadosa de estos prompts y plantillas, los desarrolladores pueden maximizar el potencial de los FMs, promoviendo intercambios naturales y contextualmente pertinentes que mejoran la experiencia del usuario. Este proceso no solo requiere creatividad, sino también una profunda comprensión de las capacidades y limitaciones del modelo, convirtiendo la elaboración de prompts en una mezcla de arte y ciencia.

El artículo proporciona información valiosa y ejemplos prácticos para ayudar a equilibrar y optimizar el flujo de trabajo en la ingeniería de prompts. Se enfoca en técnicas avanzadas y mejores prácticas para los modelos proporcionados por Amazon Bedrock. Amazon Bedrock es un servicio completamente gestionado que ofrece una amplia variedad de FMs de alto rendimiento de compañías líderes en IA como Anthropic, Cohere, Meta, Mistral AI, Stability AI y Amazon, todo accesible a través de una sola API. Con estas técnicas de prompts, desarrolladores e investigadores pueden aprovechar al máximo Amazon Bedrock, asegurando una comunicación clara y concisa mientras mitigan posibles riesgos o resultados indeseados.

La ingeniería avanzada de prompts permite aprovechar de manera efectiva el poder de los FMs. Se pueden proporcionar instrucciones dentro de la ventana de contexto del FM, permitiendo incluir contexto específico en el prompt. Al interactuar con un FM mediante una serie de preguntas, declaraciones o instrucciones detalladas, se puede ajustar el comportamiento de salida del modelo en función del contexto específico del resultado deseado.

El proceso de COSTAR es una metodología estructurada que guía la creación de prompts efectivos para los FMs. COSTAR significa:

- Context (Contexto): Proporcionar información de fondo para que el FM entienda el escenario específico y ofrezca respuestas relevantes.

- Objective (Objetivo): Definir claramente la tarea para dirigir el enfoque del FM hacia el cumplimiento de ese objetivo específico.

- Style (Estilo): Especificar el estilo de escritura deseado para guiar al FM a alinear su respuesta según las necesidades requeridas.

- Tone (Tono): Establecer el tono adecuado para que la respuesta resuene con el sentimiento deseado, ya sea formal, humorístico o empático.

- Audience (Audiencia): Identificar el público destinatario para adaptar la respuesta del FM y hacerla apropiada y comprensible para grupos específicos.

- Response (Respuesta): Proporcionar el formato de respuesta requerido, asegurando que el FM entregue información estructurada según la tarea posterior.

Otra técnica avanzada es "Chain-of-Thought" (CoT), que mejora las habilidades de razonamiento de los FMs al desglosar preguntas complejas en pasos más manejables, imitando el proceso de razonamiento humano. Con el prompting tradicional, un modelo de lenguaje intenta proporcionar una respuesta final basada directamente en el prompt, lo que puede resultar en respuestas subóptimas. El CoT aborda este problema guiando al modelo a exponer su proceso de pensamiento paso a paso antes de llegar a la respuesta final, mejorando significativamente el rendimiento en tareas que requieren múltiples pasos de razonamiento, deducción lógica o resolución de problemas complejos.

El "Tree of Thoughts" (ToT) es otra técnica que mejora el razonamiento del FM al desglosar problemas más grandes en un formato ramificado, dividiendo cada problema en subproblemas. Este enfoque permite a los FMs autoevaluarse y razonar a través de cada subtema antes de combinar las soluciones para llegar a la respuesta final. Estudios recientes sugieren que el ToT supera sustancialmente a otros métodos de prompting.

La cadena de prompts es útil para manejar problemas avanzados, donde la salida de un FM se pasa como entrada a otro en una secuencia de modelos, cada uno con ingeniería de prompts para cada paso. Este método permite descomponer tareas complejas y preguntas en subtemas, cada uno como un prompt de entrada diferente. En un caso legal, por ejemplo, se pueden utilizar diferentes prompts para analizar los detalles del caso, proporcionar un resumen conciso y evaluar sus fortalezas y debilidades.

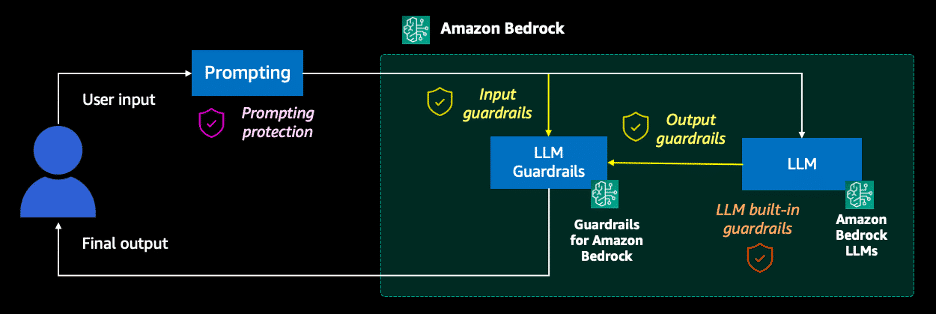

Para garantizar la seguridad y evitar el uso indebido de los prompts, es esencial implementar técnicas de defensa como el uso de guardrails en Amazon Bedrock, que proporcionan una capa adicional de protección contra la generación de contenido dañino o sesgado. Adoptar prácticas de seguridad desde el diseño inicial es crucial para el desarrollo de aplicaciones de IA generativa seguras y eficaces.

En resumen, la ingeniería de prompts combina creatividad y conocimiento técnico, esenciales para maximizar el potencial de la IA generativa. Implementar estas técnicas y mejores prácticas permitirá desarrollar aplicaciones de IA avanzadas y seguras.