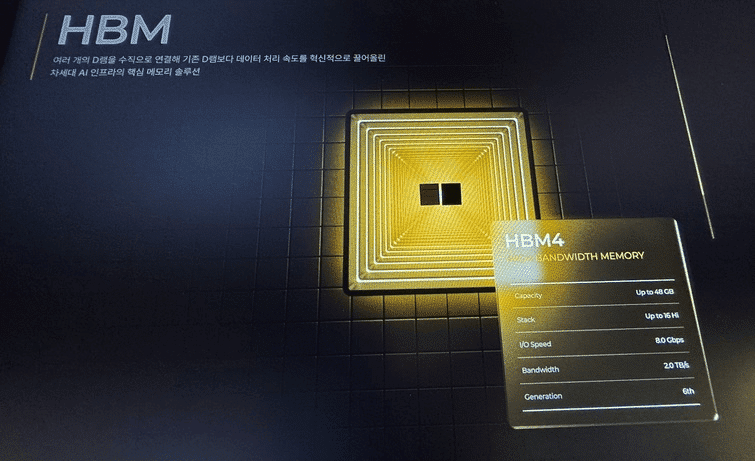

El panorama de la memoria en los centros de datos de inteligencia artificial, dominado por años por la High Bandwidth Memory (HBM), está experimentando una transformación silenciosa. Un nuevo contendiente, SOCAMM y su evolución, SOCAMM2, han comenzado a hacerse notar. Este formato de módulo basado en memoria LPDDR se presenta como una alternativa más modular y densa, en contraste con los diseños fijos e integrados de la DRAM tradicional.

NVIDIA, pionera en este enfoque, incorpora SOCAMM2 dentro de su plataforma Rubin. A diferencia de la HBM, que sigue siendo esencial para las GPUs, SOCAMM tiene un potencial diferente: ofrecer memoria eficiente en términos energéticos y de alta densidad para tareas de CPU, servicios y procesos de inferencia, donde la relación costo-eficiencia es crucial. SOCAMM trata la memoria LPDDR como un componente modular, acercando su integración al procesador y permitiendo configuraciones más flexibles sin necesidad de rediseñar toda la placa madre.

Este avance en modularidad representa un cambio significativo en el mantenimiento y la longevidad de los servidores. Un fallo en la memoria ya no implicará reemplazar componentes integrales del sistema; en su lugar, un bloque de memoria defectuoso podría ser sustituido fácilmente, reduciendo los costos y tiempos de inactividad. Además, la capacidad de extender la vida útil de los servidores mediante actualizaciones parciales es una ventaja considerable en un entorno donde la demanda y la actualización tecnológica son continuas.

Aunque SOCAMM promete beneficios claros, persisten desafíos a la adopción generalizada. Actualmente, SOCAMM no ha alcanzado el estatus de estándar universal, un punto crítico dado que los estándares en la industria definen la escala y, consecuentemente, los costos y la disponibilidad. No obstante, gigantes como Qualcomm y AMD están valorando la incorporación de SOCAMM en sus futuras plataformas, lo que podría acelerar el proceso de estandarización.

Existe, además, una cuestión estratégica que no puede pasar desapercibida: la memoria LPDDR es vital para el mercado móvil, y la creciente demanda por parte de los servidores de IA podría generar tensiones en la cadena de suministro, afectando precios y disponibilidad. La industria ya debate sobre cómo equilibrar la producción entre las memorias de alto valor como HBM y las de gran volumen como LPDDR.

Para los equipos de infraestructura, la evolución de SOCAMM es un indicativo de futuras tendencias en diseño de memoria, con un movimiento hacia una mayor hibridación y modularidad. Sin embargo, se deben considerar posibles riesgos, como la falta de estandarización y el impacto en la cadena de suministro.

En resumen, aunque SOCAMM no reemplazará a la HBM, llena una brecha clave en la arquitectura de los servidores de IA al proporcionar una memoria adaptable, eficiente y más fácil de gestionar. En un paisaje tecnológico en rápida evolución, cada componente que permite una actualización sin rehacer la infraestructura completa se convierte en un activo invaluable.