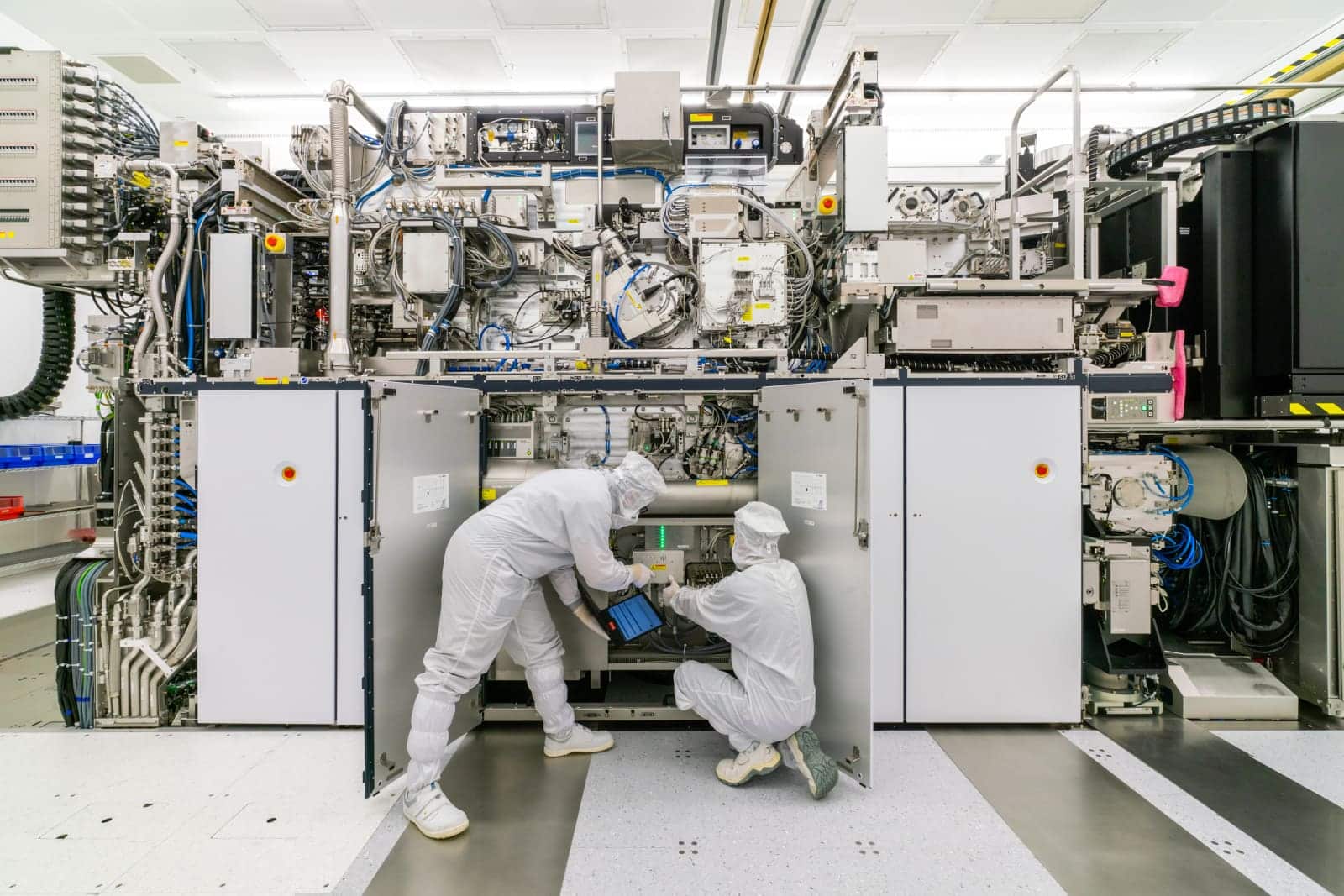

En la feroz carrera por proporcionar modelos de lenguaje con baja latencia, la competencia ha superado la mera publicación de artículos académicos y la superación de benchmarks. La verdadera contienda se libra ahora en los laboratorios de sistemas, donde el principal desafío radica en la implementación efectiva de estos modelos en entornos de producción. En este contexto, el Hao AI Lab de la Universidad de California San Diego (UC San Diego) ha dado un paso significativo al integrar un sistema NVIDIA DGX B200 en su infraestructura, destinado a acelerar el proceso de inferencia de modelos de gran envergadura. Este avance no solo beneficiará al laboratorio, sino que también estará disponible para la comunidad universitaria a través del San Diego Supercomputer Center.

Más allá de ser simplemente un avance en hardware, este desarrollo subraya la relevancia de varios enfoques innovadores que surgieron en el Hao AI Lab. NVIDIA ha mencionado la influencia de las investigaciones de este grupo en soluciones actuales de inferencia en producción, destacando métodos como DistServe, que buscan mejorar la eficiencia sin comprometer la experiencia del usuario.

Tradicionalmente, el rendimiento de los motores de inferencia se evaluaba mediante el throughput, o cantidad de tokens generados por segundo. Sin embargo, esta métrica no refleja completamente la experiencia del usuario, quien valora más la rapidez con la que obtiene respuestas. Así, el concepto emergente de «goodput» cobra importancia, midiendo el rendimiento útil que cumple con los objetivos de latencia establecidos. A medida que los modelos de lenguaje pasan de ser meros prototipos a productos con compromisos reales de servicio, la capacidad de producir resultados de manera rápida y consistente se vuelve esencial.

Al unificar el proceso de inferencia, la estrategia de desacoplamiento —separando las fases de prefill y decode en diferentes unidades de GPU— busca reducir interferencias y mejorar el goodput. NVIDIA lo describe como una manera de escalar sin sacrificar la baja latencia, relacionado con su iniciativa open source, NVIDIA Dynamo, que promueve este tipo de inferencia disgregada en entornos que abogan por la eficiencia operativa.

Para el Hao AI Lab, la inclusión del sistema DGX B200 no solo representa un incremento en capacidad de procesamiento, sino una oportunidad para prototipar y experimentar con mayor rapidez. Este sistema, compuesto por ocho GPUs NVIDIA B200 con una configuración diseñada para manejar grandes cantidades de memoria y comunicaciones internas, se perfila como una herramienta esencial para el desarrollo y entrega de modelos de lenguaje en tiempo real.

Con proyectos como FastVideo, que busca generar clips de vídeo en tiempo real, y Lmgame-bench, que utiliza videojuegos populares para probar modelos, el Hao AI Lab explora nuevos horizontes en la inferencia. Estas iniciativas no sólo sirven de banco de pruebas, sino que representan un cambio de paradigma en cómo se evaluará y mejorará la interacción con los modelos de IA.

En definitiva, la incorporación del DGX B200 en la UC San Diego subraya la importancia emergente de la inferencia como una disciplina autónoma, con sus propias métricas, arquitecturas y herramientas. Mientras el sector continúa avanzando, queda claro que la ventaja competitiva futura no vendrá únicamente de la escala de los modelos de lenguaje, sino de la capacidad para servirlos de manera más eficiente y controlada, optimizando tanto la experiencia del usuario como el coste operacional.