En el dinámico mundo de la inteligencia artificial (IA), los modelos de lenguaje, como el innovador DeepSeek-R1, han emergido como herramientas revolucionarias. Disponibles a través de Amazon Bedrock Marketplace y Amazon SageMaker JumpStart, estos modelos se destacan por sus capacidades de razonamiento, codificación y comprensión del lenguaje natural. No obstante, su despliegue en entornos de producción presenta retos significativos en términos de privacidad de datos, gestión del sesgo en los resultados y necesidad de mecanismos de monitoreo y control sólido.

Las organizaciones que deciden adoptar modelos de código abierto como DeepSeek-R1 deben navegar por un terreno complejo de consideraciones críticas. Estas incluyen el fortalecimiento de las medidas de seguridad para evitar posibles usos indebidos y asegurar la protección de información confidencial. Además, es vital fomentar prácticas responsables de generación de contenido y cumplir con normativas industriales, especialmente en sectores altamente regulados como la salud, finanzas y servicios gubernamentales, donde la privacidad de los datos y la precisión del contenido son esenciales.

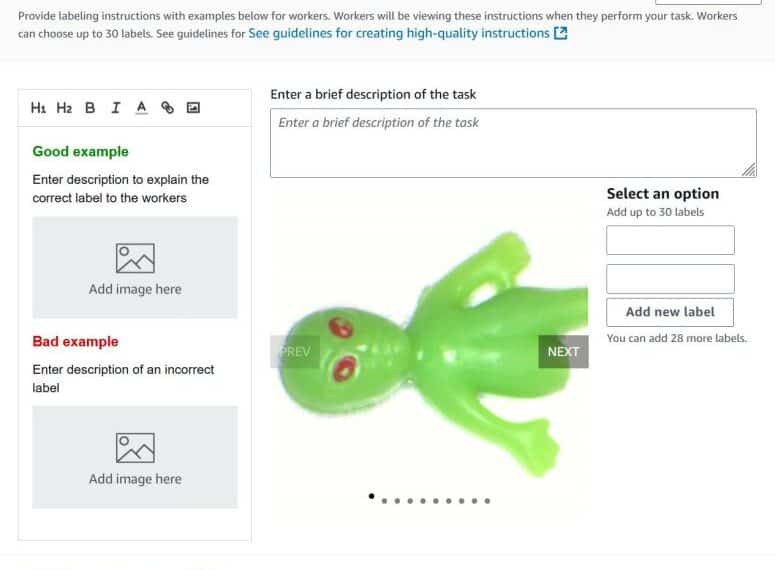

En respuesta a estas preocupaciones, el blog de AWS proporciona una guía exhaustiva para implementar medidas de seguridad robustas utilizando Amazon Bedrock Guardrails. Este sistema ofrece herramientas de seguridad avanzadas que permiten la implementación de salvaguardias para prevenir ataques y filtrar contenido nocivo, adoptando una estrategia de defensa en profundidad.

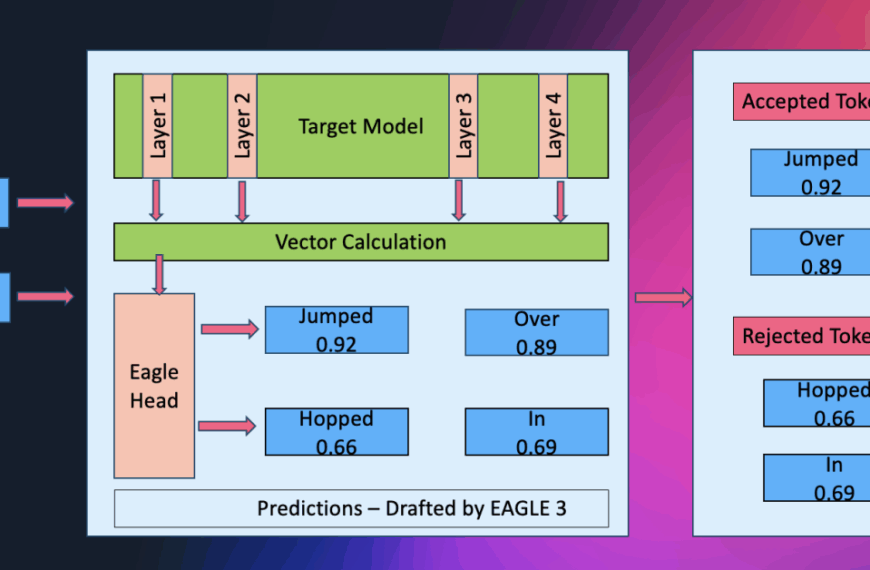

Desde su lanzamiento, DeepSeek-R1 ha demostrado habilidades excepcionales en razonamiento y un rendimiento sobresaliente en métricas industriales. La empresa ha expandido su catálogo con seis modelos adicionales, todos accesibles a través de las soluciones de inteligencia artificial generativa de AWS. Amazon Bedrock asegura un entorno confiable para el alojamiento y operación de estos modelos, adheriéndose a protocolos de privacidad y certificaciones vigentes.

Las salvaguardias configurables de Amazon Bedrock Guardrails son esenciales para el desarrollo de aplicaciones de inteligencia artificial generativa seguras a gran escala. Este sistema se integra con otras herramientas de Amazon, permitiendo personalizar medidas de protección según políticas específicas de IA responsable. El proceso de evaluación asegura que cualquier contenido perjudicial o inapropiado sea interceptado, mediante la verificación de entradas y salidas contra políticas predeterminadas.

En este contexto, la creación de estrategias de defensa en profundidad es crucial para proteger la privacidad del usuario y garantizar un manejo seguro de los modelos de lenguaje. Las organizaciones deben desarrollar enfoques integrales que combinen controles a nivel de modelo con una defensa sólida contra intentos de exfiltración de datos y accesos no autorizados.

La implementación de medidas de protección es central para asegurar un entorno de inteligencia artificial ético y seguro. A medida que esta tecnología sigue avanzando, es imperativo priorizar su uso responsable. Las salvaguardias de Amazon Bedrock son vitales para personalizar las medidas de protección, algo esencial para la generación responsable de contenido. Las organizaciones deben revisar y actualizar regularmente sus controles de seguridad para afrontar nuevas vulnerabilidades y mantenerse adelante en el cambiante campo de la seguridad en la inteligencia artificial.