La inteligencia artificial generativa está experimentando un auge notable, y tecnologías como la Generación Aumentada por Recuperación (RAG) se han convertido en herramientas clave para mejorar la precisión y la fiabilidad de las respuestas generadas por estos sistemas. Al permitir la integración de datos adicionales no considerados durante el entrenamiento inicial de los modelos de lenguaje, RAG contribuye a disminuir la incidencia de «alucinaciones», un fenómeno problemático en la inteligencia artificial donde se proporciona información falsa o engañosa.

Con la creciente integración de la inteligencia artificial en la vida cotidiana y en procesos de decisión críticos, se vuelve imperativo detectar y contrarrestar estas alucinaciones. Actualmente, muchas técnicas se centran exclusivamente en analizar la pregunta y la respuesta; sin embargo, el contexto adicional proporcionado por RAG abre nuevas oportunidades para desarrollar técnicas más eficaces.

Existen varios métodos para diseñar sistemas básicos de detección de alucinaciones en aplicaciones basadas en RAG, evaluados en función de su precisión, capacidad de recuperación y costo. Las técnicas emergentes buscan ser accesibles y fácilmente incorporables, mejorando así la calidad general de las respuestas generadas.

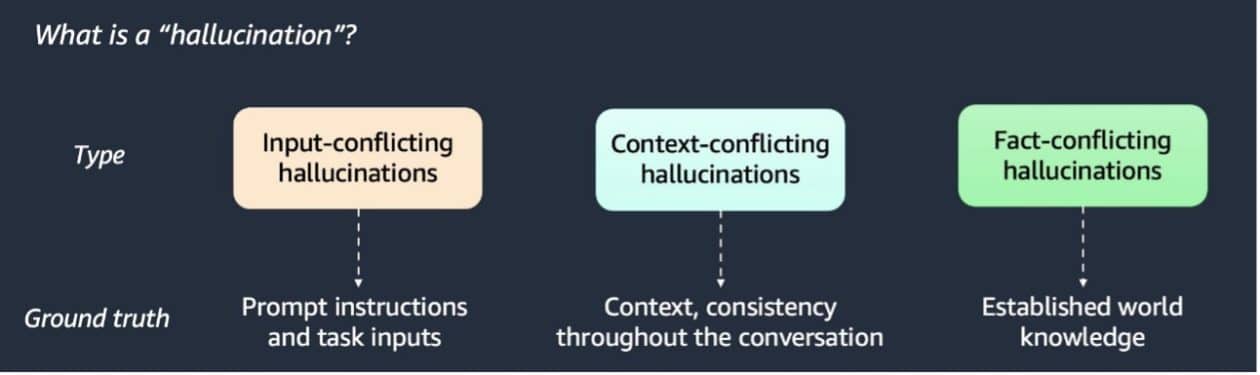

Se han identificado tres tipos de alucinaciones, y múltiples técnicas se han propuesto para su detección, incluyendo detectores basados en modelos de lenguaje (LLM), detectores de similitud semántica y verificadores estocásticos BERT. Cada uno de estos métodos tiene diferentes niveles de eficacia en rapidez y rendimiento, al ser evaluados en conjuntos de datos diversos como artículos de Wikipedia y datos generados sintéticamente.

Para implementar estos sistemas, es esencial tener acceso a herramientas de AWS como Amazon SageMaker y Amazon S3. El sistema RAG necesita almacenar el contexto relevante, la pregunta hecha y la respuesta generada por el modelo de lenguaje para funcionar eficientemente.

Los métodos de detección basados en LLM analizan si la respuesta entra en conflicto con el contexto, mientras que los enfoques de similitud semántica y comparación de tokens ofrecen diferentes formas de identificar inconsistencias. El verificador estocástico BERT destaca por su capacidad de recuperación, aunque ello implica un coste mayor.

Las comparaciones entre las diferentes técnicas sugieren que el enfoque basado en LLM ofrece un buen equilibrio entre precisión y costo. Una estrategia híbrida que combine detectores de similitud de tokens con LLM puede abordar eficazmente las alucinaciones, remarcando la importancia de la adaptabilidad y el análisis en aplicaciones de inteligencia artificial generativa. A medida que las aplicaciones de RAG continúan evolucionando, la detección de alucinaciones se perfila como esencial para reforzar la confianza y la fiabilidad en estos sistemas.