Amazon Web Services (AWS) y OpenAI han forjado una alianza estratégica multianual que posiciona a la nube de Amazon como una pieza clave en los esfuerzos más avanzados de inteligencia artificial (IA) de OpenAI. Este acuerdo, que asciende a 38.000 millones de dólares y se extenderá por siete años, ofrece a OpenAI acceso inmediato a cientos de miles de GPUs de NVIDIA a través de la infraestructura de AWS, con la posibilidad de ampliarse a millones de CPUs para satisfacer las necesidades de entrenamiento e inferencia.

La asociación refleja la creciente demanda de cómputo que requieren los modelos de frontera. Sam Altman, CEO de OpenAI, destacó que escalar la IA requiere computación masiva y confiable, y que esta alianza refuerza el ecosistema necesario para llevar la IA avanzada al mundo. Matt Garman, CEO de AWS, añadió que la infraestructura de AWS será la base de las ambiciones de IA de OpenAI, dado su rendimiento y disponibilidad.

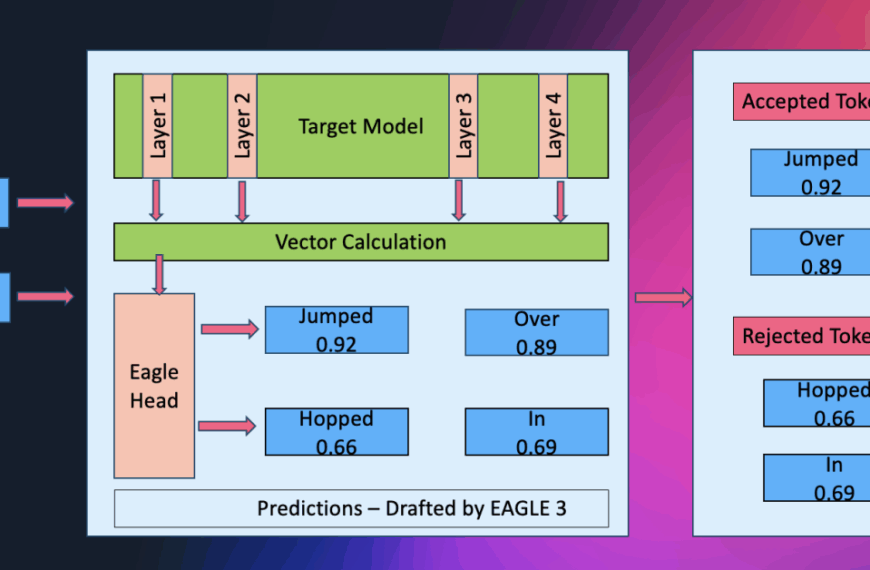

El acuerdo incluye una específica arquitectura para IA basada en Amazon EC2 UltraServers que optimiza la comunicación entre GPUs de NVIDIA, acelerando el entrenamiento de modelos grandes. Esta infraestructura se despliega para soportar tanto inferencias de ChatGPT como el entrenamiento de futuras generaciones de modelos.

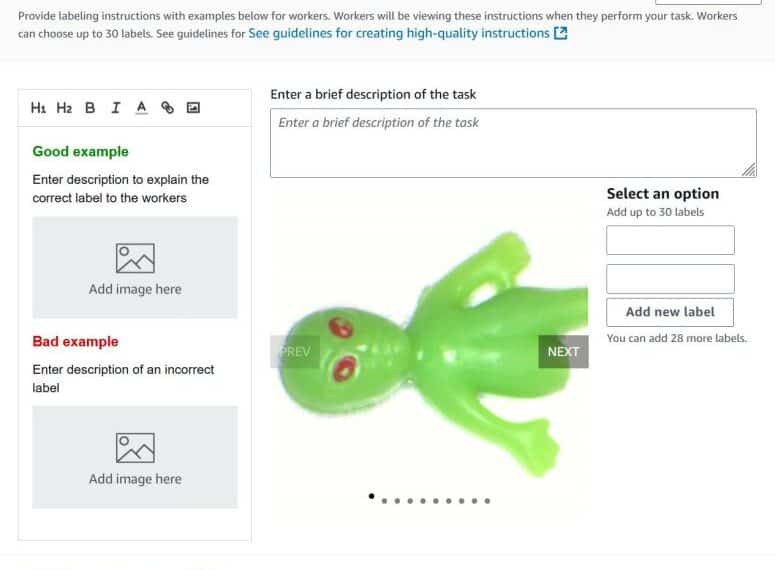

Esta colaboración también consolida una relación existente, con modelos de OpenAI ya disponibles en Amazon Bedrock, lo que ha generado una demanda significativa de clientes provenientes de diversas industrias.

En un contexto donde la industria de la IA compite ferozmente por capacidad, AWS y OpenAI buscan no solo rendimiento y escala, sino también seguridad y fiabilidad para mantener operaciones sólidas. La disponibilidad completa del despliegue está prevista para finales de 2026, con expansiones posibles en años posteriores.

Para las empresas que utilizan ChatGPT o modelos de OpenAI, esta alianza promete mejorar capacidades, reducir latencias y aumentar la frecuencia de innovaciones. AWS destaca su capacidad para construir, implementar y operar clústeres a gran escala, asegurando que OpenAI puede seguir avanzando sin interrupciones.

En el frente de la operación técnica, aunque los detalles específicos son limitados, la alianza se perfila con principios arquitectónicos sólidos que priorizan la reducción de latencias y la maximización de ancho de banda. Con AWS proporcionando la infraestructura robusta, OpenAI asegura así su acceso a recursos confiables para potenciar su desarrollo de modelos de vanguardia.

El acuerdo refuerza la tendencia hacia una carrera multifrente en la computación para IA, donde los proveedores buscan ofrecer combinaciones óptimas de chips y plataformas. A medida que esta colaboración evoluciona, se anticipa que la infraestructura común proporcionará un desarrollo más fluido, eliminando obstáculos que frecuentemente limitan el avance de las pruebas a la producción real.