En un hito reciente para el campo de la inteligencia artificial, investigadores de Microsoft, USC y UC Davis han desarrollado un innovador enfoque denominado BeMyEyes. Esta metodología permite a los modelos de lenguaje, tradicionalmente limitados al texto, como GPT-4 y DeepSeek-R1, realizar tareas visuales sin incurrir en costosos procesos de reentrenamiento. La novedad radica en la capacidad de conectar pequeños modelos visuales a potentes modelos de lenguaje a través de interacciones en lenguaje natural, similar a cómo una persona describe una imagen a un amigo por teléfono. El modelo visual lleva a cabo el análisis de imágenes y proporciona descripciones, que el modelo de lenguaje utiliza para razonar y resolver problemas complejos.

Los resultados obtenidos con este enfoque son notables. Al equipar a DeepSeek-R1 con un modelo visual de tan solo 7 mil millones de parámetros, el sistema logró superar a GPT-4o, el último modelo multimodal de OpenAI, en varias pruebas desafiantes. Esto desafía la noción predominante de que se requieren grandes modelos multimodales para lograr resultados efectivos en tareas que combinan visión y lenguaje.

A diferencia de la tendencia habitual de desarrollar gigantescos modelos multimodales que procesan texto e imágenes simultáneamente, BeMyEyes opta por la colaboración entre agentes especializados. Un agente perceptivo, el pequeño modelo visual, extrae información visual y la describe, mientras que el agente de razonamiento, el modelo de lenguaje más potente, interpreta estas descripciones y aplica razonamientos complejos para llevar a cabo las tareas.

Este diseño modular presenta varias ventajas significativas. En primer lugar, ofrece una mayor eficiencia de costos, permitiendo ajustar o entrenar únicamente pequeños modelos visuales para tareas específicas, en lugar de reentrenar modelos de lenguaje completos. Además, la flexibilidad es otro de los beneficios, ya que es posible incorporar nuevos modelos de lenguaje sin la necesidad de un exhaustivo reentrenamiento. Este enfoque facilita también la transición hacia dominios especializados, como la imagenología médica, sustituyendo únicamente el modelo de percepción.

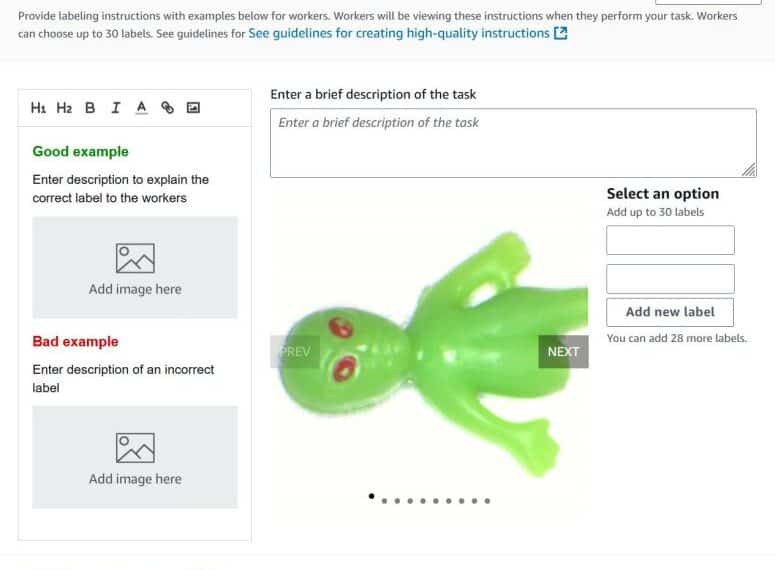

El éxito de BeMyEyes se debe, en parte, a la capacidad de los modelos para comunicarse a través de conversaciones continuas. Esta interacción permite al modelo de razonamiento realizar preguntas de seguimiento y solicitar clarificaciones, lo que mejora la precisión de las respuestas y, en consecuencia, el rendimiento global del sistema. Los investigadores han utilizado un proceso de entrenamiento que emplea GPT-4o para crear diálogos sintéticos entre los modelos, lo que permite mejorar su colaboración y comunicación.

Estos hallazgos tienen profundas implicaciones para el futuro de la inteligencia artificial. BeMyEyes demuestra que un equipo bien coordinado de modelos especializados puede superar a los sistemas monolíticos, sugiriendo que no siempre es necesario construir modelos de mayor tamaño para obtener mejores resultados. Este marco también abre la puerta a la democratización de capacidades multimodales avanzadas, permitiendo a la comunidad de código abierto acceder a ellas sin requerir los significativos recursos asociados a los modelos de gran escala.

Con el avance de nuevos modelos de lenguaje, éstos podrían adquirir capacidades multimodales de manera rápida y efectiva mediante marcos como BeMyEyes, promoviendo un futuro donde la inteligencia artificial funcione más como una sinfonía de modelos especializados en lugar de un único modelo generalista masivo. En definitiva, el enfoque plantea que, en ocasiones, la solución más eficaz no reside en crear herramientas más grandes, sino en enseñarles a trabajar juntas de manera armoniosa.