Meta ha dado un paso significativo en el ámbito de los modelos de lenguaje grande (LLM) con el lanzamiento de Llama 3.3 70B, ahora accesible en Amazon SageMaker JumpStart. Este desarrollo promete revolucionar la implementación de modelos de lenguaje en producción al combinar alto rendimiento y eficiencia en el uso de recursos computacionales.

El nuevo modelo, Llama 3.3 70B, ha sido diseñado para ofrecer resultados comparables a los de su predecesor de mayor tamaño, Llama 3.1 405B, logrando, no obstante, una operación significativamente más económica. Esta eficiencia se traduce en una operación cinco veces más barata, lo que lo convierte en una solución atractiva para organizaciones que buscan optimizar sus costos sin sacrificar calidad.

La clave de esta optimización reside en la arquitectura basada en un transformador avanzado, que incorpora un mecanismo de atención mejorado. Esta estructura permite reducir de manera considerable los costos asociados con la inferencia. Durante su creación, el equipo de Meta empleó un robusto conjunto de datos que abarca aproximadamente 15 billones de tokens, combinando contenido web con ejemplos sintéticos creados para perfeccionar los LLM. El resultado es un modelo robusto y versátil, capaz de entender y generar respuestas eficientemente en diversas tareas.

Entre las características distintivas de Llama 3.3 70B se encuentra su metodología de entrenamiento avanzada. El modelo ha pasado por un proceso de afinamiento detallado, que incluye el aprendizaje por refuerzo a partir de comentarios humanos (RLHF). Esta técnica ha permitido al modelo alinear sus respuestas de manera más efectiva con las preferencias humanas, manteniendo altos estándares de rendimiento.

En pruebas de rendimiento, Llama 3.3 70B ha demostrado una consistencia impresionante, posicionándose a menos del 2% de diferencia en seis de diez evaluaciones estándar de inteligencia artificial respecto a su versión más grande, y superándola en tres categorías.

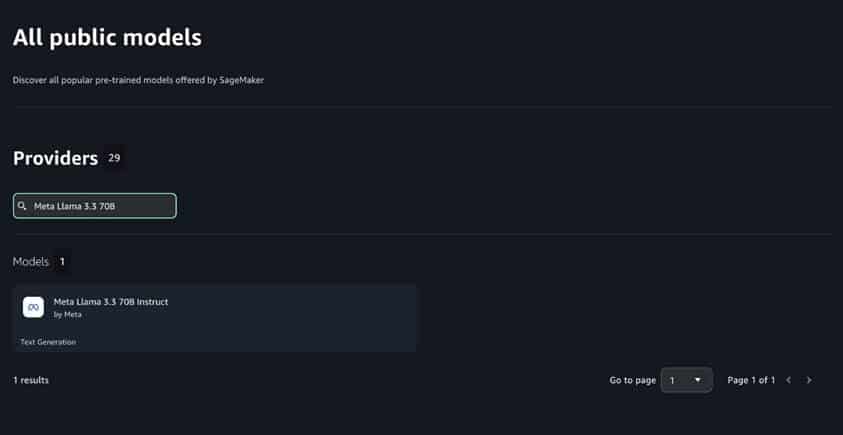

Amazon SageMaker JumpStart no solo facilita el acceso a este potente modelo, sino que también proporciona herramientas para evaluar, comparar y seleccionar modelos preentrenados. Los usuarios pueden implementar Llama 3.3 70B mediante una interfaz de usuario sencilla o utilizando el SDK de Python, lo que confiere flexibilidad en su despliegue.

Además, las capacidades avanzadas de SageMaker AI, como la carga rápida, el almacenamiento en caché de contenedores y la opción de escalar a cero, permiten a las organizaciones manejar sus despliegues de manera eficiente. De esta forma, se maximizan las ventajas de la arquitectura optimizada de Llama 3.3 70B, evitando gastos innecesarios.

En conjunto, Llama 3.3 70B, junto con las funcionalidades de SageMaker AI, ofrece una solución integral para las organizaciones que desean mejorar el rendimiento y reducir costos en sus operaciones de modelado de lenguaje.