Los modelos de lenguaje de gran tamaño (LLMs, por sus siglas en inglés) están emergiendo como una herramienta poderosa en el campo de la traducción automática, donde su capacidad para interpretar correctamente el contexto es uno de sus atributos más destacados. Estos modelos están empezando a desafiar a soluciones convencionales de traducción neuronal, ofreciendo traducciones que no solo son precisas, sino también culturalmente apropiadas.

Una de las ventajas más significativas de los LLMs es su habilidad para entender y aplicar contextos y matices culturales en las traducciones. Esto es crucial, ya que, por ejemplo, una pregunta como «¿Te desempeñaste bien?» puede tener diferentes implicaciones en función del contexto. Al traducir esta pregunta en un entorno deportivo, un LLM puede elaborar una versión en francés que refleje fielmente ese contexto particular, mejorando así la naturalidad y precisión de la traducción.

Las empresas que buscan mejorar la calidad de sus contenidos traducidos están adoptando estas tecnologías. La combinación de la traducción automática con la edición posterior (MTPE) representa un enfoque que combina las virtudes de la automatización con el ingenio humano, lo que se traduce en ahorros de costos, entregas más rápidas y una mejor experiencia para el usuario final.

A pesar de sus ventajas, los LLMs no son infalibles. Existen desafíos como la inconsistencia en la calidad de traducciones en ciertos pares de idiomas y la potencial inexactitud, conocida como «alucinación», en algunas salidas. Además, estos modelos no han logrado universalizar un estándar para integrar el conocimiento de traducciones previas, lo cual es fundamental para mantener la coherencia en proyectos a largo plazo.

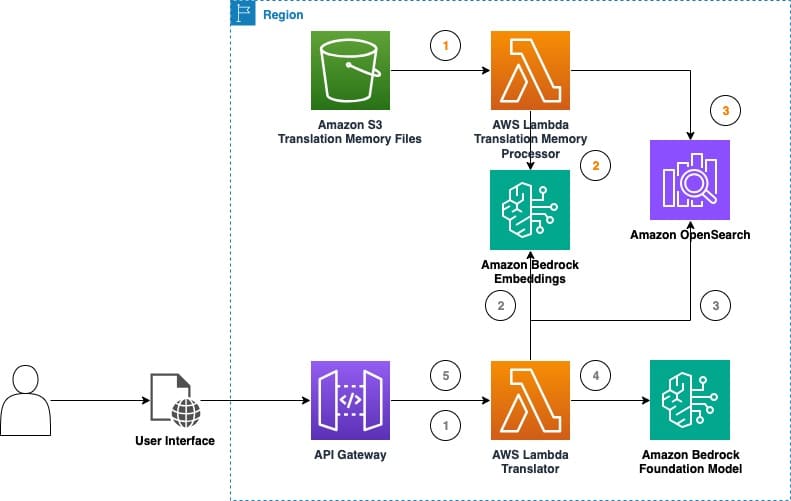

En la búsqueda por potenciar las capacidades de los LLMs, surgen iniciativas que integran técnicas de memoria de traducción (MT) y archivos TMX, esenciales para las herramientas de traducción asistida por computadora. Las memorias de traducción almacenan segmentos de texto previamente traducidos, ayudando a los traductores a ser más eficientes y mantener la consistencia en textos repetitivos.

La integración de estas memorias con LLMs no solo promete mejorar la calidad de las traducciones, sino que también reduce el esfuerzo de posproducción. Esto se puede lograr de manera efectiva utilizando estrategias que exploten el aprendizaje contextual de los LLMs y técnicas de ingeniería de prompts, permitiendo a las empresas aprovechar modelos preexistentes sin incurrir en complicaciones operativas significativas.

En un esfuerzo por poner a prueba y refinar estas capacidades, se ha desarrollado un «parque de pruebas de traducción LLM», diseñado para experimentar con diferentes configuraciones de inferencia y evaluar el impacto de nuevas técnicas en la calidad de las traducciones.

Los resultados preliminares son prometedores. En pruebas simples, los LLMs han demostrado su habilidad para ajustar el contexto de las frases, mejorando así la experiencia del usuario. Experimentos con memorias de traducción han mostrado incrementos significativos en la calidad de las traducciones, sugiriendo que esta combinación de tecnologías puede ser clave para futuros proyectos de traducción y localización.

La industria de la traducción automática está en constante evolución, y con la continua exploración y mejora de los LLMs, el proceso de localización promete volverse más eficiente, ofreciendo oportunidades a empresas de todos los tamaños para acceder a contenido traducido de alta calidad.