La implementación de inteligencia artificial generativa se encuentra en un momento de transición, empujada por la necesidad de reducir la latencia y los costos asociados al uso de modelos de lenguaje de gran tamaño (LLMs). Estos modelos, utilizados en una diversidad de aplicaciones, desde asistentes virtuales hasta análisis de datos complejos, presentan desafíos operativos significativos debido a su proceso secuencial de predicción, que incrementa el tiempo de respuesta y, en consecuencia, afecta la experiencia del usuario.

Con el propósito de mitigar estos inconvenientes, se ha desarrollado un novedoso esquema de almacenamiento en caché intermedia sin servidor, que aprovecha patrones de datos repetidos para optimizar el funcionamiento de aplicaciones basadas en LLMs. Esta propuesta se sustenta en el uso de Amazon OpenSearch Serverless y Amazon Bedrock, soluciones tecnológicas avanzadas que integran modelos de inteligencia artificial de alto rendimiento a través de una única API. Esta configuración permite a los desarrolladores construir aplicaciones de IA generativa con un enfoque en la seguridad, privacidad y responsabilidad.

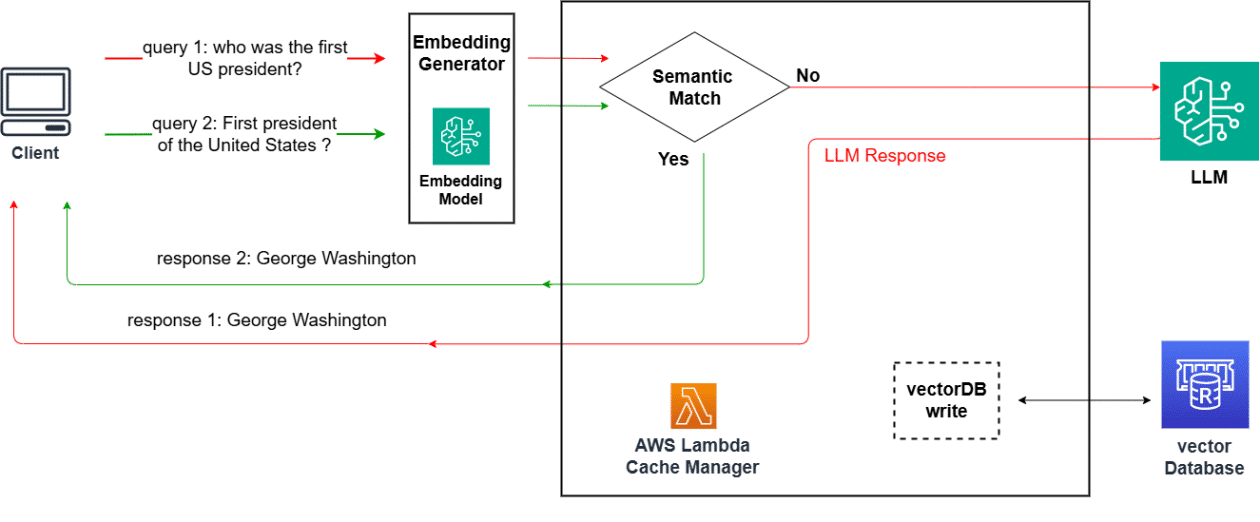

La caché semántica actúa como un filtro inteligente, interceptando solicitudes expresadas en lenguaje natural antes de que sean procesadas por el LLM. Su capacidad para almacenar consultas similares permite que estas se recuperen rápidamente sin requerir una nueva generación de respuesta por parte del modelo, lo que resulta crucial para lograr un equilibrio entre la efectividad y la reducción de costos.

En entornos aplicativos variados, estos sistemas de caché pueden ser configurados para maximizar la eficiencia según las necesidades específicas. Por ejemplo, un asistente de IA diseñado para el sector turístico puede priorizar el almacenamiento de un amplio rango de respuestas, incluso con ciertas superposiciones. Por otro lado, asistentes para atención al cliente pueden requerir asignaciones precisas para cada consulta, minimizando así la posibilidad de errores.

Este sistema innovador basa su operación en el almacenamiento de incrustaciones vectoriales numéricas de las consultas, que luego son transformadas y almacenadas como vectores. Al utilizar modelos de incrustación gestionados por Amazon Bedrock, se facilita la creación de bases de datos vectoriales robustas con OpenSearch Serverless, asegurando un sistema de caché eficaz.

La implementación de esta estrategia no solo mejora los tiempos de respuesta, sino que también contribuye notablemente a la reducción de costos. En comparación con los modelos de generación tradicional, las incrustaciones son más económicas, promoviendo una eficiencia financiera significativa en una variedad de usos.

Este avance no solo representa una mejora tecnológica en la gestión de LLMs, sino que optimiza de manera integral la experiencia del usuario. Los desarrolladores ahora pueden ajustar de manera precisa los umbrales de similitud, balanceando adecuadamente los aciertos en caché con la reducción de colisiones. El resultado es una infraestructura ágil y económica, adaptada a la compleja realidad del procesamiento de lenguaje natural.