La reciente integración de modelos de lenguaje masivo (LLM) con la innovadora técnica de Generación Aumentada con Recuperación (RAG) está reconfigurando la forma en que interactuamos con contenido digital, motores de búsqueda y asistentes virtuales. Esta técnica permite que los LLM se conecten a bases de conocimiento externas, mejorando la precisión y relevancia de las respuestas sin necesidad de un exhaustivo reentrenamiento.

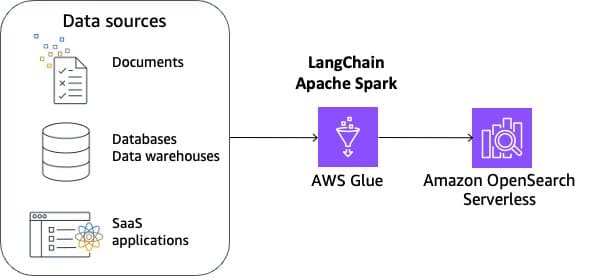

El desafío principal al aplicar RAG es la gestión de datos externos, que se presenta en diversos formatos como archivos y registros de bases de datos. Para superar este reto, se ha introducido una solución que emplea LangChain, un marco de código abierto que opera en conjunto con herramientas de Amazon Web Services (AWS), incluyendo AWS Glue y Amazon OpenSearch Serverless.

Esta solución ofrece una arquitectura de referencia para la indexación escalable de RAG, lo cual permite consumir data variada y desarrollar aplicaciones capaces de responder a preguntas complejas con una base de conocimiento integrada. El proceso abarca la ingesta, transformación, vectorización y gestión de índices, asegurando respuestas precisas.

La preparación de datos, esencial para operación fiable de RAG, se enfoca en limpiar y normalizar documentos para mejorar la exactitud de los resultados, incorporando también consideraciones éticas y de privacidad mediante el filtrado de información sensible. Utilizando Amazon Comprehend y AWS Glue, se identifican y eliminan datos sensibles antes de procesar los documentos con Spark. Este procesamiento divide la información en fragmentos que se convierten en incrustaciones para luego almacenarse en un índice vectorial.

Este enfoque de procesamiento no solo es novedoso, sino que facilita una personalización flexible, garantizando calidad y relevancia contextual en los datos procesados. Además, con tecnologías como Apache Spark y Amazon SageMaker, es posible equilibrar adecuadamente la latencia y eficiencia de costos para las búsquedas semánticas, vital para contextos donde la rapidez y exactitud son claves.

En resumen, la implementación de RAG a gran escala para integrar vastos volúmenes de datos externos representa un avance considerable en inteligencia artificial. Esto redefine la integración y utilización de información externa por los modelos de lenguaje, proporcionando soluciones más precisas y contextualmente adecuadas.