En un entorno donde las soluciones de inteligencia artificial demandan respuestas instantáneas y eficaces, Amazon ha presentado una serie de mejoras en su plataforma SageMaker HyperPod que prometen revolucionar el manejo de modelos de lenguaje grande (LLM). Estas innovaciones buscan resolver el desafío de la latencia y los costos crecientes que enfrentan las aplicaciones al procesar documentos extensos y mantener conversaciones prolongadas.

El proceso de inferencia de LLM, crucial para el funcionamiento de estas aplicaciones, sufre generalmente de una alta latencia debido a la necesidad de recalcular los mecanismos de atención cada vez que se genera un nuevo token. Esta tarea, fundamental para contextos largos, genera una significativa sobrecarga computacional. Para abordar este problema, Amazon ha introducido un sistema de almacenamiento en caché de clave-valor (KV), que facilita el almacenamiento y la reutilización de vectores de atención previamente calculados, logrando así una reducción considerable en los tiempos de respuesta.

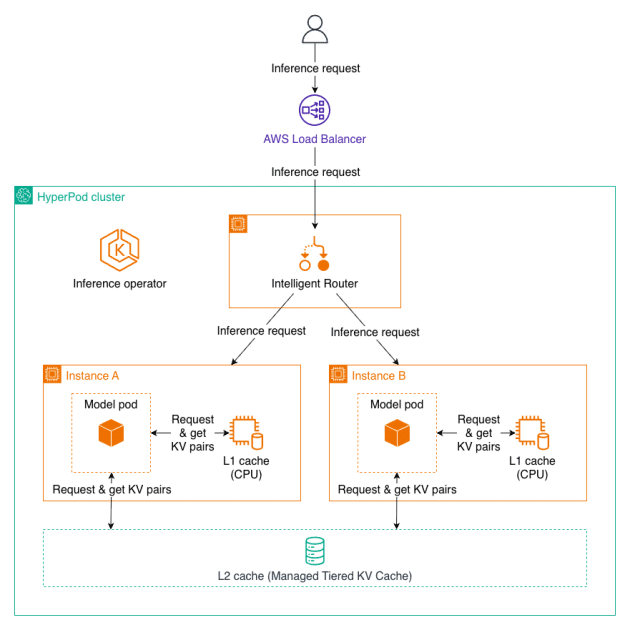

A partir de hoy, Amazon SageMaker HyperPod incorpora capacidades avanzadas de Gestión de Caché en Niveles y Enrutamiento Inteligente, gracias al Operador de Inferencia de HyperPod. Estas características ofrecen un aumento del rendimiento en las tareas de inferencia de LLM, con una disminución de hasta el 40% en el tiempo de espera para el primer token y una reducción de los costos computacionales en un 25% en contextos complejos y conversaciones extensas.

La combinación de un cacheo eficiente y un enrutamiento inteligente busca maximizar el uso del caché KV, especialmente útil en aplicaciones que reutilizan el mismo contexto documental o conversacional. Esta estrategia permite, por ejemplo, que abogados que trabajan con contratos complejos obtengan respuestas instantáneas a consultas de seguimiento, eliminando esperas prolongadas. Asimismo, sectores como el sanitario y el servicio al cliente podrán sostener conversaciones largas y procesar un gran volumen de solicitudes con mayores tasas de éxito y eficiencia económica.

Las funcionalidades nuevas incluyen un sistema de Gestión de Caché de KV en Niveles, que optimiza el manejo de memoria en distintos niveles (CPU y almacenamiento escalonado), junto con un Enrutamiento Inteligente que emplea estrategias especializadas para maximizar la eficiencia del caché. Además, Amazon ha integrado herramientas de observabilidad que permiten el monitoreo detallado de métricas, utilizando Amazon Managed Grafana.

Para aprovechar estos avances, las empresas deben implementar un clúster de HyperPod en Amazon EKS y habilitar las nuevas funciones en los endpoints de inferencia, consolidando a Amazon como un pionero en ofrecer soluciones de inteligencia artificial robustas y de fácil acceso. Este desarrollo promete transformar el análisis de documentos y conversaciones a gran escala, haciéndolos más viables desde el punto de vista económico y operativo.