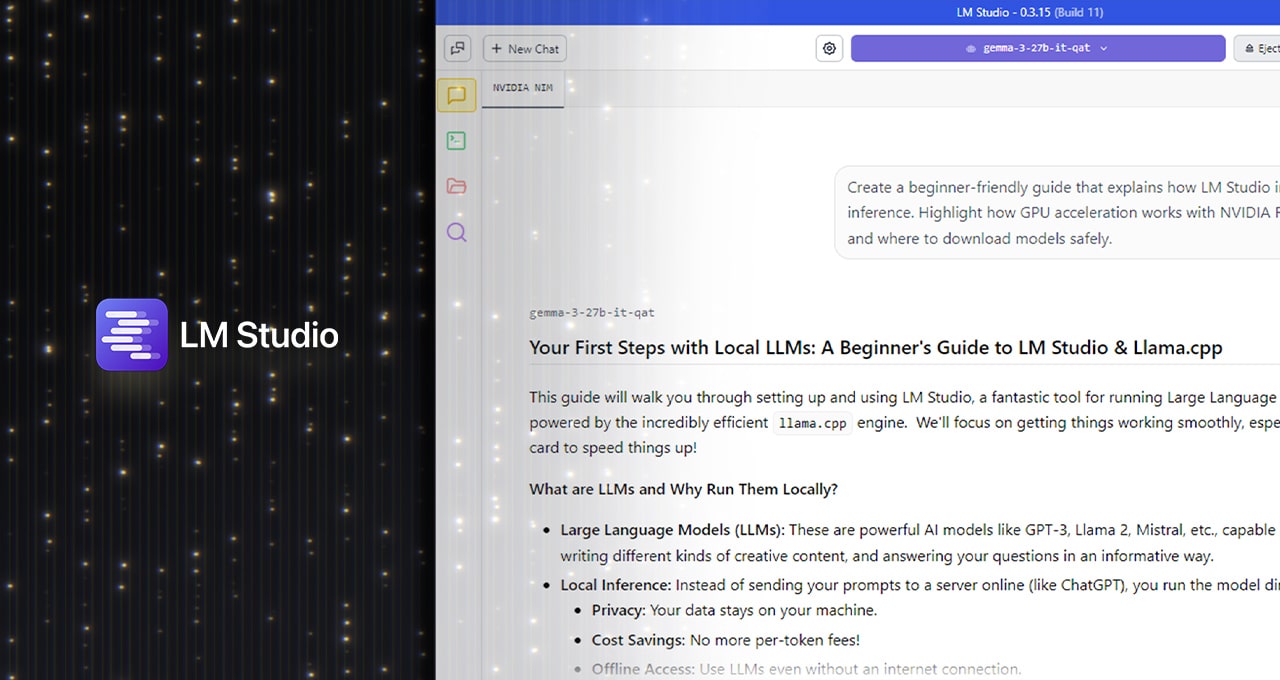

En un entorno donde la inteligencia artificial generativa se entrelaza cada vez más con el quehacer diario de desarrolladores y usuarios avanzados, la ejecución local de modelos de lenguaje (LLM) ha pasado de ser una curiosidad experimental a una robusta alternativa con claras ventajas. En este contexto, LM Studio se erige como uno de los entornos más versátiles y accesibles para ejecutar inteligencia artificial de forma local, sin la necesidad de depender de servicios en la nube.

Con su última actualización, la versión 0.3.15, LM Studio se integra de manera nativa con CUDA 12.8, la versión más reciente del entorno de ejecución de NVIDIA. Esta integración permite maximizar el rendimiento de las GPUs RTX, desde las series 20 a las más nuevas con arquitectura Blackwell, optimizando tiempos de inferencia y el uso de recursos del sistema, lo que resulta en una experiencia de IA generativa optimizada directamente en computadoras personales.

Ejecutar modelos de lenguaje localmente a través de LM Studio ofrece beneficios estratégicos significativos frente a la dependencia de la nube. Entre estos beneficios destacan la privacidad absoluta, ya que los datos del usuario permanecen en su equipo; una latencia mínima con respuestas casi instantáneas; costos reducidos sin tarifas de uso ni límites de APIs externas; y una integración flexible que permite conectar los modelos con flujos de trabajo personalizados y herramientas locales.

LM Studio, que opera sobre la eficiente librería llama.cpp, ofrece la capacidad de desplegar modelos populares como Llama 3, Mistral, Gemma u Orca, adaptándose a diversas configuraciones de hardware gracias a su soporte de múltiples formatos de cuantización.

La integración con CUDA 12.8 resulta esencial para desbloquear todo el potencial de las GPUs RTX. Las optimizaciones introducidas incluyen innovaciones como CUDA Graphs, que mejora la eficiencia del procesamiento en un 35 %, y Flash Attention, que incrementa el rendimiento de los transformers en contextos largos en un 15 %. La ejecución completa de modelos en la GPU elimina cuellos de botella en la CPU, y la compatibilidad con toda la gama RTX, desde la 2060 hasta las más avanzadas, ofrece una aceleración escalable para usuarios de PC y estaciones de trabajo.

Esta optimización se refleja en pruebas recientes con modelos como DeepSeek-R1-Distill-Llama-8B, que muestran una mejora del rendimiento del 27 % respecto a versiones anteriores, gracias a las innovaciones en CUDA y llama.cpp.

Además de aumentar el rendimiento, LM Studio 0.3.15 introduce funciones avanzadas para desarrolladores. Un editor de prompts mejorado facilita la gestión de inputs más largos, mientras que el nuevo parámetro tool_choice proporciona control granular sobre el uso de herramientas externas. Asimismo, su modo API OpenAI-compatible permite integrar LM Studio en flujos de trabajo de forma sencilla.

Gracias a su diseño modular, LM Studio se está consolidando como una herramienta esencial en sectores como el desarrollo de software, la investigación académica, la creación de contenido y el uso avanzado de sistemas operativos como Linux o macOS. Su compatibilidad multiplataforma y soporte de diversos runtimes multiplican sus aplicaciones.

Activar el runtime de CUDA 12.8 en LM Studio es un proceso sencillo. Los usuarios pueden descargar el software desde su sitio oficial, seleccionar CUDA 12 llama.cpp en la sección de runtimes, y establecerlo como el entorno predeterminado en las configuraciones, maximizando así la aceleración por hardware.

El futuro de la inteligencia artificial personal se perfila como local y acelerado. Con LM Studio, en combinación con GPUs NVIDIA RTX y CUDA 12.8, se ofrece una plataforma sólida para quienes buscan implementar IA de forma privada, rápida y personalizada. Con evolución constante y apoyo comunitario activo, LM Studio representa el equilibrio entre rendimiento, accesibilidad y control, abriendo puertas a nuevas posibilidades en el uso de modelos de lenguaje.