El equipo de Inteligencia Artificial de Salesforce ha dado un significativo paso adelante al implementar Amazon Bedrock Custom Model Import para optimizar sus despliegues de modelos de lenguaje grande (LLMs). Anteriormente, la gestión de infraestructura en Salesforce era una tarea compleja que requería meses de esfuerzos para ajustar instancias y motores de servicio, lo cual incrementaba tanto el tiempo como los costos operativos, especialmente debido a las reservas de capacidad de GPU.

La colaboración con Amazon Bedrock ha permitido que el equipo de Salesforce se enfoque en el desarrollo de modelos y la lógica empresarial, aliviando cargas operativas. La integración fue planificada meticulosamente para evitar interrupciones en las cargas de trabajo productivas, permitiendo a Salesforce mantener sus API y servicios de modelo intactos, lo que resultó en un despliegue sin tiempo de inactividad.

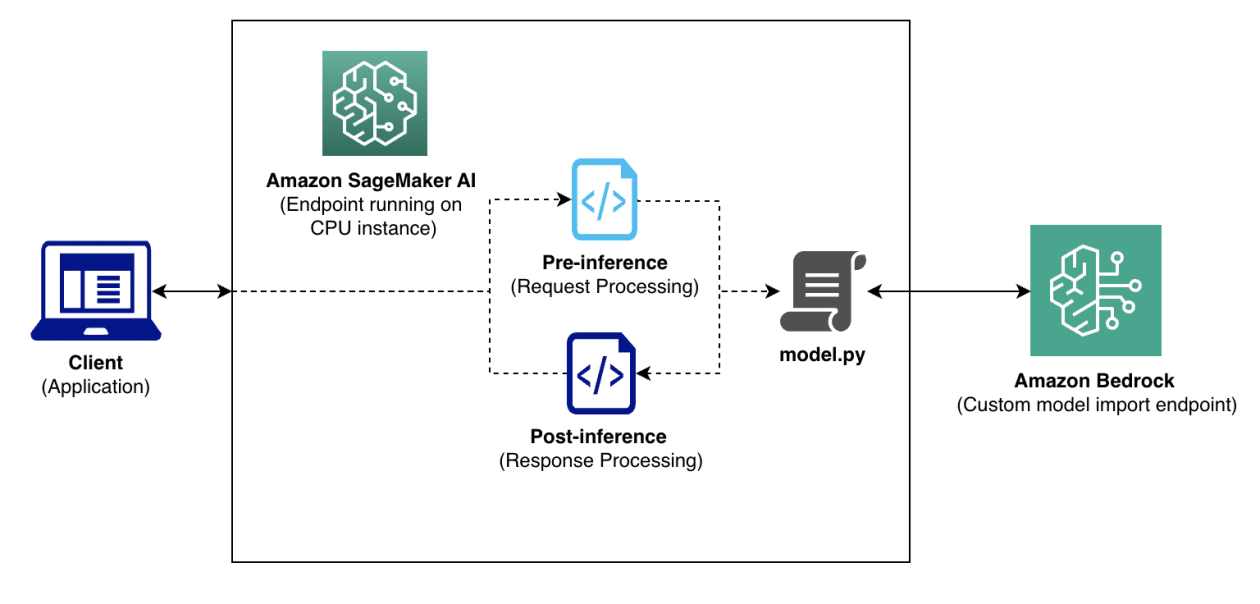

Esta implementación incluye mejoras significativas en el proceso de entrega de modelos. Ahora, al guardar los artefactos del modelo en Amazon S3, se registra utilizando el API de Amazon Bedrock Custom Model Import, permitiendo un tiempo de despliegue aproximado de solo una hora. Este enfoque aumenta la eficiencia ya que Amazon Bedrock pre-carga los modelos, eliminando la necesidad de descargar componentes al iniciar el contenedor.

Salesforce ha comprobado además la capacidad de escalabilidad de Amazon Bedrock mediante pruebas de carga. Los resultados fueron concluyentes: en niveles bajos de concurrencia, se logró una latencia 44% menor en comparación con modelos base, y se mantuvo un rendimiento estable incluso bajo cargas pesadas. La capacidad de autoescalado del sistema asegura que el servicio pueda responder eficazmente a las demandas de carga en tiempo real.

Desde el punto de vista operacional, Salesforce ha logrado una reducción del 30% en el tiempo necesario para iterar y desplegar modelos, junto con un ahorro de costos de hasta el 40%, gracias a la flexibilidad del modelo de pago por uso. Estas ventajas son especialmente útiles en entornos de desarrollo donde los recursos de GPU se utilizan únicamente durante períodos activos.

La experiencia de Salesforce subraya la importancia de validar la compatibilidad de modelos antes de proceder a su despliegue y de considerar el impacto de los tiempos de inicio en modelos de mayor tamaño. Para las organizaciones que buscan simplificar el despliegue de modelos de lenguaje a gran escala, el caso de Salesforce se presenta como una guía efectiva para abordar desafíos operativos y de costo sin comprometer el desempeño.