En un contexto de rápida evolución tecnológica, la inteligencia artificial generativa ha impulsado la creación de nuevos modelos de lenguaje de gran tamaño (LLMs). Uno de los más destacados es Amazon Nova, un modelo avanzado de fundación que se caracteriza por su costo-efectividad y está disponible a través de Amazon Bedrock. Desde su lanzamiento en 2024, equipos de inteligencia artificial han comenzado a migrar sus cargas de trabajo hacia este modelo prometedor.

Sin embargo, un desafío notable en este proceso de transición es la adaptación de las indicaciones, o «prompts», que fueron diseñadas para modelos anteriores. Esto requiere una optimización minuciosa para asegurar que funcionen eficientemente con Nova. Amazon Bedrock facilita esta tarea con una herramienta de optimización automática de prompts, que acomoda estos a las características específicas del nuevo modelo.

El proceso de migración busca, principalmente, mantener o mejorar el rendimiento en comparación con el uso de modelos anteriores. Esto implica una evaluación rigurosa del nuevo modelo y la optimización iterativa de los prompts, basándose en un análisis comparativo del rendimiento.

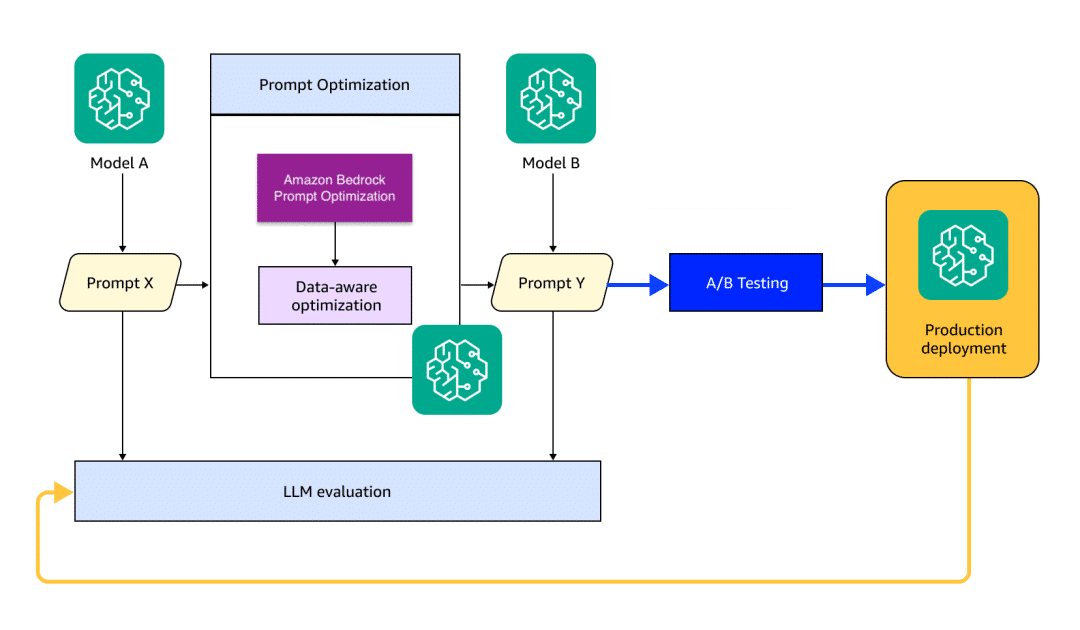

Se ha desarrollado un paradigma de migración para LLMs que contempla la evaluación continua del modelo y la generación y optimización de prompts. Este enfoque se ha probado con éxito en tareas como la clasificación multinivel de texto, resúmenes y respuestas a preguntas, utilizando la metodología de Generación Aumentada por Recuperación (RAG).

El proceso de migración hacia Amazon Nova abarca cuatro etapas fundamentales. Inicia con la evaluación del modelo de origen, donde se recolectan métricas de rendimiento específicas. Luego, los prompts se actualizan automáticamente en su estructura y lenguaje. Finalmente, pruebas rigurosas validan el rendimiento del modelo adaptado en entornos de producción.

En términos de optimización, Amazon Bedrock ofrece una metodología que facilita el refinamiento estructural de los prompts, mejorando la interacción con los modelos de fundación. Esta optimización no solo ajusta los prompts, sino que también maximiza el rendimiento de los LLMs en base a métricas específicas establecidas por el usuario.

La implementación de tales procesos ha mostrado avances notables. En la optimización del modelo Amazon Nova Lite, se logró aumentar la precisión de un 77.75% a un 83.25%, y con la ayuda de un optimizador, la precisión alcanzó un 87.75%.

Lecciones clave emergen de este proceso: la importancia de contar con datos de alta calidad y relevancia, definir adecuadamente las métricas para cada caso de uso y adoptar un enfoque iterativo en la optimización. Este método es aplicable no solo a Amazon Nova, sino que también se extiende a otros procesos de migración de modelos, permitiendo que organizaciones optimicen sus capacidades de inteligencia artificial generativa de manera substancial.