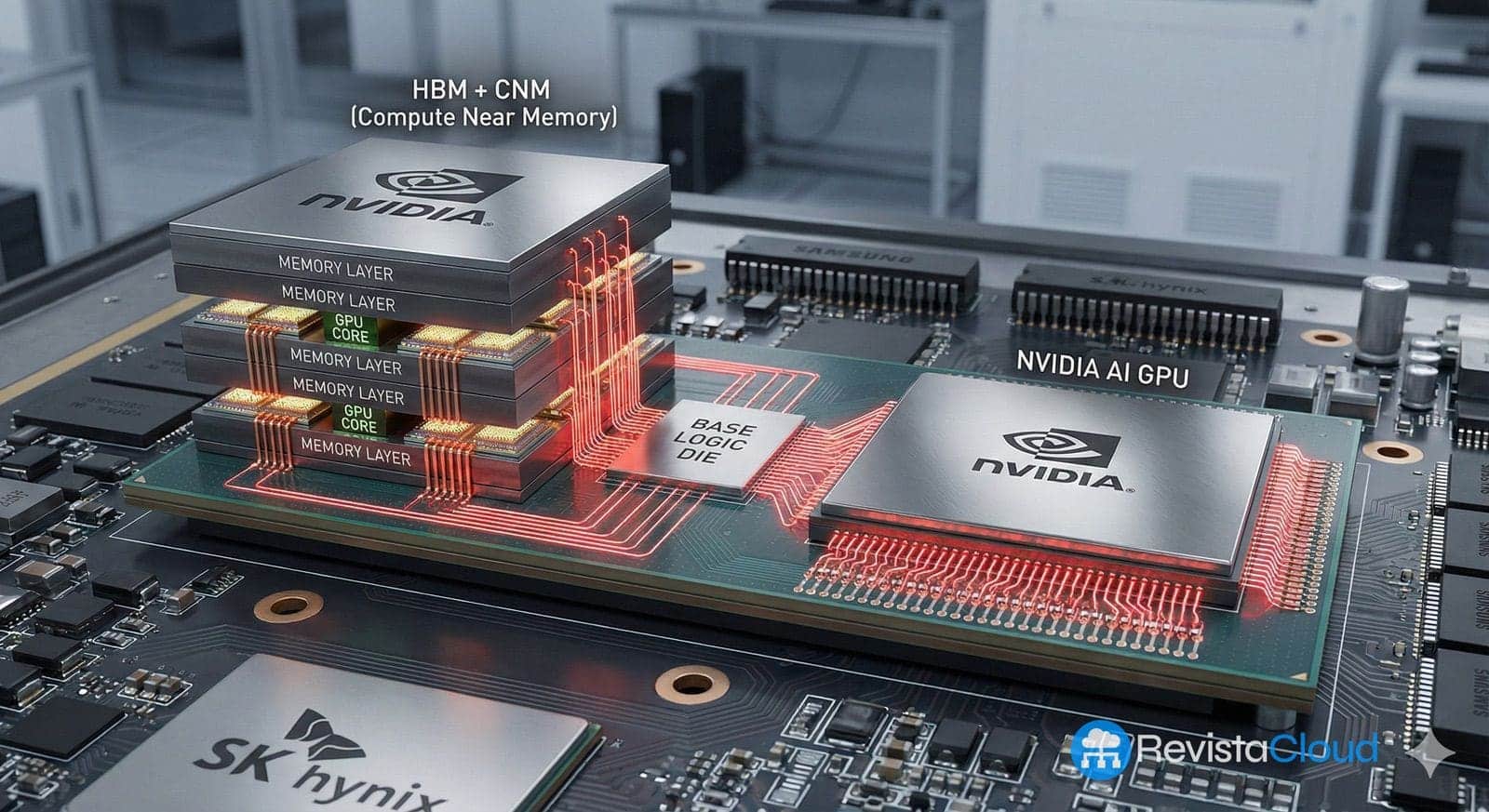

La carrera por la evolución de la inteligencia artificial está llevando a la industria de los semiconductores a explorar nuevas fronteras que hasta hace poco parecían propias de la ciencia ficción. En un desarrollo reciente desde Corea del Sur, se ha revelado que gigantes tecnológicos como Meta y NVIDIA están considerando la posibilidad de integrar núcleos de GPU directamente dentro de la memoria HBM (High Bandwidth Memory) de nueva generación. Este audaz movimiento se llevaría a cabo en colaboración con los veteranos del sector SK hynix y Samsung Electronics.

Si esta innovadora arquitectura se convierte en una realidad comercial, podría revolucionar el diseño de chips para centros de datos de inteligencia artificial, difuminando aún más la línea divisoria entre memoria y procesador. HBM busca resolver el problema del escaso ancho de banda entre el procesador y la RAM en sistemas de alto rendimiento. La tecnología actualmente organiza capas de DRAM apiladas interconectadas verticalmente, resultando en módulos compactos que ofrecen un ancho de banda superior al de las memorias tradicionales, con un menor consumo de energía por bit transferido.

El avance actual sugiere un paso más allá: mover la capacidad de cálculo a la memoria misma. La propuesta, ahora bajo evaluación, apunta a integrar núcleos de GPU en el base die de las pilas de memoria HBM. Esto permitiría ejecutar operaciones de procesamiento en la propia pila, reduciendo la necesidad de mover físicamente los datos al procesador principal. En los grandes centros de datos de inteligencia artificial, donde el movimiento continuo de datos entre la memoria y el procesador representa un gran consumo energético y un cuello de botella, esta estrategia podría proporcionar significativos beneficios en términos de eficiencia y rendimiento.

Sin embargo, llevar esta idea a la práctica enfrenta desafíos técnicos significativos. El proceso de fabricación de HBM, limitado por el espacio y preocupado por el consumo y disipación de calor, requiere superar obstáculos de diseño y producción complejos. No obstante, el involucramiento de Meta, NVIDIA, SK hynix y Samsung en esta exploración sugiere que están dispuestos a enfrentar estos retos, señalando un cambio estratégico en el sector.

Desde una perspectiva más amplia, esta iniciativa refleja una transformación en el panorama de la industria de semiconductores, especialmente para Corea del Sur. Si SK hynix y Samsung logran integrarse completamente en este nuevo paradigma, podrían posicionarse como actores clave en la industria de la inteligencia artificial, más allá de su rol tradicional en la fabricación de memoria. No obstante, la incapacidad para adaptarse a estas nuevas especializaciones podría dejarlos en desventaja frente a los grandes diseñadores de sistemas.

En conclusión, la línea que separa la memoria de la lógica computacional se está desvaneciendo rápidamente. A medida que la demanda de inteligencia artificial se intensifica, la necesidad de combinar memoria y lógica en soluciones integrales se vuelve fundamental. Si bien estos desarrollos están todavía en fases iniciales de estudio, su potencial para remodelar el futuro de los chips de inteligencia artificial es innegable, prometiendo un nuevo capítulo en la relación entre memoria y procesamiento en la era de la computación avanzada.