En el emocionante campo de la inteligencia artificial, el ajuste fino de modelos base ha emergido como una técnica crucial para mejorar la precisión y especificidad de estos modelos en distintos dominios. Un reciente experimento ha puesto de relieve la eficacia de este enfoque al emplear Amazon SageMaker Autopilot y el SDK AutoMLV2. El objetivo: ajustar un modelo Meta Llama2-7B para efectuar tareas de respuesta a preguntas en exámenes de ciencias, cubriendo áreas como física, química y biología.

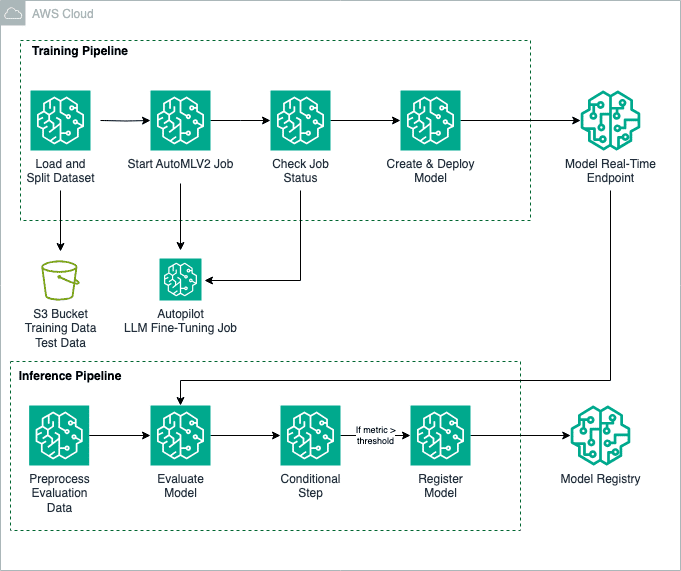

Este proceso trasciende la simple respuesta a preguntas, abriendo la puerta a aplicaciones en la generación de resúmenes y textos en sectores como la salud, educación y finanzas. Con la ayuda de AutoMLV2, es posible instruir y afinar una amplia gama de modelos base a través de Amazon SageMaker JumpStart. Asimismo, Amazon SageMaker Pipelines automatiza las diversas etapas del flujo de trabajo, facilitando desde la preparación de los datos hasta la creación final del modelo.

Para entrenar el modelo Llama2-7B, se utiliza el conjunto de datos SciQ, especializado en preguntas de examen de ciencias. Este conjunto es adaptado a un formato compatible con SageMaker Autopilot, mediante archivos CSV que categorizan las entradas y salidas: las preguntas y las respuestas correctas.

El proceso de ajuste fino requiere la configuración de una serie de parámetros como el nombre del modelo base y la aceptación de los contratos de licencia para usuario final. Los hiperparámetros, como el número de épocas y la tasa de aprendizaje, juegan un papel crucial al optimizar el aprendizaje del modelo, permitiendo personalizar su entrenamiento según las necesidades del problema abordado.

Una vez afinado, el modelo se despliega en un punto de inferencia en tiempo real, lo que permite generar resultados inmediatos. Su efectividad se evalúa mediante la biblioteca fmeval, que proporciona una valoración meticulosa basada en métricas adaptadas a cada caso, asegurando un rendimiento óptimo en entornos reales.

Este enfoque no solo incrementa la precisión de los modelos en sus tareas designadas, sino que también simplifica su implementación y evaluación, mejorando el despliegue en plataformas de producción. Además, se lleva a cabo un control de calidad riguroso para garantizar que únicamente los modelos de alto rendimiento sean registrados y desplegados.

En resumen, este flujo automatizado representa un avance significativo hacia la eficiente implementación de modelos de lenguaje a gran escala. Su integración más fluida en sistemas que requieren inferencias precisas y relevantes en tiempo real, marca un hito en la tecnología de inteligencia artificial aplicada a la vida cotidiana.