La expansión de la inteligencia artificial generativa en el ámbito empresarial ha estimulado el desarrollo de soluciones creativas para satisfacer la demanda de integración en los negocios. Un enfoque emergente y prometedor es el uso de modelos de lenguaje de gran escala preentrenados, facilitados a través de plataformas avanzadas como Amazon Bedrock. Este servicio se posiciona como una herramienta esencial para las empresas, ofreciendo la flexibilidad necesaria para seleccionar el modelo que se alinee mejor con sus requerimientos específicos.

Amazon Bedrock no solo ofrece acceso a una gama de modelos de vanguardia desarrollados por diversas startups y la propia Amazon, sino que permite a las empresas personalizarlos. Esta capacidad es especialmente crítica en tareas complejas que demandan formatos específicos. La personalización se logra mediante el ajuste fino de los modelos, un proceso que utiliza datos etiquetados con precisión para optimizar el desempeño en contextos particulares. No obstante, la recopilación de datos relevantes y su mantenimiento en términos de calidad continúan siendo un desafío significativo.

La generación de datos sintéticos ha surgido como una solución eficaz, permitiendo crear conjuntos de datos de entrenamiento sin la necesidad de grandes recursos. Estos datos sintéticos se crean usando modelos de lenguaje robustos que aceleran el tiempo de respuesta y solucionan la limitación de los datos disponibles. Amazon Bedrock facilita este enfoque al permitir la generación y el ajuste fino del modelo a través de datos sintéticamente producidos.

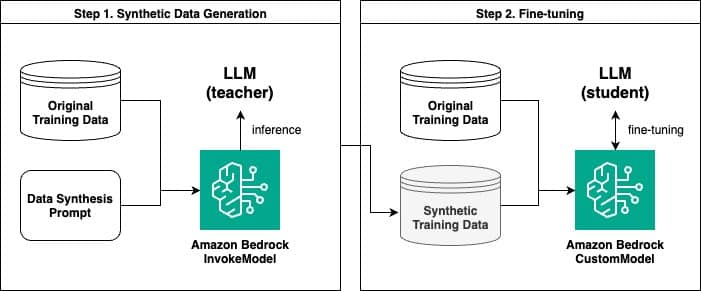

El procedimiento consiste en dos etapas cruciales: la creación de datos sintéticos mediante la API InvokeModel de Amazon Bedrock y el posterior ajuste fino del modelo personalizado. En una investigación reciente, se destacó cómo este proceso puede optimizar un modelo de lenguaje mediante la generación de pares sintéticos de preguntas y respuestas. Un modelo más grande opera como un «maestro», proporcionando el contexto necesario para entrenar un modelo más pequeño denominado «estudiante», en un método que recuerda la técnica de destilación de conocimiento típica del aprendizaje profundo.

Se llevaron a cabo comparaciones entre modelos afinados con datos originales frente a aquellos optimizados con datos sintéticos. Los resultados fueron reveladores: en muchos casos, los modelos afinados con datos sintéticos mostraron un rendimiento superior, aun cuando no siempre superaron a los entrenados con grandes volúmenes de datos originales.

La evaluación de modelos mediante un enfoque llamado «LLM como juez» se implementa para valorar la calidad de las respuestas de los modelos. Este método demostró que los modelos afinados con ejemplos sintéticos frecuentemente destacaban por su rendimiento.

En resumen, la estrategia de usar Amazon Bedrock para genera datos sintéticos y personalizar modelos se revela como una solución potente ante la limitada disponibilidad de datos originales, ofreciendo una vía rentable para la personalización de modelos de lenguaje. Estas innovaciones son esenciales para las empresas que buscan ventajas competitivas a través de la inteligencia artificial, permitiéndoles no solo avanzar con eficiencia sino también con un enfoque económico y sostenible en su transformación digital.