La inteligencia artificial generativa continúa transformando diversas industrias, apuntalando la importancia de la optimización efectiva de los prompts. Este proceso, conocido como ingeniería de prompts, implica elaborar entradas precisas para los modelos de IA, seleccionando cuidadosamente palabras, frases, oraciones, puntuación y caracteres separadores. Este refinamiento es esencial para maximizar la calidad de los resultados, reducir el tiempo de respuesta y controlar los costos. Un prompt bien diseñado incrementa significativamente las probabilidades de obtener respuestas satisfactorias de los modelos de IA generativa.

La evaluación de prompts figura como un componente crucial en este proceso de optimización, aunque muchas organizaciones enfrentan desafíos constantes al crearlos y evaluarlos. Este obstáculo puede resultar en un rendimiento inconsistente de las aplicaciones basadas en IA, afectando la calidad de las respuestas y la experiencia del usuario final. Para superar estas dificultades, la implementación de un sistema automatizado de evaluación de prompts utilizando Amazon Bedrock se revela como una solución prometedora.

Amazon Bedrock ofrece herramientas como Prompt Management y Prompt Flows para facilitar la evaluación sistemática de prompts en aplicaciones de IA generativa. Este artículo explora cómo utilizar estas herramientas para optimizar continuamente los prompts y mejorar la calidad del contenido generado.

La evaluación de prompts tiene varios aspectos clave:

- Garantía de calidad: Asegurar que las aplicaciones de IA generen respuestas relevantes y de alta calidad.

- Optimización del rendimiento: Refinar prompts para mejorar la eficiencia y reducir la latencia de los modelos de IA.

- Eficiencia de costos: Utilizar recursos de IA de manera eficiente, potenciando modelos más pequeños y económicos sin comprometer la calidad.

- Experiencia del usuario: Prompts mejorados proporcionan contenido más preciso y personalizado, mejorando la experiencia del usuario.

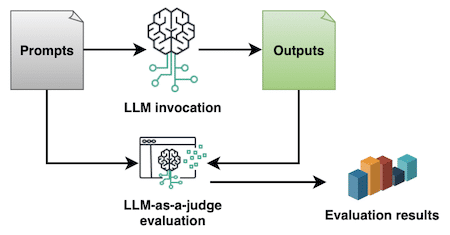

Para evaluar los prompts, el método conocido como LLM-as-a-judge permite usar un modelo de lenguaje grande (LLM) para evaluar las respuestas generadas en base a criterios predefinidos. Esta técnica cuantifica las evaluaciones en puntajes numéricos, estandarizando y automatizando el ciclo de vida de los prompts en la organización.

La implementación de este sistema con Amazon Bedrock incluye varios pasos:

- Acceso a Amazon Bedrock: Se requiere una cuenta de AWS con permisos adecuados.

- Creación de prompts:

- En la consola de Amazon Bedrock, seleccionar "Prompt management" y crear un nuevo prompt.

- Definir el nombre y la descripción del prompt, enfocándose en la evaluación con LLM-as-a-judge.

- Definición de plantillas:

- Utilizar una plantilla que incluya criterios claros para la evaluación tanto del input como del output.

- Selección de modelos: Configurar un modelo como Anthropic Claude Sonnet para realizar las evaluaciones, asegurando un equilibrio entre calidad, tiempo de respuesta y costo.

- Configuración de inferencias: Ajustar parámetros como la temperatura para asegurar evaluaciones objetivas.

Finalmente, la configuración del flujo de evaluación a través de Amazon Bedrock Prompt Flows permite automatizar este proceso a gran escala. Este enfoque metodológico no solo mejora la calidad y consistencia de los contenidos generados, sino que también optimiza los recursos, potencia la eficiencia y enriquece la experiencia del usuario.

Se invita a las organizaciones a explorar estas capacidades y adaptar el proceso de evaluación de prompts a sus necesidades específicas, optimizando así el potencial de la IA generativa en sus aplicaciones.