A medida que la inteligencia artificial (IA) avanza, su implementación se ha extendido más allá de la computación en la nube hacia dispositivos edge, trayendo beneficios transformadores para diversas industrias.

La inferencia de IA en la computación edge implica ejecutar modelos de IA entrenados directamente en hardware local, como teléfonos inteligentes, sensores y dispositivos IoT, en lugar de depender de servidores en la nube remotos. Esta convergencia de IA y computación edge está revolucionando el procesamiento de datos, ofreciendo ventajas sin precedentes en términos de velocidad, privacidad y eficiencia.

Uno de los beneficios más notables es la capacidad de procesar datos en tiempo real. La computación edge permite el análisis directo en dispositivos locales, eliminando la latencia asociada con el envío de datos a servidores centralizados. Esta característica es crucial para aplicaciones que requieren respuestas inmediatas, como vehículos autónomos, automatización industrial y monitoreo de salud.

Además, mantener el procesamiento de datos cerca de su fuente refuerza la privacidad y seguridad. Transmitir datos sensibles a servidores en la nube presenta riesgos de seguridad, mitigados por la computación edge, que minimiza la transmisión de datos a través de redes vulnerables.

La reducción significativa en la transmisión de datos a la nube gracias al procesamiento local tiene varias implicaciones: menos congestión de la red y menores costos de ancho de banda para organizaciones y usuarios finales. Esta eficiencia disminuye la carga en la infraestructura de la red, resultando en ahorros sustanciales.

Los sistemas de IA en el edge son escalables, permitiendo el despliegue de dispositivos adicionales sin sobrecargar la infraestructura central y mejorando la resiliencia. En caso de fallos de red o servidores, los dispositivos edge pueden operar y tomar decisiones de manera autónoma, asegurando un servicio continuo.

En términos de eficiencia energética, los dispositivos edge están diseñados para minimizar el consumo de energía, siendo ideales para entornos donde este factor es crítico. Procesando inferencias de IA localmente, se reduce la necesidad de transmisión de datos intensiva, contribuyendo a ahorros energéticos.

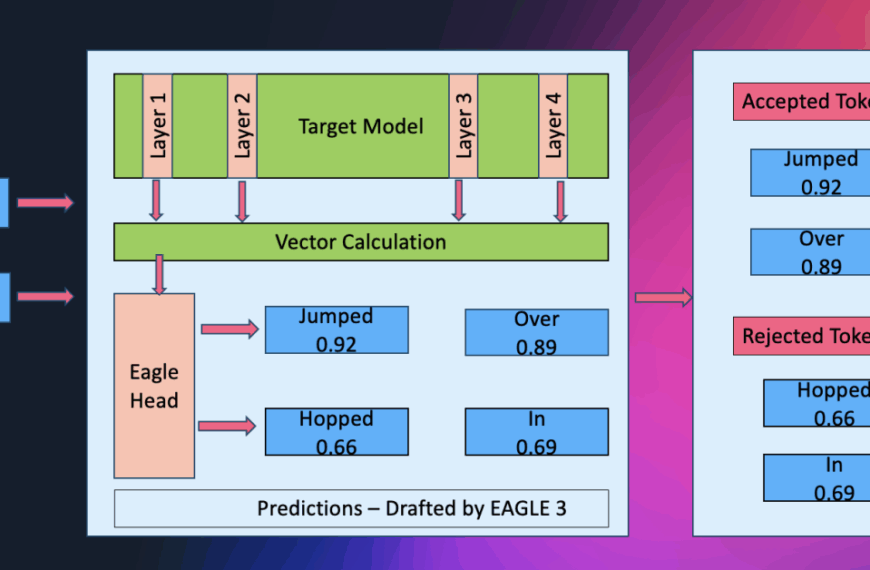

Los aceleradores de IA, como NPUs, GPUs, TPUs y ASICs personalizados, son fundamentales para una inferencia eficiente en el edge, manejando tareas computacionales intensivas con alto rendimiento y optimización energética.

El funcionamiento offline de la IA edge es esencial, especialmente en situaciones donde la conectividad a Internet no es constante. En áreas remotas o con acceso a red limitado, los sistemas de IA edge garantizan funcionalidad ininterrumpida, crucial para vehículos autónomos o sistemas de seguridad, al almacenar y registrar datos localmente cuando se pierde la conectividad.

La inferencia de IA en el edge también permite una alta personalización, procesando datos localmente y ajustándose a las necesidades individuales del usuario y al contexto ambiental en tiempo real. Los sistemas de IA pueden responder rápidamente a cambios en el comportamiento del usuario o en el entorno, ofreciendo servicios personalizados y mejorando la satisfacción del usuario y eficiencia del sistema.

La combinación de IA y computación edge está impulsando a múltiples industrias hacia la toma de decisiones en tiempo real, mejorando seguridad y optimizando recursos. A medida que la tecnología continúa evolucionando, sus aplicaciones se ampliarán, fomentando la innovación y eficiencia.

Sin embargo, persisten desafíos relacionados con la precisión y rendimiento de los modelos de IA en el edge. Asegurar el funcionamiento fiable y efectivo de estos sistemas es una prioridad en la investigación y desarrollo actuales. La adopción extendida de la IA edge en diversas industrias resalta la necesidad de superar estos desafíos, estableciendo nuevas normas de eficiencia y robustez en el despliegue de IA edge.

vía: AI Accelerator Institute